Adaptive lineare Transformationen AS-1 Rüdiger Brause: Adaptive Systeme, Institut für Informatik,...

-

Upload

anneken-stolper -

Category

Documents

-

view

228 -

download

0

Transcript of Adaptive lineare Transformationen AS-1 Rüdiger Brause: Adaptive Systeme, Institut für Informatik,...

Lernen und Klassifizieren

Adaptive lineare TransformationenAS-1

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 2 -Lineare SchichtenSequenz linearer Schichteny(1) = A x(1)y(2) = B x(2) ...y(n) = Z x(n)y(n) = ZBAx(1)y(n) = M x(1)

ZBAx(1)yM

Sequenz linearer Schichten = wie nur 1 Schicht !

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 3 -Hebbsches LernenDw = wi(t)-wi(t-1) = i(t) yix Iterative Hebb'sche Lernregel DW = W(t)-W(t-1) = (t) yxTW = W(1) + W(2) + W(3) +

Problem: nur anwachsend, ex. kein Vergessen, w Unendliches Wachstum ??

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 4 -Hebbsches Lernen - ErgnzungenLsung : Normierung der Gewichtew(t) = w(t-1) + (t) yx mit |w(t)| = 1Wie? (t) = (t-1) + (t) yx w(t) = ____= (t-1) + (t) yx | | | |

Wohin konvergiert w(t) ?Rechnung Eigenvektoren der Autokorrelationsmatrix Cxx:= xxT !

Kovarianz und AutokorrelationKovarianz zwischen zwei Variablen x, y Cxy =

=Autokorrelation zwischen Komponenten von xA = xxT = (aij), aij = xixjx =

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 5 -

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011PCA-NetzePCA-TransformationTransform CodingICA-TransformationWeissen- 6 -

6Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 7 -

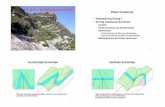

Principal Component Analysis PCAZerlegung in orthogonale Eigenvektoren = BasisvektorenHauptkomponentenanalyse, principal component analysis,Karhunen-Love-Entwicklung, Hotelling-Transformation,...Eigenvektoren Wozu?e1e2 Merkmals-transformationauf Hauptrichtungen

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 8 -Principal Component Analysis PCATransformation auf Unkorreliertheit Beispiel

(x1-x1)(x2- x2) = 0Unkorrreliertheit von x1,x2Rauschfrei korrelierte Daten x = (x1,x2) mit x2 = ax1

Rechnung: EV, EW = ?

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 9 -Transformation mit minimalem MSEBeispiel: Sprachkodierung

Zeit x1 x2 x3 x4 x5 x6 x7 x8 x9 x10Filter 1Filter 6Filter 7Filter 8Filter 9Filter 10Filter 2Filter 3Filter 4Filter 5x(t)FouriertranformationSignalanteil in FrequenzbereichenMerkmalsvektor

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 10 -

Transformation mit minimalem MSEBeispiel: SprachkodierungTransformation (Rotation) des Koordinatensystems auf HauptachsenVernachlssigung der Anteile des 2. Kanals: Ersatz des zweiten Kanals durch erstene2e1x1x2

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 11 -R(W) = min (x- )2 least mean squared error (LMSE) Transformation mit minimalem MSEAllgemeine Situation

. l i n . T r a n s f o r m a t i o n W x x 1 x n X { y}..1y my Ym+1..Y nWann minimal ?

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 12 -Transformation mit minimalem MSEWas ist die beste Schtzung fr die Konstanten ci?min R(ci) = ?Rechnung!R(W) = min (x- )2 least mean squared error (LMSE)

Minimaler RekonstruktionsfehlerBei welchen Basisvektoren wi ist der Fehler minimal ?min R(wi) = ? Rechnung!yi = xTwi

+ x =

+ =

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011PCA-NetzePCA-TransformationTransform CodingICA-TransformationWeissen- 13 -

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 14 -Transform coding Wozu?Verlustfreie Kodierung: Max 1:2 (Zip). Unntig beiTelekommunikation (z.B. Bildtelefon)Satellitenbertragung (z.B. Wettersatelliten etc.)Bilddatenbanken (z.B. Umweltdaten, Medizindaten, Industrieteile, Teleshopping etc.)Digitale Musik (MP3)Hochauflsendes Fernsehen (HDTV)Allgemein: Multi-Media Daten (MPEG 7)

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 15 -Konzept Transform CodingKodierung und DekodierungAnhang C Kodierung bertragung, Dekodierung Speicherung lin. TransformationVektor- codebook lin. Transformationxnx1ynymy1ym+1ymy1^xn^x1quantisierung ookup Klassenprototypen

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 16 -Aufteilung in UnterblckeKodierung und Dekodierungx12....n Yy1ymJPEG, MPEG Blockgre: 8x8 Pixel SW 16x16 Pixel FarbeSchicht

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 17 -Transform CodingKodierung: 256x256 Pixel, 8 Bit Grauwert, 32x32 Unterbilder, je 8x8=64 Pixel, 8 Neuronen. Kompression = ?

e1 e2 e3 e4 e5 e6 e7 e8

Kodierung in 0,36 Bits/Pixel statt 8= Kompression mit Faktor 22und Dekodierung:

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 18 -Eigenschaften natrlicher BilderFehler beim Vernachlssigen hh. Komponentenn = 256256 = 65536 Komponenten Cxx(x-x`) =

Bildmodellierung durch Pixelkorrelationen

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 19 -Eigenvektoren und EigenfunktionenKomponentenindex iKomponente

12345678w1w2w3w4w5w6w7w8Basisfunktion j(i)wi = w(i) = (i)Min. Fehler Eigenvektoren. Und im kontin. Fall?Eigenvektor w = diskretisierte Eigenfunktion (w)

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 20 -kont. EigenwertgleichungAw = 12w A = (x1(i)x2(j)) der Bilder w(x1,x2)

C(x1,x2,x1',x2') (x1',x2') dx1' dx2' = 12(x1,x2) C(x1,x2,x1',x2') = C(x1,x1') C(x2,x2')(x1,x2) = (x1)(x2), 12 = 12 ``(x) + (22)(x) = 0 Separierbare Korrelationen Zwei 1-dimensionale Differentialgleichungen Separierbare Basisfunktionen

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 21 -Transform CodingLsungen: Eigenfunktionen mit Eigenfrequenzen biN/2i(x) = a cos(bi(x-N/2)) mit i=

wobei bi tan(biN/2) =1

N=8,=0,125, =0,249

11(x)

12(x)e1 e2 e3 e4 e5 e6 e7 e8

Beispiel: BildkodierungEigenfunktion coding vs. Kosinustransformation (JPEG)Eigenfunktion 1-dim

Eigenfunktionen bei abfall. Korrelation

Kosinus

12345678i(x) = a cos(bi(x-N/2))EF fr Parameter a,b ~ mittl. Bildidentisch mit cos bildunabh. Kodierung- 22 -Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011PCA-NetzePCA-TransformationTransform CodingICA-TransformationWeissen- 23 -

EINE Lernregel fr Hebb-Lernen und Gewichtsnormierung1. Hebb-Regel w(t) = w(t-1) + (t) yx2. Normierung wi(t) Einsetzen 1. in 2. w(t-1) + (t) yx[i(wi(t-1)+xiy)2]1/2

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 24 -Oja-Lernregel

Terme mit 2 vernachlssigen ergibtw(t) = w(t-1) + (t) y [x(t) w(t-1)y] Oja Lernregel xneuund f() in einer Taylorreihe nach entwickeln.

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 25 -PCA Netze fr den UnterraumOja-Netzx1xn Y1ym xyw(t) = w(t-1) + (t) y [x(t) w(t-1)y] Oja Lernregelwi(t) = wi(t-1) + (t) yi[x(t) x]x = wi(t-1)yi

Ansatz: Zielfunktion R(w) = (x- )2 minimieren

Konvergenzziel: Unterraum der EV mit grtem EW

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 26 -PCA Netze fr geordnete ZerlegungSanger-MethodeSanger 1988Vollstndige Zerlegung von {x} in n Eigenvektoren (Gram-Schmidt) {x}0 = {x}, i=1Suche die Richtung grter Varianz in {x}i-1. Dies ist ei.Ziehe diese Richtung (Dimension) von {x}i-1 ab. Wir erhalten {x}i .Wenn i M-1 PUnbekannte Skalierung si := 12 Gausche Quellen lassen sich nicht trennen max 1 Gausche Quelle

Erzeugung einer VerteilungErzeugen der NormalverteilungProblem:Verteilungsfkt. hat keine analyt. Lsung, nur tabelliert Inverse Funktion ex. nichtLsung: berlagern von VerteilungenNutzung des Zentralen Grenzwertsatzes: x(n) = N(0,1) mit x(n) = mit beliebig verteilten Xi und gemeinsamen m = Xi und Xi uniform aus U(-1/2 ,1/2) N(0,1) durch n = 12 R.Brause, Adaptive Modellierung Kap.5: Simulation - 39 -

R.Brause, Adaptive Modellierung Kap.5: Simulation - 40 -Erzeugung einer Normalverteilung

pi = p(xmn=i)

picpiapib0255 ixmn = xamn+ xbmn+ xcmn++=

40Das Histogramm des Mischbildes ist NICHT die normierte Summe der Histogramme.Stattdessen haben wir hier die Verteilung einer Zufallsvariablen, bei der jeweils eine Summe aus drei zuflligen Pixelwerten gebildet wird, die unabhngig von einander sind.Dieses Experiment wird n = 640x480=307.200 mal wiederholt. ICA SystemberblickIndependent Component Analysis (ICA)urschl.beobachtete VariablenEinflsse (Mischgerusche)InteraktionderUrsachenInteraktionderUrsachenSprecherMusikerschlosseneEinflsseEntkopplungEntkopplungModellPara-meterSprecherMusikTrennung unbekannter QuellenRdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 41 -

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 42 -DEF InformationI ~ n = ld(2n) = ld (Zahl der mglichen Daten) I ~ ld(1/P)[Bit] DEF I(X) := ln(1/P(xk)) = ln(P(xk)) InformationDEFH(X) := k P(xk)I(xk) = I(xk)k Entropie H(X) :=

p(x) ln p(x)-1dx differenzielle Entropie Frage: Wieviel Information hat eine 32-bit floating-point Zahl?

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 43 -DEF TransinformationDEFH(X,Y) = H(X) + H(Y) I(X;Y) Verbundentropie Transformation H(X) H(Y) x1 y1 Transinformation Rauschen Redundanz Rauschen Redundanz nxnyDEFI(X;Y) = H(X) + H(Y) H(X,Y) Transinformation

Die Verbundentropie ist H(X,Y) = H(X) + H(Y) I(X;Y), was auf die Verbundwahrscheinlichkeiten zurckzufhren ist. Dabei verringert sich die Entropie (Unbestimmtheit) um den Informationsanteil, der bertragen wird.Die Transinformation kann als eine spezielle Informationsdivergenz (oder Kullback-Leibler Abstand) gesehen werden; hierbei ist q(X,Y) = q(X)q(Y).43Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 44 -Ziel: minimale Transinformation zwischen den Ausgaben yi x = Kanle, stoch. Variablen

Transinformation I(x1;x2) = H(x1) + H(x2) H(x1,x2)minimal bei I(x1;x2) = 0 bzw. maximaler Entropie H(x1,x2) = H(x1) + H(x2)bzw. p(x1,x2) = p(x1)p(x2) stochastische Unabhngigkeit der Variablen

ICA - Algorithmen 1 - W(t+1) = W(t) I(y1;y2;..;yn)Gradientenabstieg(Amari, Young, Cichocki 1996)Entwicklung von p(y1,y2,..,yn) in I(y1;y2;..;yn) nach hheren MomentenW(t+1) = W(t) (1-f(y)yT)W(t) mit fi(yi) =

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2009- 45 -ICA Anwendung: Audioanalyse

2 Sprechermixed sources demixed sourcesCoctail-Party-EffektRdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 45 -

FRAGEWodurch werden die Quellen bei der Informationsmethode getrennt?

Durch maximale Transinformation zwischen den AusgabevariablenDurch maximale Entropie der AusgabenDurch minimale Transinformation zwischen den AusgabevariablenDurch minimale Verbundentropie der AusgabekanleRdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 46 -

46Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 47 -Momente einer Zufallsvariablen x : ak= xk z.B. a1 = x MittelwertZentrale Momente einer Zufallsvariablen x: mk= (x-a1)k, z.B. m2 = (x-a1)2 VarianzWlbungsma Kurtosis: kurt(x) = [(x-a1)4 -3m22]/m22Statist. Momente und KurtosisSupergaussian: Kurtosis > 0 Gaussian: Kurtosis = 0 Subgaussian: Kurtosis < 0

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 48 -ICA-Algorithmen: VorverarbeitungsfolgeZentrierenMittelwertbildung, z.B. iterativ durch w0(t+1) = w0(t) - g (w0-x), g =1/tWeienPCA durchfhren: wi Eigenvektoren von C = xxT mit |wi|=1 und Eigenwerten liGewichtsvektoren wi normieren zu wi/li1/2. Dies fhrt zu y2 = wiTxxTwi = wiTliwi = 1EntmischenICA Algorithmen, z.B. minimale Transinformation, maximale Kurtosis etc.Speziell: dekorrelierte x bentigen nur eine orthogonale Matrix W (Vereinfachung)Ms1s2 snx1x2

xnx-xy1y2 ynBQuellenmix zentrieren weien entmischenWx=0(x-x)2=1

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 49 -Ziel: extremale Kurtosis (Delfosse, Loubaton 1995)Extrema bei sj = unabh. Komp, und zj = +/-1 kurt (y) = kurt (wTv) = kurt(wTMs) = kurt (zTs) = ICA Algorithmen 2

Ms1s2 snv1v2

vny1y2 yn Quellenmix zentrieren weien entmischenWvi=0(vi-vi)2=1Matrix Z

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 50 -ICA Algorithmen 2 Sequentielle Extraktion aller KomponentenGegeben: Trainingsmenge {v(0)} Fixpunktalgorithmusw1(t+1) = (w1Tv)3v 3 w1 mit |w1| = 1 Konvergenz zum 1. ICA-Vektor. (Hyvarinen, Oja 1996)Dann neue Trainingsmenge durch v(1) = v(0) w1y1w2(t+1) = (w2Tv)3v 3 w2 mit |w2| = 1 Konvergenz zum 2. ICA-Vektor, usw. Schnellere Konvergenz: Orthogonalisierungwi(t+1) = wi(t) - (wi wj) wj j < i

Orthogonalisierung erspart aber auch die neue TRainingsmenge!

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 51 -ICA-Anwendungen: BildprimitiveZerteilung von Naturbildern in 12x12 Unterbilder = 144 Kanle = 1 SampleUnabhngige Komponenten(Filter-Koeff.)Alternative Analyseverfahren

Bell, Sejnowski (Vision Research 1996)

Gewichtsmatrix(d) Weissmatrix x Gewichtsmatrix51Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 52 -ICA Anwendung: Bildentmischung4 Bilder, sequentiell gerastert = 4 Quellen(Hyvarinen, Oja 1996)4 Bilder 4 Kanle 4 Mischbilder4x4Misch-matrix AAutomatische Entmischung ?

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 53 -ICA Anwendung: Bildentmischung4 Bilder, sequentiell gerastert = 4 Quellen (Hyvrinen, Oja 1996)

Mischbilderentmischte Bilder

Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 54 -ICA-EEG-FilterungKorrigierte EEG-Aufnahmen ohne 5 ICA-Muskelaktivitten, Mischung

54Also: ICA ist geeignet, um EEG-Artefakte zu unterdrcken.

Kann man dadurch die Ursachen, die Quellen der Gedanken entdecken ?Dies knnte man meinen, aber ....Rdiger Brause: Adaptive Systeme, Institut fr Informatik, WS 2011- 55 -ICA-EEG-AnalyseEntmischte EEG-Aufnahmen: unabhngige Zentren, z.B. Muskelaktivitt

Augenbewegungen R-LMuskelaktivitt 1Augenbewegungen oben-untenMuskeln 2Muskeln 3Jung, Humphries, Lee, Makeig, McKeown, Iragui, Sejnowski 1998

SEITE - 1 -

XE "In" x1

x2

PAGE - 1 -

XE "In" PAGE - 2 -

XE "In" PAGE - 1 -

PAGE - 2 -

XE "In" PAGE - 1 -

(2

m XE "In"

SEITE

- SEITE 1 -

PAGE - 1 -

EMBED CorelDraw.Graphic.7

_1258889935.unknown

SEITE

- SEITE 1 -

SEITE

- SEITE 1 -

SEITE

- SEITE 1 -

SEITE

- SEITE 1 -

SEITE

- SEITE 1 -