œbersetzerbau: Band 3: Analyse und Transformation

Transcript of œbersetzerbau: Band 3: Analyse und Transformation

eXamen.press

eXamen.press ist eine Reihe, die Theorie undPraxis aus allen Bereichen der Informatik fürdie Hochschulausbildung vermittelt.

123

Helmut Seidl Reinhard Wilhelm

Übersetzerbau

·Sebastian Hack

·

Band 3: Analyse und Transformation

Helmut SeidlTechnische Universität MünchenInstitut für Informatik – I2Boltzmannstr. 385748 [email protected]

Sebastian HackUniversität des SaarlandesFB Informatik66041 Saarbrü[email protected]

Reinhard WilhelmUniversität des SaarlandesFB Informatik66041 Saarbrü[email protected]

Das vorliegende Buch ist als Neuauflage aus dem Buch Wilhelm, R.; Maurer, D. Übersetzerbau:Theorie, Konstruktion, Generierung hervorgegangen, das in der 1. Auflage (ISBN 3-540-55704-0) undder 2. Auflage (ISBN 3-540-61692-6) im Springer-Verlag erschien.

ISSN 1614-5216ISBN 978-3-642-03329-2 e-ISBN 978-3-642-03331-5DOI 10.1007/978-3-642-03331-5Springer Heidelberg Dordrecht London New York

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie;detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.de abrufbar.

c© Springer-Verlag Berlin Heidelberg 2010Dieses Werk ist urheberrechtlich geschützt. Die dadurch begründeten Rechte, insbesondere die derÜbersetzung, des Nachdrucks, des Vortrags, der Entnahme von Abbildungen und Tabellen, derFunksendung, der Mikroverfilmung oder der Vervielfältigung auf anderen Wegen und der Speicherungin Datenverarbeitungsanlagen, bleiben, auch bei nur auszugsweiser Verwertung, vorbehalten. EineVervielfältigung dieses Werkes oder von Teilen dieses Werkes ist auch im Einzelfall nur in den Grenzender gesetzlichen Bestimmungen des Urheberrechtsgesetzes der Bundesrepublik Deutschland vom 9.September 1965 in der jeweils geltenden Fassung zulässig. Sie ist grundsätzlich vergütungspflichtig.Zuwiderhandlungen unterliegen den Strafbestimmungen des Urheberrechtsgesetzes.Die Wiedergabe von Gebrauchsnamen, Handelsnamen, Warenbezeichnungen usw. in diesem Werkberechtigt auch ohne besondere Kennzeichnung nicht zu der Annahme, dass solche Namen im Sinneder Warenzeichen- und Markenschutz-Gesetzgebung als frei zu betrachten wären und daher vonjedermann benutzt werden dürften.

Satz: Druckfertige Daten der AutorenUmschlaggestaltung: KünkelLopka Werbeagentur, Heidelberg

Gedruckt auf säurefreiem Papier

Springer ist Teil der Fachverlagsgruppe Springer Science+Business Media (www.springer.com)

Vorwort

Übersetzer für Programmiersprachen müssen nicht nur Programme der Quellspra-che korrekt in Programme der Zielsprache, meist einer Maschinensprache, überset-zen. Darüber hinaus sollen sie häufig auch noch möglichst guten Code erzeugen.Als eine Entwicklermannschaft der IBM unter der Leitung von John W. Backus inden frühen 50er Jahren den ersten Übersetzer für die Programmiersprache FORT-RAN entwarf und realisierte, war der Zielrechner nach heutigen Maßstäben extremklein und extrem langsam. Deshalb ist es kein Wunder, dass die Idee einer optimie-renden Übersetzung aufkam. Diese sollte die bescheidenen Maschinenressourcen sogeschickt wie möglich ausnutzen.

Als imperative Programmiersprache war FORTRAN vor allem für numerischeBerechnungen gedacht. Für diesen Zweck bietet FORTRAN als wichtigste Sprach-konstrukte Felder zur Speicherung von Vektoren und Matrizen an und Schleifen,um Algorithmen darauf zu formulieren. Felder und Schleifen bieten einen großenSpielraum für Programmtransformationen zur Verbesserung der Effizienz. In FORT-RAN sind Felder strukturell recht nahe an den mathematischen Objekten, die manin ihnen speichert. Elemente eines multidimensionalen Felds werden durch mehrfa-che Indizierung mit ganzzahligen Ausdrücken ausgewählt, was zu relativ komplexenAdressberechnungen führt. Einfache numerische Algorithmen verwenden anderer-seits häufig identische Indexausdrücke an unterschiedlichen Stellen des Programms,wofür eine naive Codeerzeugung immer die gleichen Berechnungsfolgen erzeugenwürde. Ebenfalls sehr verbreitet sind Schleifen, bei deren Durchlauf die Indizierungmit konstanter Schrittweite weiter geschaltet wird. Solche Beobachtungen gaben denÜbersetzerbauern Hinweise, wo Optimierungen ansetzen könnten. Sehr bald wurdenTransformationen zur Steigerung der Ausführungseffizienz vorgeschlagen. Unvor-sichtig angewendet, verändern diese jedoch die Semantik des Programms. Deshalbmussten die genauen Voraussetzungen geklärt werden, unter denen die Transforma-tionen überhaupt anwendbar sind. In der Regel hängt die Anwendbarkeit von globa-len Eigenschaften des Programms ab, welche durch eine statische Analyse im Über-setzer ermittelt werden müssen.

Dies war die Geburtsstunde der Datenflussanalyse. Der Name kommt wohl da-her, dass diese Analysen den Fluss von Eigenschaften der Variablenwerte von Pro-

grammpunkt zu Programmpunkt untersuchten. Die Theorie zur statischen Analysevon Programmen konnte erst in den 70er Jahren entwickelt werden, als die Seman-tik von Programmiersprachen auf eine solide mathematische Grundlage gestellt war.Den größten Einfluss hatten die beiden Dissertationen von Gary A. Killdall (1972)und von Patrick Cousot (1978). Gary Kildall klärte die verbandstheoretischen Grund-lagen der Datenflussanalyse. Patrick Cousot stellte die entscheidende Beziehung zurSemantik der Programmiersprache her und nannte deshalb die statische Analyse ab-strakte Interpretation. Sein Ansatz ermöglichte es, die Korrektheit statischer Analy-sen zu beweisen und sogar Analysen zu entwerfen, die schon auf Grund ihrer Kon-struktion korrekt sind.

Die Ursprünge von Datenflussanalyse wie von abstrakter Interpretation liegen al-so im Übersetzerbau. Allerdings hat sich die statische Programmanalyse längst vonihrer ersten Anwendung bei der Codeerzeugung emanzipiert und ist zu einer wich-tigen Verifikationsmethode geworden. Heute überprüfen statische Analysen Sicher-heitseigenschaften von Programmen, wie etwa die Abwesenheit von Laufzeitfehlern,oder weisen die partielle Korrektheit von Programmen nach. Sie berechnen Laufzeit-schranken für eingebettete Echtzeitsysteme oder ermitteln Synchronitätseigenschaf-ten nebenläufiger Programme und werden so mehr und mehr zu einem unverzichtba-ren Hilfsmittel bei der Entwicklung zuverlässiger Software.

Dieses Buch behandelt die Phase der Übersetzung, in der die Effizienz des Pro-gramms durch semantikerhaltende Transformationen gesteigert wird. Es stellt dienotwendigen Techniken der statischen Analyse vor. Neben den Analysen werdenauch die Transformationen auf präzise Weise beschrieben. Dazu wird eine kleineKernsprache mit einer einfachen operationellen Semantik eingeführt, auf die sichdie vorgestellten Analysen und Transformationen beziehen.

In dem Band Wilhelm/Seidl: Übersetzerbau – Virtuelle Maschinen wurde der An-spruch realisiert, mehrere Programmierparadigmen zu behandeln. In diesem Bandwerden deshalb neben Analysen und optimierenden Transformationen von impera-tiven Programmen auch solche von funktionalen Programmen beschrieben. Funk-tionale Sprachen basieren semantisch auf dem λ-Kalkül und weisen eine weit ent-wickelte Theorie der Programmtransformationen auf.

Wir wünschen unseren Lesern eine ertragreiche Lektüre.

München und Saarbrücken, im August 2009.

Helmut Seidl, Reinhard Wilhelm und Sebastian Hack

VI Vorwort

Allgemeine Literaturhinweise

Die Liste der Monographien, die einen Überblick über Techniken zu statischer Pro-grammanalyse und abstrakter Interpretation geben, ist erstaunlich kurz. Das Buchvon Matthew S. Hecht [Hec77], das die klassischen Ergebnisse zur Datenflussana-lyse zusammenfasst, ist immer noch lesenswert. Der Sammelband von Steven S.Muchnick und Neil D. Jones wenige Jahre später enthält viele originale und ein-flussreiche Beiträge zur Analyse rekursiver Prozeduren und dynamischer Daten-strukturen [MJ81]. Einen ähnlichen Sammelband speziell für deklarative Sprachenhaben Samson Abramsky und Chris Hankin herausgegeben [AH87]. Eine umfassen-de, moderne Darstellung bieten Flemming Nielson, Hanne Riis Nielson und ChrisHankin [NNH99].

Eine Reihe umfassenderer Dastellungen des Übersetzerbaus enthalten ausführli-che Kapitel über Datenflussanalyse [AG04, CT04, ALSU07]. Sehr ausführlich wirddieses Thema auch in Steven S. Muchnick’s Monographie “Advanced Compiler De-sign and Implementation” [Muc97] behandelt. Das Handbuch zum Übersetzerbau,herausgegeben von Y.N. Srikant und Priti Shankar [SS03], behandelt ausführlichCodeerzeugungstechniken für verschiedene Architekturen, bietet aber auch Kapitelüber Datenflussanalyse, Shape-Analyse und spezielle Techniken für objektorientierteProgrammiersprachen.

Die Entwicklung beweisbar korrekter Übersetzer [Ler09, TL09] hat in den letz-ten Jahren auch zu verstärktem Interesse an Korrektheitsbeweisen für Programmop-timierungen geführt. Techniken zur systematischen Ableitung korrekter Programm-transformationen stellen Patrick und Radia Cousot [CC02] vor. Automatisches Be-weisen der Korrektheit optimierender Transformationen behandeln Sorin Lerner[LMC03, LMRC05, KTL09].

VIIVorwort

Inhaltsverzeichnis

1 Grundlagen und intraprozedurale Optimierung . . . . . . . . . . . . . . . . . . . 11.1 Einführung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11.2 Vermeidung überflüssiger Berechnungen . . . . . . . . . . . . . . . . . . . . . . . 71.3 Exkurs: Eine operationelle Semantik . . . . . . . . . . . . . . . . . . . . . . . . . . 81.4 Beseitigung von Mehrfachberechnungen . . . . . . . . . . . . . . . . . . . . . . . 111.5 Exkurs: Vollständige Verbände . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 161.6 Kleinste Lösung oder MOP–Lösung? . . . . . . . . . . . . . . . . . . . . . . . . . . 271.7 Beseitigung von Zuweisungen an tote Variablen . . . . . . . . . . . . . . . . . 321.8 Beseitigung von Zuweisungen zwischen Variablen . . . . . . . . . . . . . . . 401.9 Konstantenfaltung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 431.10 Intervallanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 541.11 Aliasanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 681.12 Fixpunktalgorithmen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 831.13 Beseitigung teilweiser Redundanzen . . . . . . . . . . . . . . . . . . . . . . . . . . . 901.14 Anwendung: Schleifeninvarianter Code . . . . . . . . . . . . . . . . . . . . . . . . 971.15 Beseitigung teilweise toter Zuweisungen . . . . . . . . . . . . . . . . . . . . . . . 1021.16 Aufgaben . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1091.17 Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

2 Interprozedurale Optimierungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1152.1 Inlining . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1202.2 Beseitigung letzter Aufrufe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1222.3 Interprozedurale Analyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1242.4 Der funktionale Ansatz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1252.5 Interprozedurale Erreichbarkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1302.6 Bedarfsgetriebene interprozedurale Analyse . . . . . . . . . . . . . . . . . . . . 1312.7 Der Call-String-Ansatz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1342.8 Aufgaben . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1362.9 Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

X Inhaltsverzeichnis

3 Optimierung funktionaler Programme . . . . . . . . . . . . . . . . . . . . . . . . . . . 1393.1 Eine einfache funktionale Programmiersprache . . . . . . . . . . . . . . . . . . 1403.2 Einige einfache Optimierungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1413.3 Inlining . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1443.4 Spezialisierung rekursiver Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . 1463.5 Eine verbesserte Wertanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1483.6 Beseitigung von Zwischendatenstrukturen . . . . . . . . . . . . . . . . . . . . . . 1533.7 Verbesserung der Auswertungsreihenfolge: Die Striktheitsanalyse . . 1573.8 Aufgaben . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1653.9 Literaturhinweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 168

Literaturverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 171

Stichwortverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 175

1

Grundlagen und intraprozedurale Optimierung

1.1 Einführung

In diesem Abschnitt wollen wir einige grundlegende Techniken kennen lernen, mitdenen die Qualität des Codes, den der Übersetzer erzeugt, verbessert werden kann.Das Qualitätsmaß ist hierbei nicht a priori festgelegt. In diesem Buch werden wirvor allem daran interessiert sein, die Ausführungszeit des Programms zu verbessern.Andere Optimierungsziele könnten die Verringerung des benötigten Speicherplatzes,die Reduzierung des Stromverbrauchs oder auch die Verringerung der Lesbarkeit desProgramms („Obfuskierung“) sein.

Eine Strategie, um ein Programm effizienter zu machen, ist, überflüssige Berech-nungen zu vermeiden. Würde die Berechnung eines Ausdrucks mit garantiert glei-chem Ergebnis wiederholt, so kann der Übersetzer diese Wiederholung vermeiden,indem er dafür sorgt, dass das Ergebnis nach der ersten Berechnung abgespeichertwird. Dies ermöglicht es, eine (eventuell) teure Neuberechnung durch ein Nachschla-gen des Werts zu ersetzen.

Laufzeit kann ebenfalls eingespart werden, falls Teilberechnungen bereits zurÜbersetzungszeit ausgeführt werden können. Die Konstantenfaltung versucht, Aus-drücke, deren Werte bereits zur Übersetzungszeit bekannt sind, durch diese Werte zuersetzen. Diese Optimierung unterstützt einen Programmierstil, der mehrmals ver-wendete Programmkonstanten in Variablen mit sprechenden Namen ablegt, um dannalle Vorkommen der Konstanten durch den erhellenderen Variablennamen zu erset-zen. Die Konstantenfaltung vermeidet einen eventuell mit diesem Programmierstilverbundenen Laufzeitnachteil.

Auch Bereichseinschränkungen für die Werte von Variablen können von Nutzensein. Lässt sich zum Beispiel nachweisen, dass der Indexausdruck, mit dem auf einFeld zugegriffen wird, stets einen Wert hat, der innerhalb der Grenzen des Felds liegt,kann eine Überprüfung zur Laufzeit des Programms eingespart werden.

Eine weitere Idee besteht darin, Berechnungen aus einem Bereich, der sehr oftausgeführt wird, in einen Bereich zu verschieben, der seltener ausgeführt wird. Sowird der Übersetzer versuchen, eine Berechnung mit immer gleichem Wert aus ei-ner Schleife heraus zu ziehen. Schließlich kann der Übersetzer versuchen, teure Be-

H. Seidl et al., Übersetzerbau, eXamen.press, DOI 10.1007/978-3-642-03331-5_1,c© Springer-Verlag Berlin Heidelberg 2010

2 1 Grundlagen und intraprozedurale Optimierung

rechnungen durch äquivalente billigere zu ersetzen, z.B. eine Multiplikation in einerSchleife durch eine wiederholt ausgeführte Addition. Die Ersetzung von Funktions-aufrufen durch das Einkopieren des Rumpfs an die Aufrufstelle („Inlining“) ergibthäufig neue Möglichkeiten zur Anwendung von optimierenden Transformationen.

Wie wichtig bereits bei sehr einfachen Programmen Optimierungen sind, um ei-nigermaßen guten Code zu erzeugen, zeigt das folgende Beispiel.

Beispiel 1.1.1 Betrachten wir in einer imperativen Programmiersprache ein Pro-gamm, das ein Feld a sortieren soll. In diesem Program könnte es etwa die folgendeFunktion swap geben:

void swap ( int i, int j) {int t;if (a[i] > a[ j]) {

t ← a[ j];a[ j] ← a[i];a[i] ← t;

}}

Die Ineffizienzen dieser Implementierung liegen auf der Hand. Zuerst einmal müs-sen die Adressen a[i], a[ j] je dreimal berechnet werden. Das ergibt insgesamt sechsAdressberechnungen, wo bereits zwei genügen sollten. Dann werden die Wertea[i], a[ j] jeweils zweimal geladen. Das ergibt vier Speicherzugriffe, wo zwei aus-reichen sollten.

Diese Ineffizienzen können beseitigt werden, wenn wir eine Implementierungwählen, wie sie in der Programmiersprache C naheliegen würde. Hier ist die Idee,mithilfe von Zeigern auf die Elemente des Felds zuzugreifen und die mehrmals ver-wendeten Werte zwischenzuspeichern.

void swap (int ∗ p, int ∗ q) {int t, ai, a j;ai ← ∗p; a j ← ∗q;if (ai > a j) {

t ← a j;∗q ← ai;∗p ← t;

}}

Eine genauere Betrachtung dieser Funktion zeigt, dass in dieser Formulierung sogardie Hilfsvariable t eingespart werden kann.

Die zweite Formulierung ist offenbar effizienter. Die ursprüngliche Formulierungist jedoch erheblich intuitiver. Tatsächlich erwarten wir von einer vernünftigen Pro-grammiersprache, dass sie uns erlaubt, intuitive Programme zu schreiben, so wie wirvom Übersetzer erwarten, dass er für diese intuitiven Programme effizienten Codegeneriert. ��

1.1 Einführung 3

Optimierungen sind semantikerhaltende Programmtransformationen. Dies bedeutet,dass die Semantik des Programms von der Transformation nicht verändert wird. DieSemantik des Programms ist durch die Definition der Programmiersprache gegebenin der das Programm formuliert ist.

Beispiel 1.1.2 Betrachten wir die Transformation:

y ← f() + f(); ==⇒ y ← 2 ∗ f();

Die Idee dieser „Optimierung“ besteht darin, die Auswertung des zweiten Aufrufsder Funktion f einzusparen. Das Ergebnis dieser Transformation ist aber nur dannäquivalent zum Ausgangsprogramm, wenn die Funktion f beim zweiten Aufruf ga-rantiert das gleiche Ergebnis liefert und außerdem keine Seiteneffekte hat. In einerimperativen Programmiersprache kann das aber nicht unbedingt garantiert werden.��Programm-Verbesserungen sind damit also nicht unter allen Umständen korrekt. Zujeder effizienzsteigernden Transformation gehören i.A. Anwendbarkeitsbedingun-gen, d.h. hinreichende Bedingungen dafür, dass die Transformation die Semantikdes Programms erhält. Für diese Bedingungen werden Methoden benötigt, mit derenHilfe ein Übersetzer automatisch überprüfen kann, ob die Bedingungen erfüllt sind.

Ein sorgfältiges Vorgehen erfordert hier, dass man erstens nachweist, dass dieVoraussetzungen für die Korrektheit der Transformation hinreichend sind, und zwei-tens einen Beweis führt, dass die Analyse, die die Gültigkeit der Voraussetzungennachweisen soll, niemals falsche Antworten liefert. Beide Korrektheitsbeweise müs-sen auf die operationelle Semantik der Programmiersprache Bezug nehmen.

Einzelne Optimerungen erzielen für viele Programmiersprachen Verbesserun-gen. Im Allgemeinen erfordert aber jede Programmiersprache (oder jede Klasse vonProgrammiersprachen) eigene Optimierungen, die die Effizienz der Implementie-rung spezieller Sprachkonstrukte verbessern. Ein Beispiel hierfür ist die Eliminie-rung dynamischer Methodenaufrufe in objektorientierten Sprachen. Statische Auf-rufe ermöglichen aggressives Inlining. Dies ist in objektorientierten Sprachen wegender häufig kleinen Methoden von großer Bedeutung. In FORTRAN spielt Inliningdagegen eine untergeordnete Rolle. Wichtig für FORTRAN ist zum Beispiel die Par-allelisierung/Vektorisierung geschachtelter Schleifen.

Des Weiteren hat der Entwurf der Programmiersprache einen großen Einflussauf die Effizienz und Effektivität der Programmanalysen. Durch Einschränkungender Programmiersprache können Eigenschaften erzwungen werden, deren Gültig-keit sonst nur unter großem Aufwand analysierbar wäre. Ein Hauptproblem der Pro-grammanalyse imperativer Programme ist, die Abhängigkeiten zwischen den ein-zelnen Anweisungen zu ermitteln. Durch den fast uneingeschränkten Gebrauch vonZeigern, gibt es etwa in C wesentlich mehr Möglichkeiten, diese Analysen zu er-schweren als beispielsweise in JAVA.

Beispiel 1.1.3 Betrachten wir noch einmal die Programmiersprache JAVA. Spra-chimmanente Ineffizienzen sind unter anderem die obligatorische Überprüfung von

4 1 Grundlagen und intraprozedurale Optimierung

Feldgrenzen. Ebenfalls teuer sind die dynamische Methodenauswahl und die Spei-cherverwaltung für Objekte.

Die Analysierbarkeit wird dadurch erleichtert, dass es keine Zeigerarithmetikgibt und keine Zeiger in den Keller. Negativ dagegen schlägt zu Buche, dass JA-VA dynamisches Nachladen von Klassen unbekannter Herkunft unterstützt. AuchProgrammierkonzepte wie Ausnahmen, Nebenläufigkeit oder gar Selbstinspektion(Reflection) mögen für das praktische Programmieren unerlässlich sein. Für eineautomatische Programmanalyse stellen sie jedoch beträchtliche Herausforderungendar.

Wie sieht es nun mit den formalen Korrektheitsbeweisen aus? Es sind einigeAnstrengungen unternommen worden, für JAVA eine formalisierte Semantik bereitzu stellen. Explizite Korrektheitsbeweise sind jedoch eher die Ausnahme — wasnicht unbedingt an der prinzipiellen Unmöglichkeit liegt, sondern eher an der Größedes Aufwands: es gibt einfach zu viele Sprachkonzepte, die jeweils separat behandeltwerden müssen. ��Aus diesem Grund werden wir in diesem Buch nicht JAVA als Beispielsprache be-nutzen. Stattdessen verwenden wir einen Ausschnitt aus einer imperativen Program-miersprache. Dieser Ausschnitt soll einerseits so einfach wie möglich sein, anderer-seits aber so realistisch, dass er wesentliche Probleme praktischer Übersetzer um-fasst. Unser Programmiersprachenfragment kann man sich als eine Art Zwischen-sprache vorstellen, in die man das ursprüngliche Programm übersetzt hat. Die int-Variablen des Programms stellen wir uns als virtuelle Register vor, denen währendder Codeerzeugung in der Registerzuteilungsphase (nach Möglichkeit) physikali-sche Register zugewiesen werden. Solche Variablen können wir auch einsetzen, umAdressen für indirekte Speicherzugriffe zu speichern. Arithmetische Ausdrücke die-nen dazu, Werte für int-Variablen zu ermitteln. Schließlich sehen wir ein (konzeptuellbeliebig großes) Feld M vor, in dem int-Werte abgelegt werden und aus dem die ab-gelegten Werte wieder geladen werden können. Dieses Feld M können wir uns alsden gesamten (virtuellen) Speicher vorstellen, den das Betriebssystem zur Verfügungstellt.

Die Trennung zwischen Variablen und Speicher mag zunächst künstlich wirken.Ihre Motivation ist die Alias-Freiheit: Sowohl eine Variable x als auch eine Speicher-zelle M[·] bezeichnen einen Behälter, der einen Wert aufnehmen kann. Die Identitätdes Behälters ist bei einem Zugriff M[e] nicht direkt ersichtlich, da sie vom Wertdes Ausdrucks e abhängt. Im Allgemeinen ist es unentscheidbar, ob durch M[e1]und M[e2] derselbe Behälter angesprochen wird. Bei einer Variable ist das nicht derFall: x ist der einzige Name, um auf den mit x assoziierten Behälter zuzugreifen.Dies ist für viele Programmanalysen wichtig: Kann die Analyse für einen schreiben-den Speicherzugriff M[e] ← x die Indentität des Behälters von M[e] nicht ermitteln,kann fortan über den Inhalt des Restes des Speichers keine Annahmen mehr getrof-fen werden – die Analyse verliert an Präzision. Bei Variablen ist dies nicht möglich,da auf ihre Behälter nicht indirekt zugegriffen werden kann.

1.1 Einführung 5

• Variablen: x• arithmetische Ausdrücke: e• Zuweisungen: x ← e• lesender Speicherzugriff: x ← M[e]• schreibender Speicherzugriff: M[e1] ← e2

• bedingte Verzweigung: if (e) s1 else s2

• unbedingte Sprünge: goto L

Beachten Sie, dass wir auf explizite Schleifenkonstrukte verzichtet haben. Diese kön-nen wir jedoch mithilfe bedingter Verzweigungen und unbedingter Sprünge an mar-kierte Programmstellen leicht darstellen. Auch haben wir (vorerst) auf Funktionenund Prozeduren verzichtet. Das bedeutet, dass wir uns zuerst einmal auf die Analyseund Optimierung einzelner Funktionen beschränken.

Beispiel 1.1.4 Betrachten wir erneut unsere Funktion swap() aus Beispiel 1.1.1.Wir stellen uns vor, dass der Übersetzer den Rumpf dieser Funktion schematisch inunsere Zwischensprache übersetzt hätte. Dem Feld a entspricht dann ein bestimmterSpeicherbereich in M. In unseren Programmen muss deshalb die Adressberechnungfür die Feldzugriffe explizit gemacht werden.

0 : A1 ← A0 + 1 ∗ i; // A0 = &a[0]1 : R1 ← M[A1]; // R1 = a[i]2 : A2 ← A0 + 1 ∗ j;3 : R2 ← M[A2]; // R2 = a[ j]4 : if (R1 > R2) {5 : A3 ← A0 + 1 ∗ j;6 : t ← M[A3];7 : A4 ← A0 + 1 ∗ j;8 : A5 ← A0 + 1 ∗ i;9 : R3 ← M[A5];10 : M[A4] ← R3;11 : A6 ← A0 + 1 ∗ i;12 : M[A6] ← t;13 : } //

Dabei wird angenommen, dass die Variable A0 die Anfangsadresse des Feldes aenthält. Beachten Sie, dass dieser Code die Ineffizienzen, die wir in Beispiel 1.1.1diskutiert hatten, nun explizit macht. Welche Optimierungen sind anwendbar?Optimierung 1: 1 ∗ R ==⇒ RDer Skalierungsfaktor, den eine automatische Behandlung der Feldindizierung er-zeugt, kann natürlich eingespart werden, wenn er wie in diesem Fall 1 ist.

Optimierung 2: Wiederbenutzung von Teilausdrücken

6 1 Grundlagen und intraprozedurale Optimierung

Eine genauere Betrachtung zeigt uns, dass einerseits die Variablen A1, A5 und A6wie auch andererseits die Variablen A2, A3 und A4 jeweils den gleichen Wert erhal-ten:

A1 = A5 = A6 A2 = A3 = A4

Darüber hinaus liefern auch die Speicherzugriffe M[A1] und M[A5] bzw. M[A2]und M[A3] jeweils die gleichen Werte zurückliefern:

M[A1] = M[A5] M[A2] = M[A3]

Deshalb erhalten auch die Variablen R1 und R3 sowie R2 und t jeweils die gleichenWerte:

R1 = R3 R2 = t

Enthält eine Variable x den Wert eines Ausdrucks e, den wir benötigen, kann manden Inhalt von x benutzen, anstatt den Wert von e ein weiteres Mal zu berechnen.Unter Benutzung dieser Information können wir unser Beispielprogramm stark ver-einfachen:

A1 ← A0 + i;R1 ← M[A1];A2 ← A0 + j;R2 ← M[A2];if (R1 > R2) {

M[A2] ← R1;M[A1] ← R2;

}Wir beobachten, dass die Hilfsvariable t wie auch die Variablen A3, A4, A5 und R3überflüssig geworden sind.

Die folgende Tabelle listet unsere Ersparnisse auf:

vorher nachher

+ 6 2

∗ 6 0

Laden 4 2

Speichern 2 2

> 1 1

← 6 2��

Die Optimierungen, die am Beispiel der Funktion swap mit der Hand durchgeführtwurden, sollen nach Möglichkeit automatisch realisiert werden. Dazu werden wir imFolgenden nach und nach die notwendigen Transformationen und Analysen bereit-stellen.

1.2 Vermeidung überflüssiger Berechnungen 7

1.2 Vermeidung überflüssiger Berechnungen

In diesem Kapitel beschreiben wir einige Techniken, um Berechnungen, die das Pro-gramm überflüssigerweise ausführt, einzusparen. Wir beginnen mit einer ersten Op-timierung zur Vermeidung von Mehrfachberechnungen oder Redundanzen. Am Bei-spiel dieser ersten Transformation sollen gleichzeitig grundlegende Vorgehenswe-ten erläutert werden. Insbesondere werden wir in möglichst knappen Exkursen eineoperationelle Semantik für unsere Beispiel-Programmiersprache einführen sowie dienotwendigen verbandstheoretischen Grundlagen diskutieren.

Ein beliebter Trick in der Algorithmik beruht darauf, Rechenzeit gegenüber Spei-cherplatz auszuspielen. Wird eine Berechnung ausgeführt, speichert man den be-rechneten Wert ab. Anstatt die gleiche Berechnung später ein weiteres Mal durchzu-führen, wird der bereits berechnete Wert nachgeschlagen. Diese Technik heißt auchMemoisierung.

Beachten Sie die Bedingungen für die Profitabilität einer solchen Transformati-on: Einerseits benötigt man gegebenenfalls zusätzlichen Platz für die Speicherungder Zwischenergebnisse. Zum anderen wird die Neuberechnung nicht ersatzlos ge-strichen, sondern durch das Nachschlagen des Werts ersetzt. Dieses ist billig, fallsder Wert in einem Register liegt; es könnte aber auch teuer sein, wenn er im Spei-cher abgelegt werden muss. Im letzteren Fall könnte eine Neuberechnung eventuellbilliger sein als die Abspeicherung. Zur Vereinfachung werden wir hier diese Artvon Kosten-Nutzen-Analyse nicht durchführen, sondern stets annehmen, dass Nach-schlagen günstiger ist als Neuberechnung.

Die Berechnungen, die wir hier betrachten, sind Auswertungen von Ausdrückene. Das erste Problem besteht darin, eine Mehrfachberechnung zu erkennen.

Beispiel 1.2.1 Betrachten Sie das Programmstück:

z ← 1;y ← M[5];

A : x1 ← y + z ;

. . .B : x2 ← y + z ;

Es sieht so aus, als ob am Programmpunkt B der Wert des Ausdrucks y + z mitgleichem Ergebnis ein weiteres Mal berechnet wird. Dies ist zumindest immer dannder Fall, wenn die zweite Auswertung stets nach der ersten ausgeführt wird und dieVariablen y und z vor der zweiten Auswertung die gleichen Werte wie vor der erstenAuswertung haben. ��Wir stellen fest, dass wir für eine systematische Codeverbesserung in der Lage seinmüssen, folgende Fragen zu beantworten:

• Wird eine Ausdrucksauswertung stets vor einer anderen ausgeführt?

8 1 Grundlagen und intraprozedurale Optimierung

• Hat eine Variable an einem Programmpunkt stets den gleichen Wert wie an ei-nem anderen Programmpunkt?

Zur Beantwortung solcher Fragen benötigen wir zunächst eine operationelle Seman-tik, die festlegt, was bei der Programmausführung passieren soll, und desweiteren einVerfahren, das in Programmen Mehrfachberechnungen identifiziert. Beachten Sie,dass wir keineswegs so ambitioniert sind, sämtliche Mehrfachberechnungen aus-findig machen zu wollen. Dies wäre aus allgemeinen Berechenbarkeitsüberlegun-gen heraus auch unmöglich. In der Praxis ist es jedoch oft ausreichend, wenn unserVerfahren wenigstens einige Mehrfachberechnungen identifiziert und niemals Aus-drucksvorkommen als Mehrfachberechnungen klassifiziert, die in Wirklichkeit garkeine sind!

1.3 Exkurs: Eine operationelle Semantik

Als besonders geeignet für Korrektheitsbeweise von Programmanalysen und -opti-mierungen erweist sich ein small-step operationeller Ansatz. Hierbei wird forma-lisiert, was ein Berechnungsschritt ist. Eine Berechnung ergibt sich dann als eineAbfolge von Berechnungsschritten.

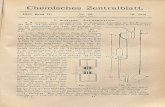

Wir beginnen damit, Programme als Kontrollflussgraphen darzustellen. Die Kno-ten dieses Graphen entsprechen den Programmpunkten, die während einer Berech-nung durchlaufen werden. Die Kanten des Graphen entsprechen den einzelnen Be-rechnungsschritten. In unserem Fall sind sie deshalb mit den zugehörigen Aktio-nen beschriftet, d.h. mit zu überprüfenden Bedingungen, mit Zuweisungen, Laden,Speichern oder mit der leeren Anweisung “;”. Einen Ausschnitt aus dem Kontroll-flussgraphen für den Rumpf der Funktion swap zeigt Abb. 1.1. Dabei repräsentieren

start

stop

NonZero (R1 > R2)Zero (R1 > R2)

A1 ← A0 + 1 ∗ i

R1 ← M[A1 ]

A2 ← A0 + 1 ∗ j

R2 ← M[A2 ]

A3 ← A0 + 1 ∗ j

Abb. 1.1. Ein Ausschnitt aus dem Kontrollflussgraphen für swap().

1.3 Exkurs: Eine operationelle Semantik 9

Knoten Programmpunkte, start den Programmanfang, stop das Programmende undKanten Berechnungsschritte.Als Kantenbeschriftungen lassen wir zu:

Test : NonZero(e) oder Zero(e)Zuweisung : x ← eLaden : x ← M[e]Speichern : M[e1] ← e2

leere Anweisung : ;

Dabei behalten wir uns vor, Kantenbeschriftungen mit ; auch wegzulassen. An ei-ner bedingten Programmverzweigung soll NonZero(e) die Kante einer bedingtenVerzweigung beschriften, die genommen wird, wenn die Bedingung e zutrifft, d.h.einen Wert verschieden von 0 liefert. Entsprechend steht Zero(e) an der Kante einerbedingten Verzweigung, die genommen wird, wenn die Bedingung e nicht zutrifft,d.h. den Wert 0 liefert.

Berechnungen geschehen entlang von Pfaden. Sie transformieren den aktuellenProgrammzustand. Programmzustände können wir als Paare repräsentieren:

s = (ρ, μ)

Dabei ordnet die Abbildung ρ jeder Variablen des Programms ihren Wert und dieAbbildung μ jeder Adresse im Speicher den Wert der zugehörigen Speicherzelle zu.Wir nehmen der Einfachheit halber an, dass die Werte von Variablen und die Inhaltevon Speicherzellen jeweils ganze Zahlen sind. Deshalb haben die Abbildungen ρ undμ die Funktionalität:

ρ : Vars → int Werte der Variablen

μ : N → int Inhalt des Speichers

Jede Kante k = (u, lab, v) mit Eingangsknoten u, Endknoten v und Beschriftung labdefiniert eine Transformation [[k]] auf den Zuständen. Diese Transformation nennenwir auch den Effekt der Kante. Der Effekt einer Kante ist möglicherweise nur einepartielle Abbildung. Ist ein Kanteneffekt für einen Zustand s nicht definiert, dannbedeutet das, dass die Programmausführung im Zustand s diese Kante nicht ausfüh-ren wird. Dies kann bei Kanten vorkommen, die mit Bedingungen beschriftet sind,aber auch bei Speicherzugriffen, bei denen auf nicht erlaubte Adressen zugegriffenwird.

Die Transformation [[k]] der Kante k = (u, lab, v) hängt nur von ihrer Beschrif-tung lab ab:

[[k]] = [[lab]]

Die Kanteneffekte [[lab]] sind wie folgt definiert:

10 1 Grundlagen und intraprozedurale Optimierung

[[; ]] (ρ, μ) = (ρ, μ)

[[NonZero(e)]] (ρ, μ) = (ρ, μ) falls [[e]]ρ �= 0[[Zero(e)]] (ρ, μ) = (ρ, μ) falls [[e]]ρ = 0

[[x ← e]] (ρ, μ) = ( ρ ⊕ {x → [[e]]ρ} , μ)

[[x ← M[e]]] (ρ, μ) = ( ρ ⊕ {x → μ([[e]]ρ)} , μ)

[[M[e1] ← e2]] (ρ, μ) = (ρ, μ ⊕ {[[e1]]ρ → [[e2]]ρ} )

Eine leere Anweisung verändert den Zustand nicht. Bedingungen, NonZero(e) bzw.Zero(e), repräsentieren eine partielle Identität; die zugehörigen Kanteneffekte sindnur definiert, wenn die Auswertung des Ausdrucks e einen Wert ungleich bzw. gleich0 liefert. Sind diese Kanteneffekte jedoch definiert, ändern sie den Zustand nicht.Zur Berechnung des Werts eines Ausdrucks e haben wir eine Hilfsfunktion [[e]] be-nutzt, die Ausdrucksauswertung, die für eine Variablenbelegung ρ den Wert von eberechnet. Wie üblich ist diese Funktion induktiv über die Struktur des Ausdrucks edefiniert. Damit ergibt sich etwa:

[[x + y]] {x → 7, y → −1} = 6[[¬(x = 4)]] {x → 5} = ¬0 = 1

Der Operator ¬ bezeichnet dabei die logische Negation.Eine Zuweisung x ← e modifiziert die Komponente ρ des Zustands; ρ enthält für

die Variable x jetzt den Wert [[e]]ρ, d.h. den Wert, den die Auswertung des Ausdruckse für die Variablenbelegung ρ vor der Zuweisung liefert. Der Speicher M bleibt durchdiese Zuweisung unverändert. Zur formalen Beschreibung der Abänderung von ρ

benutzen wir den Operator ⊕. Dieser Operator modifiziert eine Funktion, indem erihr für ein Argument einen neuen Wert gibt:

ρ ⊕ {x → d}(y) =

{d falls y ≡ xρ(y) sonst

Eine Lade-Operation x ← M[e] behandeln wir analog zu einer Zuweisung – mitdem Unterschied, dass der neue Wert der Variablen x ermittelt wird, indem erst eineAdresse im Speicher bestimmt wird, um anschließend den Wert aus der entsprechen-den Speichherzelle auszulesen.

Am kompliziertesten ist die Semantik des Speicherns, M[e1] ← e2. Hier ändernsich die Werte der Variablen nicht. Stattdessen müssen zuerst die Werte der Teilaus-drücke e1, e2 ermittelt werden. Der Wert von e1 liefert die Adresse im Speicher, anwelcher der Wert des Ausdrucks e2 abgelegt werden soll.

1.4 Beseitigung von Mehrfachberechnungen 11

Sowohl bei der Lade- wie der Speicheroperation nehmen wir an, dass der Adress-ausdruck jeweils eine legale Adresse d.h. einen Wert > 0 liefert.

Beispiel 1.3.1 Für die Zuweisung x ← x + 1 und eine Variablenbelegung {x → 5}ergibt sich:

[[x ← x + 1]] ({x → 5}, μ) = (ρ, μ)

wobei:ρ = {x → 5} ⊕ {x → [[x + 1]] {x → 5}}

= {x → 5} ⊕ {x → 6}= {x → 6}

��Damit haben wir festgelegt, was an Kanten im Kontrollflussgraphen passiert. EineBerechnung π des Programms ist ein Pfad im Kontrollflussgraphen, der von einemStartpunkt u zu einem Endpunkt v führt. Ein solcher Pfad ist eine Folge π = k1 . . . kn

von Kanten ki = (ui, labi, ui+1) des Kontrollflussgraphen (i = 1, . . . , n − 1), wobeiu1 = u und un = v. Die zu π gehörende Zustandstransformation [[π ]] ergibt sichdann als Komposition der Kanteneffekte der Kanten von π :

[[π ]] = [[kn]] ◦ . . . ◦ [[k1]]

Beachten Sie, dass die Abbildung [[π ]] nicht für alle Zustände definiert sein muss.Nur dann, wenn [[π ]] für einen Zustand s definiert ist, ist eine Berechnung entlangder Folge von Kanten π möglich.

1.4 Beseitigung von Mehrfachberechnungen

Kehren wir zu unserem Ausgangsproblem zurück, eine Analyse zu finden, die fürjeden Programmpunkt feststellt, ob ein Ausdruck dort neu berechnet werden mussoder ob sein bereits berechneter Wert benutzt werden kann.

Wir betrachten hier die Verfügbarkeit von Ausdrücken in Variablen. Ein Ausdrucke sehen wir nur dann als verfügbar in der Variable x an, wenn er mit Sicherheitausgewertet, der Variablen x zugewiesen und seither weder x, noch eine der in evorkommenden Variablen modifiziert wurde.

Betrachten wir eine Zuweisung x ← e mit x �∈ Vars(e), d.h. x kommt selbstnicht in dem Ausdruck e vor. Sei weiterhin π = k1 . . . kn ein Pfad vom Startpunktdes Programms zu dem Programmpunkt v. Wir sagen, dass e nach Ausführung vonπ in x verfügbar ist, wenn die beiden folgenden Eigenschaften gelten:

• Der Pfad π enthält eine Kante ki, an der eine Zuweisung x ← e ausgeführt wird.• An keiner der Kanten ki+1, . . . , kn wird einer Variablen aus Vars(e) ∪ {x} ein

neuer Wert zugewiesen.

12 1 Grundlagen und intraprozedurale Optimierung

Der Einfachheit halber sagen wir dann auch, die Zuweisung x ← e ist nach der Aus-führung von π verfügbar. Andernfalls nennen wir e in x bzw. x ← e entlang π nichtin x verfügbar. Wir nehmen an, dass am Startpunkt des Programms keine Zuweisungverfügbar ist. Ist π der leere Pfad, d.h. π = ε, dann ist auch keine Zuweisung nachAusführung von π verfügbar.

Betrachten wir eine Kante k = (u, lab, v). Nehmen wir an, wir würden bereitsdie Menge A der Zuweisungen kennen, die vor Ausführung der Kante k verfügbarsind. Dann erhalten wir die Menge der nach Ausführung der Kante k verfügbarenZuweisungen, indem wir auf A eine Funktion [[k]]� anwenden. Die Funktion [[k]]�hängt alleine von der Beschriftung der Kante k ab. Im Gegensatz zu dem Effekt [[k]]der Kante der operationellen Semantik nennen wir den Effekt der Kante, die wirfür die Analyse konstruieren, abstrakt. Im Folgenden wollen wir diese abstraktenKanteneffekte [[k]]� = [[lab]]� konstruieren.

Sei Ass die Menge aller (uns interessierenden) Zuweisungen x ← e des Pro-gramms mit x �∈ Vars(e). Nehmen wir an, am Startpunkt u der Kante k = (u, lab, v)stünde die Menge A ⊆ Ass zur Verfügung. Dann lässt sich die Menge der nach demDurchlaufen der Kante verfügbaren Zuweisungen wie folgt ermitteln:

[[; ]]� A = A[[NonZero(e)]]� A = [[Zero(e)]]� A = A

[[x ← e]]� A =

{(A\Occ(x)) ∪ {x ← e} falls x �∈ Vars(e)A\Occ(x) andernfalls

[[x ← M[e]]]� A = A\Occ(x)[[M[e1] ← e2]]� A = A

wobei Occ(x) die Menge aller Zuweisungen bezeichnet, in denen x entweder alslinke Seite oder in dem Ausdruck auf der rechten Seite vorkommt. Eine leere An-weisung oder eine Bedingung verändert die Verfügbarkeit einer Zuweisung nicht.Bei einer Zuweisung wird der Wert der rechten Seite berechnet und der linken Seitezugewiesen. Deshalb müssen alle Zuweisungen entfernt werden, welche die Variableauf der linken Seite der Zuweisung enthalten. Anschließend muss diese zu A hinzugefügt werden, sofern die linke Seite nicht in der rechten vorkommt. Der abstrakteKanteneffekt für das Laden aus dem Speicher sieht analog aus, während bei einemAbspeichern keine Variablen modifiziert werden. Hier ändert sich A nicht.

An jeder Kante ändert sich die Menge der verfügbaren Zuweisungen durch Her-ausnehmen oder Hinzufügen von Elementen. Die abstrakten Effekte, die wir für jedeeinzelne Kante definiert haben, setzen wir zu der abstrakten Transformation [[π ]]�,die zu einem Pfad π = k1 . . . kn gehört, wie folgt zusammen:

[[π ]]� = [[kn]]� ◦ . . . ◦ [[k1]]�

Die Menge der nach Ausführung des Pfads π vom Startknoten zum Programmpunktv verfügbaren Zuweisungen ergibt sich deshalb als

[[π ]]�∅ = [[kn]]�(. . . ([[k1]]� ∅) . . .)

1.4 Beseitigung von Mehrfachberechnungen 13

Damit kann ein einzelner Pfad π daraufhin untersucht werden, welche Zuweisungenentlang π zur Verfügung stehen. In einem Programm wird es jedoch typischerwei-se mehrere Pfade geben, die einen Programmpunkt v erreichen. Welcher von diesenbei der Programmausführung ausgewählt wird, kann von der Eingabe abhängen undist deshalb zur Übersetzungszeit meist unbekannt. Wir betrachten eine Zuweisungx ← e als sicher verfügbar an einem Programmpunkt v, wenn sie auf allen Pfadenvom Startpunkt zum Programmpunkt v verfügbar ist. Andernfalls ist x ← e mögli-cherweise nicht verfügbar. Die Menge der am Programmpunkt v sicher verfügbarenZuweisungen ist deshalb gegeben durch:

A∗[v] =⋂{[[π ]]�∅ | π : start →∗ v}

Dabei bezeichnet start →∗ v die Menge aller Pfade vom Startpunkt start des Pro-gramms zum Programmpunkt v.

Im Moment wollen wir die Frage hintenanstellen, wie man die Mengen A∗[v]berechnen kann. Stattdessen wollen wir zuerst einmal überlegen, wie sich diese In-formation für eine optimierende Transformation des Programms ausnutzen lässt.

Transformation RE:

Wir ersetzen eine Zuweisung x ← e durch x ← y, wenn eine Zuweisung y ← eam Programmpunkt u vor dieser Zuweisung definitiv verfügbar, d.h. in der MengeA∗[u] enthalten ist. Dies formalisiert die folgende Graphersetzungsregel:

u u

x ← ey ← e ∈ A∗[u]

x ← y

Analoge Regeln verwenden wir, um die Ausdrücke in Bedingungen, beim Laden ausdem Speicher und beim Schreiben in den Speicher gegebenenfalls durch Variablen-zugriffe zu ersetzen.

Die Transformation RE nennen wir auch Beseitigung von Redundanzen (englisch:Redundancy Elimination. Wir sehen, die tatsächliche Transformation ist sehr ein-fach. Aufwändig dagegen kann es sein, die für die Transformation notwendigen Pro-grammeigenschaften zu berechnen.

Beispiel 1.4.1 Betrachten wir das folgende kurze Programmstück:

x ← y + 3;x ← 7;z ← y + 3;

Vor der Programmausführung ist x ← y + 3 nicht verfügbar. Nach der ersten Zu-weisung ist diese stets verfügbar. Da die zweite Zuweisung jedoch den Wert von xüberschreibt, kann die zweite Zuweisung nicht vereinfacht werden. ��

14 1 Grundlagen und intraprozedurale Optimierung

Beispiel 1.4.2 Betrachten wir die Implementierung der Anweisung a[7]-−; in unse-rer Beispiel-Sprache. Nehmen wir dabei an, dass sich die Anfangsadresse des Feldsa in der Variable A befindet. Den ursprünglichen Kontrollfluss-Graphen zu dem Pro-grammfragment zusammen mit der Anwendung der Transformation RE zeigt Abb.1.2. Weil bei Erreichen der Zuweisung A2 ← A + 7 die Zuweisung A1 ← A + 7

B1 ← M[A1 ]

A1 ← A + 7

B2 ← B1 − 1

A2 ← A + 7

M[A2 ] ← B2

A1 ← A + 7

B1 ← M[A1 ]

B2 ← B1 − 1

A2 ← A1

M[A2 ] ← B2

Abb. 1.2. Die Transformation RE für a[7]−−;.

verfügbar ist, können wir die rechte Seite A + 7 durch die Variable A1 ersetzen. ��Um die Anwendbarkeit der Transformation RE zu erhöhen, können wir für jedenuns interessierenden Ausdruck eine eigene Variable zur Verfügung stellen. Damitumgehen wir das Problem, dass ein Ausdruck zwar berechnet wurde, sein Wert abernicht mehr zugreifbar ist, weil die Variable, in der sein Wert abgespeichert wur-de, mittlerweile einen neuen Wert erhielt (vgl. Beispiel 1.4.1). Eine entsprechendeTransformation entwickelt Aufg. 5.

In einer praktischen Implementierung wird der Übersetzer nicht für alle Zuweisun-gen die Verfügbarkeit bestimmen, sondern nur für solche, bei denen die Neuberech-nung der rechten Seite teurer als ein Variablenzugriff ist.Wenden wir uns dem Beweis der Korrektheit der vorgestellten Transformationen zu.Wir können ihn in zwei Teile aufteilen.

1. Den Beweis der Korrektheit der abstrakten Kanteneffekte [[k]]� relativ zur Defi-nition der Verfügbarkeit;

2. Den Beweis der Korrektheit der Ersetzung von Ausdrücken e durch Variablen-zugriffe.

Hier betrachten wir nur den zweiten Punkt. Die Definition der Verfügbarkeit istin gewissem Sinne rein syntaktisch. Sei π ein Pfad im transformierten Programmvom Startpunkt des Programms zu einem Programmpunkt u und sei s = (ρ, μ)der Zustand nach Ausführung der Berechnung π . Sei x ← e eine Zuweisung mit

1.4 Beseitigung von Mehrfachberechnungen 15

x �∈ Vars(e). Nehmen wir weiter an, dass x ← e an u verfügbar ist. Dann müssenwir zeigen, dass im Zustand s der Wert der Variablen x gleich dem Wert des Aus-drucks e für die Variablenbelegung ρ ist, d.h. ρ(x) = [[e]]ρ. Diese Eigenschaft wirddurch Induktion über die Länge der Berechnung π bewiesen.

Nehmen wir nun an, an dem Programmpunkt u gebe es eine ausgehende Kantek, an der eine Zuweisung x ← e erfolgt. Nehmen wir weiter an, y ← e sei inA∗[u] enthalten, d.h. verfügbar. Dann ist y ← e insbesondere auch in der Mengeder nach π verfügbaren Zuweisungen enthalten. Folglich gilt ρ(y) = [[e]]ρ. Unterdieser Bedingung kann die Zuweisung x ← e durch x ← y ersetzt werden.

Es bleibt die Preisfrage: Wie berechnen wir die Mengen A∗[u]?

Eine grundlegende Idee besteht darin, ein Ungleichungssystem aufzustellen, dasdiese Werte charakterisiert. In dem Ungleichungssystem sammeln wir Bedingungen,welche die gesuchten Mengen erfüllen müssen:

A[start] ⊆ ∅A[v] ⊆ [[k]]� (A[u]) k = (u, lab, v) Kante

Wir nehmen an, dass am Startpunkt des Programms keinerlei Zuweisungen verfüg-bar sind. Das wird durch die erste Ungleichung ausgedrückt. Weiterhin erzeugt jedeKante k von einem Programmpunkt u zu einem Programmpunkt v eine Ungleichung.Diese Ungleichung beschreibt, wie verfügbare Zuweisungen entlang der Kante k vonu nach v propagiert werden. Die Menge der am Endpunkt v der Kante k verfügba-ren Zuweisungen ist in der Menge der Zuweisungen enthalten, die sich entlang derKante k aus den am Programmpunkt u verfügbaren Zuweisungen ergeben: deshalbdie Inklusionsbeziehung zwischen A[v] und [[k]]� (A[u]).

Beispiel 1.4.3 Betrachten wir als Beispiel ein Programm, das die Fakultätsfunkti-on implementiert (Abb. 1.3). Wir sehen, dass das Ungleichungssystem mithilfe der

3

2

4

5

0

1NonZero(x > 1)Zero(x > 1)

y ← 1

y ← x ∗ y

x ← x − 1

A[0] ⊆ ∅A[1] ⊆ (A[0]\Occ(y)) ∪ {y ← 1}A[1] ⊆ A[4]A[2] ⊆ A[1]A[3] ⊆ A[2]\Occ(y)A[4] ⊆ A[3]\Occ(x)A[5] ⊆ A[1]

Abb. 1.3. Das Ungleichungssystem für die Fakultätsfunktion.

abstrakten Kantentransformationen ganz schematisch aus dem Kontrollflussgraphen

16 1 Grundlagen und intraprozedurale Optimierung

gewonnen werden kann. In dem Beispiel lässt sich das Ungleichungssystem wei-ter stark vereinfachen. Die einzige Zuweisung, bei der die Variable der linken Seitenicht auf der rechten Seite vorkommt, ist y ← 1. Der vollständige Verband für ver-fügbare Zuweisungen besteht deshalb nur aus den zwei Elementen ∅ und {y ← 1}.Entsprechend ist Occ(y) = {y ← 1} und Occ(x) = ∅.

Eine triviale Lösung dieses Ungleichungssystems zeigt Abb. 1.4. Diese Lösung

A[0] = A[1] = A[2] = A[3] = A[4] = A[5] = ∅

Abb. 1.4. Eine triviale Lösung für das Ungleichungssystem aus Beispiel 1.4.3.

ist in diesem Fall auch die einzige Lösung. Im allgemeinen kann es jedoch sehr wohlmehrere Lösungen geben. Bei der Verfügbarkeit von Zuweisungen sind wir dannan größt möglichen Mengen interessiert: Je größer das Ergebnis ist, d.h. desto mehrZuweisungen wir als verfügbar nachweisen, desto genauer ist unsere Analyse unddesto mehr Möglichkeiten gibt es zur Optimierung.

Wir fragen uns, ob eine größte Lösung immer existiert, und wenn ja, ob wir sieeffizient berechnen können. ��Um die Fragen nach der Existenz von „besten“ Lösungen von Ungleichungssyste-men und ihrer effizienten Berechnung systematisch beantworten und auf andere Pro-grammanalysen anwenden zu können, verallgemeinern wir die Problemstellung einwenig.

Als erstes beobachten wir dazu, dass die Menge der möglichen Werte für die un-bekannten A[v] eine Halbordnung bzgl. der Teilmengenrelation ⊆ und damit auchbzgl. der Obermengenrelation ⊇ bildet. Diese Halbordnung hat die zusätzliche Ei-genschaft, dass jede Teilmenge X von Werten eine kleinste obere Schranke bzw. einegrößte untere Schranke besitzt, nämlich gerade die Vereinigung bzw. den Durch-schnitt der Mengen in X. Eine Halbordnung mit dieser Zusatzeigenschaft nennt manauch vollständigen Verband.

Weiterhin beobachten wir, dass die abstrakten Kanten-Transformationen [[k]]�monoton sind, d.h. die Ordungsrelation auf Werten erhalten:

[[k]]�(B1) ⊇ [[k]]�(B2) wenn B1 ⊇ B2

1.5 Exkurs: Vollständige Verbände

In diesem Abschnitt sammeln wir grundlegende Begriffe und Sätze über vollständigeVerbände, Lösungen von Ungleichungssystemen und grundlegenden Verfahren, umkleinste Lösungen zu berechnen. Wir beginnen mit den Definitionen von Halbord-nung und vollständigem Verband.

1.5 Exkurs: Vollständige Verbände 17

Eine Menge D mit einer Relation � ⊆ D × D nennen wir eine Halbord-nung (Partial Order), falls folgende Eigenschaften für alle a, b, c ∈ D gelten:

a � a Reflexivitata � b ∧ b � a =⇒ a = b Antisymmetriea � b ∧ b � c =⇒ a � c Transitivitat

Das üblicherweise verwendete Symbol � sollte Sie dabei an die typischen Ord-nungsrelationen ≤ auf Zahlen und ⊆ auf Mengen erinnern. Beispiele für Halbord-nungen sind:

1. Die Menge D = 2{a,b,c} aller Teilmengen einer endlichen Grundmenge, hier{a, b, c} mit der Relation ⊆:

a, b, c

a, b a, c b, c

a b c

2. Die Menge aller ganzen Zahlen Z mit der Relation =:

210-1-2

3. Die Menge aller ganzen Zahlen Z mit der Relation ≤:

0-1

12

4. Die Menge aller ganzen Zahlen Z⊥ = Z ∪ {⊥}, erweitert um ein zusätzlichesElement ⊥ mit der Ordnung:

210-1-2

⊥

Ein Element d ∈ D heißt obere Schranke für eine Teilmenge X ⊆ D falls

x � d für alle x ∈ X

Das Element d heißt kleinste obere Schranke (englisch: least upper bound oder lub),falls

1. d eine obere Schranke ist und2. d � y für jede obere Schranke y von X gilt.

18 1 Grundlagen und intraprozedurale Optimierung

Nicht jede Teilmenge in einer Halbordnung hat notwendigerweise auch eine obereSchranke, geschweige denn eine kleinste obere Schranke. In der Halbordnung Z derganzen Zahlen, ausgestattet mit der natürlichen Ordnung ≤ besitzt etwa die Men-ge {0, 2, 4} die oberen Schranken 4, 5, . . . . Die Menge {0, 2, 4, . . .} aller geradenZahlen besitzt dagegen keine obere Schranke.

Eine Halbordnung D ist ein vollständiger Verband (englisch: complete lattice),falls jede Teilmenge X ⊆ D eine kleinste obere Schranke besitzt. Diese kleinsteobere Schranke bezeichnen wir auch mit

⊔X.

Jedes Element ist eine obere Schranke der leeren Menge. Weil in einem voll-ständigen Verband auch die leere Menge eine kleinste obere Schranke besitzt, gibtes in jedem vollständigen Verband ein Element ⊥, das kleiner oder gleich jedemanderen Element des vollständigen Verbands ist. Dieses kleinste Element wird auchBottom-Element genannt. Weil in einem vollständigen Verband auch die Menge allerElemente eine obere Schranke besitzen muss, gibt es in jedem vollständigen Verbandauch ein ein größtes Element �, das Top-Element. Betrachten wir unsere Beispiel-Halbordnungen. Dann gilt:

1. Die Menge D = 2{a,b,c} aller Teilmengen der Grundmenge {a, b, c} und allge-mein jeder Grundmenge zusammen mit der Teilmengenrelation ist ein vollstän-diger Verband.

2. Die Menge Z aller ganzen Zahlen ist weder mit der Halbordnung = noch mitder Halbordnung ≤ ein vollständiger Verband.

3. Die Hinzufügung eines kleinsten Elements ⊥ reicht ebenfalls nicht, um aus Z

mit = einen vollständigen Verband zu erhalten. Vielmehr müssen wir außer ei-nem kleinsten Element ⊥ auch noch ein größtes Element, das Top-Element, �,hinzufügen. Das Ergebnis ist der flache Verband Z�

⊥ = Z∪ {⊥,�} :

210-1-2

⊥

�

Analog zu oberen Schranken und kleinsten oberen Schranken kann man auch untereSchranken und größte untere Schranken für eine Teilmenge X einer Halbordnungdefinieren. Zum Aufwärmen beweisen wir den folgenden Satz:

Satz 1.5.1 In jedem vollständigen Verband D besitzt jede Teilmenge X ⊆ D einegrößte untere Schranke ⊔X.

Beweis. Sei U = {u ∈ D | ∀ x ∈ X : u � x} die Menge sämtlicher untererSchranken der Menge X. Da D ein vollständiger Verband ist, besitzt die Menge Ueine kleinste obere Schranke g :=

⊔U. Wir behaupten, dass g die gesuchte größte

untere Schranke der Menge X ist.Um diese Behauptung zu beweisen, zeigen wir zuerst einmal, dass g ebenfalls

eine untere Schranke der Menge X ist. Dazu betrachten wir ein beliebiges Element

1.5 Exkurs: Vollständige Verbände 19

x ∈ X. Dann gilt u � x für jedes u ∈ U, da jedes u ∈ U sogar eine untereSchranke für ganz X ist. Folglich ist x eine obere Schranke der Menge U und damitinsbesondere größer oder gleich der kleinsten oberen Schranke von U, d.h. g � x.Da x beliebig war, folgt unsere Behauptung.

Es bleibt zu zeigen, dass g auch die größte untere Schranke von X ist. Dies istaber einfach: weil g eine obere Schranke für U ist, ist g insbesondere größer odergleich jedem Element in U, d.h. u � g für alle u ∈ U. ��Die Verhältnisse in einem vollständigen Verband veranschaulicht Abb. 1.5. Dass es

Abb. 1.5. Die obere und untere Schranke für eine Teilmenge X.

zu einer Teilmenge X stets eine kleinste obere Schranke gibt, folgt aus der Definitioneines vollständigen Verbands. Dass die Teilmenge X aber ebenfalls über eine größteuntere Schranke verfügt, folgt aus Satz 1.5.1.

Wir suchen Lösungen für Ungleichungssysteme der Form:

xi � fi(x1, . . . , xn) i = 1, . . . , n

Bei der Bestimmung der verfügbaren Zuweisungen entsprechen dabei die Unbe-kannten xi in den Ungleichungen den A[u] (u Programmpunkt). Der vollständigeVerband D, in dem wir Werte für die Unbekannten suchen, ist der Teilmengenver-band 2Ass, wobei die Halbordnung durch die Obermengenrelation ⊇ gegeben ist. DieFunktionen fi : Dn → D schließlich beschreiben, wie die Unbekannten xi von denanderen Unbekannten abhängen. Die Ungleichungen haben damit die Form:

A[start] ⊆ ∅ Kante}A[v] ⊆ ⋂{[[k]]� (A[u]) | k = (u, lab, v) Kante} für v �= start

20 1 Grundlagen und intraprozedurale Optimierung

Zur Vereinfachung haben wir sämtliche Ungleichungen für dieselbe Unbekannte zueiner Ungleichung zusammen gefasst, indem wir die kleinste obere Schranke überdie Beiträge der rechten Seiten der einzelnen Ungleichungen bilden. Diese Formu-lierung ändert die Lösungsmenge der entsprechenden Ungleichungen nicht, da gilt:

x � d1 ∧ . . . ∧ x � dk gdw. x � ⊔{d1, . . . , dk}Eine wesentliche Eigenschaft der Funktionen fi, die die rechten Seiten unserer Un-gleichungen definieren, ist, dass sie monoton sind. Eine Funktion f : D1 → D2zwischen den beiden Halbordnungen D1, D2 heißt monoton, falls f (a) � f (b) gilt,sofern a � b gilt. Der Einfachkeit halber haben wir hier die Ordnungsrelationen inD1 und in D2 mit dem gleichen Symbol � bezeichnet.

Beispiel 1.5.1 Für eine Menge U D1 = D2 = 2U sei der Teilmengenverband mitder Ordnungsrelation ⊆. Dann ist jede Funktion f mit f x = (x∩ a)∪ b für a, b ⊆ Umonoton. Eine Funktion g mit g x = a \ x für a �= ∅ ist dagegen nicht monoton.

Für D1 = D2 = Z mit der Ordnungsrelation “≤” sind die Funktionen inc unddec mit inc x = x + 1 bzw. dec x = x − 1 monoton. Die durch inv x = −x defi-nierte Funktion inv ist dagegen nicht monoton. ��Sind die Funktionen f1 : D1 → D2 und f2 : D2 → D3 monoton, dann ist auch ihreKomposition f2 ◦ f1 : D1 → D3 monoton.

Ist D2 ein vollständiger Verband, dann bildet auch die Menge [D1 → D2] dermonotonen Funktionen f : D1 → D2 einen vollständigen Verband, wobei

f � g gdw. f x � g x für alle x ∈ D1

gilt. Insbesondere ist für F ⊆ [D1 → D2] die Funktion f mit f x =⊔{g x | g ∈

F} selbst wieder monoton und die kleinste obere Schranke der Menge F.Im Falle von D1 = D2 = 2U können wir für Funktionen fi x = ai ∩ x ∪ bi mit

ai , bi ⊆ U, die Operationen “◦”, “�” und “�” explizit durch Operationen auf denMengen ai , bi ausdrücken;

( f2 ◦ f1) x = a1 ∩ a2 ∩ x ∪ a2 ∩ b1 ∪ b2 Komposition

( f1 � f2) x = (a1 ∪ a2) ∩ x ∪ b1 ∪ b2 Vereinigung

( f1 � f2) x = (a1 ∪ b1) ∩ (a2 ∪ b2) ∩ x ∪ b1 ∩ b2 Durchschnitt

Unser Ziel ist, für das Ungleichungssystem;

xi � fi(x1, . . . , xn), i = 1, . . . , n (∗)eine möglichst kleine Lösung in einem vollständigen Verband D zu konstruieren, wo-bei die fi : Dn → D, welche die rechten Seiten definieren, jeweils monoton sein sol-len. Hier benutzen wir, dass mit D auch Dn ein vollständiger Verband ist. Um das zuGrunde liegende Problem weiter zu vereinfachen, fassen wir die n Funktionen fi zueiner einzigen Funktion f : Dn → Dn zusammen mit f (x1, . . . , xn) = (y1, . . . , yn),

1.5 Exkurs: Vollständige Verbände 21

wobei yi = fi(x1, . . . , xn). Es zeigt sich, dass mit den Komponenten-Funktionen fi

auch f monoton ist. Unser Problem hat sich darauf reduziert, eine möglichst kleineLösung einer einzigen Ungleichung x � f x in dem allerdings nun etwas kompli-zierteren vollständigen Verband Dn zu finden.

Dabei gehen wir so vor: Wir beginnen mit einem möglichst kleinen Element d,also etwa mit d = ⊥ = (⊥, . . . ,⊥), dem kleinsten Element von Dn. Falls d � f dgilt, haben wir eine Lösung gefunden. Andernfalls ersetzen wir d durch f d undwiederholen die Ersetzung.

Beispiel 1.5.2 Betrachten wir den vollständigen Verband D = 2{a,b,c} mit der Ord-nungsrelation � = ⊆ zusammen mit dem Ungleichungssystem:

x1 ⊇ {a} ∪ x3

x2 ⊇ x3 ∩ {a, b}x3 ⊇ x1 ∪ {c}

Dann ergibt die Iteration: Die Ergebnisse der einzelnen Iterationen sind in der fol-genden Tabelle zusammen gefasst:

0 1 2 3 4

x1 ∅ {a} {a, c} {a, c} dito

x2 ∅ ∅ ∅ {a}x3 ∅ {c} {a, c} {a, c}

Wir beobachten, dass mindestens ein Wert für die Unbekannten mit jeder Iterationgrößer wird, bis am Ende eine Lösung gefunden ist. ��Tatsächlich können wir uns davon überzeugen, dass dies für jeden vollständigen Ver-band der Fall ist. Genauer gesagt, zeigen wir:

Satz 1.5.2 Sei D ein vollständiger Verband und f : D → D eine monotone Funktion.Dann gilt:

1. Die Folge ⊥, f ⊥, f 2 ⊥, . . . ist eine aufsteigende Kette, d.h. es gilt f i−1 ⊥ �f i ⊥ für alle i ≥ 1.

2. Ist d = f n−1 ⊥ = f n ⊥, dann ist d das kleinste Element d′ mit d′ � f (d′).

Beweis. Zum Beweis der ersten Aussage wenden wir vollständige Induktion an.Für i = 1 gilt die erste Aussage, weil f 1−1 ⊥ = f 0 ⊥ = ⊥ das kleinste Elementdes vollständigen Verbands und damit kleiner oder gleich f 1 ⊥ = f ⊥ ist. Nehmenwir an, die Aussage gelte für i − 1 ≥ 1, d.h. es gilt f i−2 ⊥ � f i−1 ⊥. Wegen derMonotonie der Funktion f gilt:

f i−1 ⊥ = f ( f i−2 ⊥) � f ( f i−1 ⊥) = f i ⊥Wir schließen, dass damit die Aussage auch für i gilt. Folglich gilt die Aussage füralle i ≥ 1.

22 1 Grundlagen und intraprozedurale Optimierung

Betrachten wir nun die zweite Aussage. Nehmen wir an, dass

d = f n−1 ⊥ � f n ⊥gilt. Dann ist d is eine Lösung der Ungleichung x � f x. Nehmen wir weiter an, wirhätten irgendeine andere Lösung d′ der Ungleichung, d.h., es gelte auch d′ � f d′.Dann genügt es zu zeigen, dass f i ⊥ � d′ für alle i ≥ 0 gilt. Dies zeigen wirerneut mittels vollständiger Induktion. Für i = 0 ist dies der Fall. Sei nun i > 0 undf i−1 ⊥ � d′. Wegen der Monotonie von f gilt dann,

f i ⊥ = f ( f i−1 ⊥) � f d′ � d′

da d′ eine Lösung ist. Damit gilt unsere Behauptung für alle i. ��Satz 1.5.2 gibt uns ein Verfahren an die Hand, nicht nur irgendeine Lösung, sondernsogar die kleinste Lösung einer Ungleichung zu berechnen – unter der Vorausset-zung, dass die aufsteigende Kette der f i ⊥ irgendwann stabil wird, d.h. ab einem ikonstant ist. Für die Terminierung unseres Verfahrens ist es damit hinreichend, wennsämtliche aufsteigenden Ketten in D irgendwann stabil werden. Das ist sicherlich derFall, sofern wir mit endlichen Verbänden rechnen. Die durch unser Iterationsverfah-ren gefundene kleinste Lösung ist tatsächlich eine Lösung nicht nur der Ungleichungx � f x, sondern sogar eine Lösung der Gleichung: x = f x, d.h. ein Fixpunkt vonf .

Was passiert, wenn nicht sämtliche aufsteigende Ketten in unserem vollständi-gen Verband irgendwann stabil werden? Dann wird unser Iterationsverfahren mögli-cherweise nie terminieren. Nichtsdestoweniger gibt es auch in diesem Fall stets einekleinste Lösung.

Satz 1.5.3 (Knaster – Tarski) In einem vollständigen Verband D hat jede monotoneFunktion f : D → D einen kleinsten Fixpunkt d0, welcher auch die kleinste Lösungder Ungleichung x � f x ist.

Beweis. Eine Lösung der Ungleichung x � f x nennen wir auch Postfixpunkt vonf . Sei P = {d ∈ D | d � f d} die Menge der Postfixpunkte von f . Wir behaupten,dass die größte untere Schranke d0 der Menge P gerade der kleinste Fixpunkt von fist.Dazu beweisen wir zuerst einmal, dass d0 selbst in P enthalten ist, d.h. ein Postfix-punkt von f ist. Offenbar gilt f d0 � f d � d für jeden Postfixpunkt d ∈ P. Folglichist f d0 eine untere Schranke von P und damit kleiner oder gleich der größten unterenSchranke, d.h. f d0 � d0.

Als untere Schranke von P, die in P enthalten ist, ist d0 der kleinste Postfixpunktvon f . Es bleibt zu zeigen, dass f auch ein Fixpunkt von f und damit der kleinsteFixpunkt von f ist.

Wir wissen bereits, dass f d0 � d0 gilt. Betrachten wir die umgekehrte Richtung.Wegen der Monotonie von f , folgern wir, dass auch f ( f d0) � f d0 gilt. Folglich istf d0 ein Postfixpunkt von f , d.h. f d0 ∈ P. Weil aber d0 eine untere Schranke von Pist, muss dann auch d0 � f d0 gelten. ��

1.5 Exkurs: Vollständige Verbände 23

Satz 1.5.3 garantiert uns, dass jede monotone Funktion f in einem vollständigenVerband einen kleinsten Fixpunkt besitzt, welcher mit der kleinsten Lösung der Un-gleichung x � f x übereinstimmt.

Beispiel 1.5.3 Sei der vollständige Verband die Menge der natürlichen Zahlen, er-weitert um ∞, d.h. D = N ∪ {∞} mit der Halbordnung ≤. Die Funktion inc mitinc x = x + 1 ist monoton. Es gilt:

inci ⊥ = inci 0 = i � i + 1 = inci+1 ⊥Damit besitzt diese Funktion einen kleinsten Fixpunkt. Dieser wird aber nicht nachendlich vielen Iterationen erreicht. ��Indem wir Satz 1.5.3 auf den vollständigen Verband mit der dualen Ordnungsrelation� (anstelle von �) betrachten, folgern wir, dass jede monotone Funktion nicht nureinen kleinsten, sondern auch einen größten Fixpunkt besitzt.

Beispiel 1.5.4 Betrachten wir erneut den Teilmengenverband D = 2U für eineGrundmenge U und eine Funktion f mit f x = x ∩ a ∪ b. Diese Funktion ist mo-noton. Deshalb hat sie sowohl einen kleinsten wie einen größten Fixpunkt. UnserIterationsverfahren liefert für f :

f f k ⊥ f k �0 ∅ U1 b a ∪ b2 b a ∪ b

��

Wenden wir uns mit diesem Hintergrundwissen wieder unserer Anwendung zu, d.h.dem Lösen eines Ungleichungssystems

xi � fi(x1, . . . , xn), i = 1, . . . , n (∗)über einem vollständigen Verband D für monotone Funktionen fi : Dn → D. Wirwissen nun, dass ein solches Ungleichungssystem stets eine kleinste Lösung besitzt,die mit der kleinsten Lösung des zugehörigen Gleichungssystems

xi = fi(x1, . . . , xn), i = 1, . . . , n

übereinstimmt. In unseren Anwendungen bei der Programmanalyse treffen wir sehroft vollständige Verbände an, in denen es alle aufsteigenden Ketten stabil werden.In diesen Fällen kann die kleinste Lösung des Ungleichungssystems durch unserIterationsverfahren, d.h. wiederholtes Einsetzen explizit berechnet werden. Jedochist die naive Fixpunktiteration gemäß Satz 1.5.2 oft ziemlich ineffizient.

Beispiel 1.5.5 Betrachten wir erneut die Implementierung des Fakultätsprogrammsaus Beispiel 1.4.3. Die Fixpunktiteration zur Berechnung der kleinsten Lösung desUngleichungssystems für verfügbare Zuweisungen zeigt Abb. 1.6. Erst nach fünfRunden stabilisieren sich sämtliche Werte für die Unbekannten. ��

24 1 Grundlagen und intraprozedurale Optimierung

1 2 3 4 50 ∅ ∅ ∅ ∅ ∅1 {y ← 1} {y ← 1} ∅ ∅ ∅2 {y ← 1} {y ← 1} ∅ ∅ ∅3 ∅ ∅ ∅ ∅ ∅4 {y ← 1} ∅ ∅ ∅ ∅5 {y ← 1} {y ← 1} ∅ ∅ ∅

Abb. 1.6. Die naive Fixpunktiteration für das Programm aus Beispiel 1.4.3.

Wie könnte man die naive Fixpunktiteration verbessern? Eine erhebliche praktischeVerbesserung lässt sich durch die sogenannte Round-Robin-Iteration erzielen. Al-gorithmisch ist diese sogar leichter als die naive Iteration zu realisieren: man greiftbei der Neuberechnung der Werte für die Unbekannten nicht auf die Werte der Un-bekannten der letzten Runde zurück, sondern benutzt deren in der aktuellen Rundebereits berechneten Wert:

for (i ← 1; i ≤ n; i++) xi ← ⊥;do {

finished ← true;for (i ← 1; i ≤ n; i++) {

new ← fi(x1, . . . , xn);if (¬(xi � new)) {

finished ← false;xi ← xi � new;

}}

} while (¬finished);

Beispiel 1.5.6 Betrachten wir erneut das Ungleichungssystem zur Berechnung derverfügbaren Ausdrücke für das Fakultätsprogramm aus Beispiel 1.4.3. Die zugehö-rige Round-Robin-Iteration zeigt Abbildung 1.7. Offensichtlich reichen nun bereitsdrei Iterationen aus! ��Betrachten wir die Round-Robin-Iteration näher. Die Zuweisung xi ← xi � new;in unserer Implementierung überschreibt nicht einfach den alten Wert für xi, son-dern ersetzt ihn durch die kleinste obere Schranke mit dem neuen Wert. Wir sagen,dass der Algorithmus während seiner Iteration die Lösung für xi akkumuliert. ImFalle monotoner Funktionen fi ist die kleinste obere Schranke des alten Werts für xi

mit dem neuen Wert gerade gleich dem neuen Wert. Im Falle einer nicht-monotonenFunktion fi ist dies allerdings nicht immer der Fall. Dann ist der Algorithmus je-doch robust genug, eine aufsteigende Folge von Werten für jede Unbekannte xi zuberechnen und damit – im Falle der Terminierung – zumindest irgendeine Lösungdes Ungleichungssystems zu liefern.

1.5 Exkurs: Vollständige Verbände 25

1 2 30 ∅ ∅1 {y ← 1} ∅2 {y ← 1} ∅3 ∅ ∅ dito4 ∅ ∅5 ∅ ∅

Abb. 1.7. Die Round-Robin-Iteration für das Programm aus Beispiel 1.4.3.

Die Laufzeit des Verfahrens hängt davon ab, wie oft die do-while-Schleife durch-laufen wird. Sei h die maximale Länge einer echt aufsteigenden Kette:

⊥ � d1 � d2 � . . . � dh

in dem vollständigen Verband D. Diese Zahl nennen wir auch die Höhe des voll-ständigen Verbands D. Sei weiterhin n die Anzahl der Unbekannten des Unglei-chungssystems. Dann benötigt die Round-Robin-Iteration maximal h · n Runden derdo-while-Schleife, bis die Werte der kleinsten Lösung für sämtliche Unbekanntenermittelt sind — zusammen gegebenenfalls mit einer weiteren Runde, um die Termi-nierung festzustellen.

Die Abschätzung h · n kann auf n verbessert werden, wenn der vollständige Ver-band von der Form 2U ist für eine Grundmenge U ist, und wenn jede Funktion fi auskonstanten Mengen und Variablen alleine mithilfe der Operationen ∪ und ∩ aufge-baut ist. Dies liegt daran, dass in diesem Fall Enthaltensein eines Elements u ∈ Uin den Ergebnismengen für die Unbekannten xi unabhängig ist vom Enthaltenseinjedes anderen Elements u′ in diesen Mengen. Für welche Variablen xi das Elementu in dem Ergebnis für xi enthalten ist, kann deshalb über dem vollständigen Verband2{u} der Höhe 1 ausgerechnet werden und benötigt dort gerade n Iterationen. In-dem wir anstelle des vollständigen Verbands 2{u} bei der Round-Robin-Iteration denVerband 2U verwenden, führen wir gewissermaßen die Round-Robin-Iterationen fürjedes Element u ∈ U parallel aus.

Diese Abschätzungen betreffen nur den schlimmsten Fall. Bei geeigneter Anord-nung der Variablen wird die kleinste Lösung oft bereits mit weit weniger Iterationenerreicht.

Wir fragen uns, ob die neue Iterationsstrategie ebenfalls die kleinste Lösung lie-fert, wenn die naive Fixpunktiteration die kleinste Lösung geliefert hätte. Nehmenwir dazu an, die Funktionen fi seien sämtlich monoton. Sei y(d)

i die i-te Komponente

von Fd ⊥ und x(d)i der Wert von xi nach der d-ten Ausführung der do-while-Schleife

der Round-Robin-Iteration. Für alle i = 1, . . . , n und d ≥ 0 zeigen wir die folgendenAussagen:

26 1 Grundlagen und intraprozedurale Optimierung

1. y(d)i � x(d)

i � zi für jede Lösung (z1, . . . , zn) des Ungleichungssystems;2. terminiert die Round-Robin-Iteration, dann enthalten nach der Terminierung die

Variablen x1, . . . , xn die kleinste Lösung des Ungleichungssystems;3. y(d)

i � x(d)i .

Die Aussage (1) zeigt man mithilfe vollständiger Induktion. Wegen der ersten Aus-sage liegen alle Approximationen x(d)

i unterhalb des Werts der kleinsten Lösung fürdie Unbekannte xi. Terminiert die Round-Robin-Iteration nach der Runde d, dannerfüllen die Werte x(d)

i das Gleichungssystem und sind damit eine Lösung. Wegen(1) bilden sie sogar die kleinste Lösung. Damit folgt die Behauptung (2).

Aus der Aussage (1) können wir zusätzlich folgern, dass die Round-Robin-Iteration nach der d-ten Runde mindestens so größe Werte liefert wie die naiveFixpunktiteration. Terminiert deshalb die naive Fixpunktiteration nach der Runded, würde auch die Round-Robin-Iteration spätestens nach d Runden terminieren.

Wir schließen, dass die Round-Robin-Iteration niemals schlechter als die naiveFixpunktiteration ist. Nichtsdesoweniger kann auch die Round-Robin-Iteration mehroder weniger geschickt durchgeführt werden: tatsächlich hängt ihre Effizienz we-sentlich von der Anordnung ab, in der die Variablen durchlaufen werden.

Günstig ist es, wenn eine Variable xi, von der eine andere Variable xj abhängt,vor dieser neu ausgewertet wird. Im Falle eines Ungleichungssystems ohne zykli-sche Variablenabhängigkeiten können wir so sogar erreichen, dass bereits nach ei-nem Durchlauf der do-while-Schleife die kleinste Lösung erreicht wird.

Beispiel 1.5.7 Betrachten wir erneut das Ungleichungssystem zur Berechnung derverfügbaren Ausdrücke für das Fakultätsprogramm aus Beispiel 1.4.3. Abbildung1.8 zeigt eine günstige und eine ungünstige Anordnung der Unbekannten. Im ungün-

Günstig:

3

2

4

5

x ← x − 1

y ← x ∗ y

0

1

y ← 1

NonZero(x > 1)Zero(x > 1)

Ungünstig:

0

5

4

3

2

1

x ← x − 1

y ← x ∗ y

y ← 1

NonZero(x > 1)Zero(x > 1)

Abb. 1.8. Eine günstige und eine ungünstige Anordnung der Unbekannten.

stigen Fall benötigen wir für dieses Programm immerhin vier Iterationen (Abb. 1.9).��

1.6 Kleinste Lösung oder MOP–Lösung? 27

1 2 3 4 50 {y ← 1} {y ← 1} ∅ ∅1 {y ← 1} {y ← 1} {y ← 1} ∅2 ∅ ∅ ∅ ∅ dito3 {y ← 1} {y ← 1} ∅ ∅4 {y ← 1} ∅ ∅ ∅5 ∅ ∅ ∅ ∅

Abb. 1.9. Die Round-Robin-Iteration für die ungünstige Anordnung aus Abb. 1.8.

1.6 Kleinste Lösung oder MOP–Lösung?

Im letzten Abschnitt haben wir Verfahren kennen gelernt, um kleinste Lösungen vonUngleichungssystemen zu ermitteln. Was, müssen wir uns aber jetzt fragen, helfenuns diese kleinsten Lösungen wirklich?

Betrachten wir erneut einen vollständigen Verband D, wie er bei der Programm-analyse auftreten könnte, sowie ein Ungleichungssystem der Form

I [start] � d0

I [v] � [[k]]� (I [u]) k = (u, lab, v) Kante

wobei d0 ∈ D der Wert für den Startpunkt des Programms darstellt und alle ab-strakten Kanteneffekte [[k]]� : D → D monoton sind. Der generische Ansatz, für einAnalyseproblem einen vollständigen Verband auszuwählen, einen Startwert festzule-gen sowie die abstrakten Kanteneffekte durch monotone Funktionen zu beschreiben,heißt auch monotoner Analyserahmen. Mit weiteren Instanzen dieses allgemeinenAnsatzes werden wir uns in den nächsten Abschnitten ausführlich beschäftigen.

Für jeden Programmpunkt v wird der Wert:

I∗[v] =⊔{[[π ]]� d0 | π : start →∗ v}

gesucht. Die Abbildung I∗ heißt auch die Merge-Over-All-Paths-Lösung (kurz:MOP–Lösung) der Analyseaufgabe. Das Verhältnis zwischen der kleinsten Lösungdes Ungleichungssystems und der MOP–Lösung klärt der folgende Satz.

Satz 1.6.1 (Kam, Ullman 1975) Sei I die kleinste Lösung des Ungleichungssy-stems. Für jeden Programmpunkt v gilt

I [v] � I∗[v] .

Das heißt, für jeden Pfad π vom Programmstart nach v gilt:

I [v] � [[π ]]� d0 . (∗)Beweis. Wir beweisen die Aussage (∗) durch Induktion über die Länge von π . Istπ der leere Pfad, d.h. π = ε, dann gilt:

28 1 Grundlagen und intraprozedurale Optimierung

[[π ]]� d0 = [[ε]]� d0 = d0 � I [start]

Andernfalls ist π von der Form π = π ′k für eine Kante k = (u, lab, v). NachInduktionsannahme gilt die Behauptung bereits für den kürzeren Pfad π ′, d.h.[[π ′]]� d0 � I [u]. Damit folgern wir:

[[π ]]� d0 = [[k]]� ([[π ′]]� d0)� [[k]]� (I [u]) da [[k]]� monoton ist

� I [v] da I eine Lösung ist

Damit ist die Behauptungi bewiesen. ��In gewisser Weise ist Satz 1.6.1 eine Enttäuschung: eigentlich hatten wir gehofft, diekleinste Lösung wäre identisch mit der MOP–Lösung. Stattdessen müssen wir zurKenntnis nehmen, dass die kleinste Lösung im Allgemeinen nur eine obere Schran-ke für die MOP–Lösung liefert. In vielen praktischen Fällen stimmen jedoch dieFixpunktlösung und die MOP–Lösung überein. Dies ist insbesondere der Fall, wennalle Funktionen [[k]]� distributiv sind. Eine Funktion f : D1 → D2 heißt

• distributiv, falls f (⊔

X) =⊔{ f x | x ∈ X} für alle nichtleeren Teilmengen

X ⊆ D;• strikt, falls f ⊥ = ⊥;• total distributiv, falls f distributiv und strikt ist.

Beispiel 1.6.1 Betrachten wir den vollständigen Verband D = N ∪ {∞} mit dernatürlichen Ordnung ≤. Die Funktion inc mit inc x = x + 1 ist distributiv, erhältaber nicht das kleinste Element.

Als weiteres Beispiel betrachten wir die Funktion

add : (N∪ {∞})2 → (N∪ {∞})mit add (x1, x2) = x1 + x2, wobei der vollständige Verband (N ∪ {∞})2 kompo-nentenweise angeordnet ist. Dann haben wir:

add⊥ = add (0, 0) = 0 + 0 = 0

Deshalb ist die Funktion strikt. Sie ist aber nicht distributiv, wie das folgende Gegen-beispiel belegt:

add ((1, 4) � (4, 1)) = add (4, 4) = 8�= 5 = add (1, 4) � add (4, 1)

��Beispiel 1.6.2 Betrachten wir erneut den Teilmengenverband D = 2U mit der Hal-bordnung ⊆. Für alle a, b ⊆ U ist die Funktion f mit f x = x ∩ a ∪ b distributiv,da

1.6 Kleinste Lösung oder MOP–Lösung? 29

(⋃

X) ∩ a ∪ b =⋃{x ∩ a | x ∈ X} ∪ b

=⋃{x ∩ a ∪ b | x ∈ X}

=⋃{ f x | x ∈ X}

für jede nicht-leere Teilmenge X ⊆ D. Die Funktion f ist jedoch nur strikt, sofernb = ∅ gilt.

Ein analoges Resultat erhalten wir für den Teilmengenverband D = 2U mit derungekehrten Ordnung ⊇ und Funktionen f der Form f x = (x ∪ a) ∩ b. Für dieseHalbordnung bedeutet Distributivität nun, dass f (

⋂X) =

⋂{ f x | x ∈ X} git fürjede nicht-leere Teilmenge X ⊆ 2U . ��Tatsächlich gibt es eine genaue Charakterisierung aller distributiven Funktionen, so-fern ihr Definitionsbereich ein atomarer Verband ist. Sei A ein vollständiger Ver-band. Ein Element a ∈ A heißt atomar, falls a �= ⊥ ist und die einzigen Elementea′ ∈ A mit a′ � a die Elemente a′ = ⊥ und a′ = a sind. Der vollständige VerbandA heißt atomar, falls jedes Element d ∈ A die kleinste obere Schranke aller atomarenElemente a � d in A ist.

In dem vollständigen Verband N∪ {∞} aus Beispiel 1.6.1 ist 1 das einzige ato-mare Element. Deshalb ist dieser vollständige Verband nicht atomar. In dem Teil-mengenverband 2U , geordnet durch die Teilmengenrelation ⊆, sind die atomarenElemente gerade die einelementigen Teilmengen {u}, u ∈ U. In dem entsprechen-den Teilmengenverband mit der umgedrehten Ordnung ⊇ sind die atomaren Elemen-te durch die Mengen (U\{u}), u ∈ U, gegeben. Der folgende Satz sagt, dass füratomare Verbände distributive Funktionen eindeutig bestimmt sind durch ihre Wertefür das kleinste Element ⊥ und die atomaren Elemente.

Satz 1.6.2 Seien A und D vollständige Verbände, wobei A atomar ist. Sei A ⊆ A

die Menge der atomaren Elemente in A. Dann gilt:

1. Zwei distributive Funktionen f , g : A → D sind genau dann gleich, wennf (⊥) = g(⊥) und f (a) = g(a) für alle a ∈ A gelten.

2. Jedes Paar (d, h) mit d ∈ D und h : A → D definiert eine distributive Abbil-dung fd,h : A → D durch:

fd,h(x) = d � ⊔{h(a) | a ∈ A, a � x}, x ∈ A

Beweis. Wir zeigen nur die erste Behauptung. Sind die Funktionen f und g gleich,dann stimmen sie auch auf ⊥ und den atomaren Elementen von A überein. Für dieumgekehrte Richtung betrachten wir ein beliebiges Element x ∈ A. Für x = ⊥ giltf (x) = g(x) nach Voraussetzung. Für x �= ⊥ ist die Menge Ax = {a ∈ A | a � x}nicht leer. Deshalb schließen wir:

f (x) = f (⊔

Ax)=

⊔{ f (a) | a ∈ A, a � x}=

⊔{g(a) | a ∈ A, a � x} = g(x)

was zu beweisen war. ��

30 1 Grundlagen und intraprozedurale Optimierung

Beachten Sie, dass jede distributive Funktion f : D1 → D2 automatisch bereitsmonoton ist. Es gilt nämlich a � b genau dann, wenn a � b = b gilt. Falls a � bgilt, dann gilt

f b = f (a � b) = f a � f b

Folglich gilt f a � f b, was zu zeigen war. ��Für Programmanalysen mit distributiven Kanteneffekten finden wir:

Satz 1.6.3 (Kildall 1972) Sei jeder Programmpunkt v vom Startpunkt des Programmsaus erreichbar. Seien weiterhin sämtliche Kanteneffekte [[k]]� : D → D distributiv.Dann stimmt die kleinste Lösung I des Ungleichungssystems mit der MOP–LösungI∗ überein, d.h.

I∗[v] = I [v]

für alle Programmpunkte v.

Beweis. Wegen Satz 1.6.1 genügt es zu zeigen, dass I [v] � I∗[v] gilt für allev. Da I die kleinste Lösung des Ungleichungssystems ist, reicht es nachzuweisen,dass unter den gegebenen Voraussetzungen I∗ ebenfalls eine Lösung ist, d.h. alleUngleichungen erfüllt. Für den Startpunkt start des Programms gilt:

I∗[start] =⊔{[[π ]]� d0 | π : start →∗ start} � [[ε]]� d0 � d0

Für jede Kante k = (u, lab, v) überprüfen wir:

I∗[v] =⊔{[[π ]]� d0 | π : start →∗ v}

� ⊔{[[π ′k]]� d0 | π ′ : start →∗ u}=

⊔{[[k]]� ([[π ′]]� d0) | π ′ : start →∗ u}= [[k]]� (

⊔{[[π ′]]� d0 | π ′ : start →∗ u})= [[k]]� (I∗[u])

Dabei gilt die vorletzte Gleichung, weil die Menge {π ′ | π ′ : start →∗ u} allerPfade vom Startpunkt start nach u nicht-leer und der abstrakte Kanteneffekt [[k]]�distributiv ist. Wir folgern, dass I∗ sämtliche Ungleichungen erfüllt. Damit ist dieBehauptung bewiesen. ��Das folgende Beispiel zeigt, dass in Satz 1.6.3 nicht auf die Voraussetzung, dass alleProgrammpunkte auch wirklich erreichbar sind, verzichtet werden kann.

Beispiel 1.6.3 Betrachten wir den Kontrollflussgraphen aus Abbildung 1.10. Als

0 1 2inc7

Abb. 1.10. Ein Kontrollflussgraph zur Erreichbarkeit.

1.6 Kleinste Lösung oder MOP–Lösung? 31

vollständigen Verband wählen wir D = N∪ {∞} mit der natürlichen Ordnung ≤.Als einzigen Kanteneffekt nehmen wir die distributive Funktion inc. Dann gilt z.B.für einen beliebigen Anfangswert am Startpunkt des Programms: