Der Sprung in die Zukunft! Einführung in neuronale … · » 2007: Geoffrey Hinton – Learning...

Transcript of Der Sprung in die Zukunft! Einführung in neuronale … · » 2007: Geoffrey Hinton – Learning...

Inhalt

1. Warum auf einmal doch?

2. Welche Einsatzgebiete gibt es?

3. Was sind neuronale Netze und wie funktionieren sie?

4. Wie lernen neuronale Netze?

5. Welche Schwierigkeiten gibt es?

6. Fazit

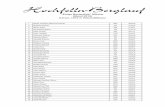

» Seit den 80ern in der Versenkung verschwunden» 1993 neuronales Netz erkennt Handschrift von Kamera

Quelle: https://www.youtube.com/watch?v=FwFduRA_L6Q

Quelle: https://devblogs.nvidia.com/parallelforall/deep-learning-nutshell-history-training

1. Warum auf einmal doch?

» Tageweises anlernen

» Nicht verstandenes Verhalten der neuronalen Netzwerke

» Kein Praxisbezug

» Fehlende Rechenleistung

» Zu wenig Eingangsdaten

» Support Vector Machines haben sie verdrängt

Winter der künstlichen Intelligenz von 1970 – 2007

Nummer 5 lebt!?

Quellen:http://www.forbes.com/sites/bernardmarr/2016/03/22/a-short-history-of-deep-learning-everyone-should-read/#6594600161b7https://cre.fm/cre208-neuronale-netze#t=1:27:24

1. Warum auf einmal doch?

» 1943: W. McCulloch, W. Pitts erstes mathematisches Model (threshold logic)

» 1958: Frank Rosenblatt erstes Perceptron

» 1989: Erste Multilayer-Netzwerke (Anlernzeit in Tagen)

» 2007: Geoffrey Hinton – Learning multiple layers of representation

» 2012: Erste künstliche Intelligenzen mit menschlicher Performance (Google discover cats) und AlexNet beleben neuronale Netzwerke

» 2015: Facebooks DeepFace identifiziert Personen

» 2015-2016: AlphaGo schlägt Fan Hui und Lee Sedol

2. Welche Einsatzgebiete gibt es?

» Bildverarbeitung & Mustererkennung

» Spracherkennung

» Universalübersetzung Google-Neural-Machine-Translation-System (GNMT)

» Prognosen anhand von Erfahrungen IBM Watson im Gesundheitswesen, Versicherung usw.

» Zeitreihenanalyse (z. Bsp. Wetter)

» Teilgebiete des autonomen Fahren

Science Fiction?

3. Was sind neuronale Netze und wie funktionieren sie?

» Ein mathematisches Modell

» Soll die Funktionsweise von Neuronen im Hirn simulieren

» Ist kein programmierter sondern ein angelernter Algorithmus, daher kann gleiches Netz kann auch anderen Algorithmus lernen

Populärwissenschaftlich erklärt:

Exakte Definition:https://de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz

Quelle: http://cs231n.github.io/neural-networks-1/

Quelle: http://www.turingfinance.com/misconceptions-about-neural-networks/

» 4k Bild (8 M Bildpunkte) = 8 M Input-Neuronen

» n Hidden Layer – Feature Erkennung

» k Output Neuronen für Bildbeschreibung

» 1 Output = ist Hund

» 2 Output = ist Katze

» ...

» 210 Output = hat rotes Fell

3. Was sind neuronale Netze und wie funktionieren sie?

AlexNet

3. Was sind neuronale Netze und wie funktionieren sie?

» Beispiel zeigt einen Pfad durch das Netzwerk

» z ist der l-te Output des Netzwerks

» Gut parallelisierbar, einfache Mathematik

» Fehler = Quadratische Kostenfunktion

» y(x) ist der erwartete Ergebnisvektor

» a ist das Ergebnis des Netzwerks für n Trainingsets

3. Wie lernen neuronale Netze?

» Kostenfunktion errechnet den Fehler (MSE – mean squared error)

» Netzwerk Gewichte und Bias so anpassen, dass Fehler kleiner wird

» Das Delta C soll minimiert werden

» Minimierung ist aber rechenintensiv

Quelle: http://www.andreykurenkov.com/writing/a-brief-history-of-neural-nets-and-deep-learning/

3. Wie lernen neuronale Netze?

» Kontinuierliches partielles Ableiten nach Gewicht und Bias durch die Schichten mit Hilfe von Gradient descent und dessen Formen

» Wie bekomme ich Delta wj ?

» http://cs.stanford.edu/people/karpathy/convnetjs/demo/mnist.html

» http://myselph.de/neuralNet.html

» https://www.youtube.com/watch?v=AgkfIQ4IGaM (1:35)

» Eta(η) ist die Lernrate

Beispiele:

5. Welche Schwierigkeiten gibt es?

» Zu hohe Lernrate kann zu große Deltas produzieren, sodass ein Minima nie erreicht wird

» Zu wenig Eingabedaten führen zum Overfitting was bei Produktivdaten zu falschen Ergebnissen führt

» Große Traingsdatensets erzeugen

» Falsche Netzwerkparameter führen zum Underfitting, also zu hoher Fehlern nach n Lernschritten