Nichtlineare Optimierung || Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Transcript of Nichtlineare Optimierung || Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

3 Lösungsverfahren fürOptimierungsprobleme ohneNebenbedingungen

Übersicht

3.1 Numerische Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 75

3.2 Das Newton-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche . . . . . . . . . . . . . . . . . . . 99

3.4 Modifizierte Newton-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 143

3.5 Quasi-Newton-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 175

3.6 Verfahren der konjugierten Gradienten (CG-Verfahren) . . . . . . . . . . . . . . . . . . 207

3.7 Trust-Region-Verfahren (TR-Verfahren) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 235

3.8 Verfahren für diskrete Approximationsprobleme . . . . . . . . . . . . . . . . . . . . . . . . . 268

3.9 Übungsaufgaben zu Kapitel 3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 284

3.1 Numerische Grundlagen

3.1.1 Konvergenzgeschwindigkeit

Für die Bewertung von iterativen Verfahren ist die Geschwindigkeit, mit der eine Itera-

tionsfolge {xk}k∈N ⊂ Rn gegen eine (lokale oder globale) Lösung x∗ ∈ Rn des Optimie-rungsproblems konvergiert, ein wichtiges Kriterium.

Definition 3.1 (Q-Konvergenzgeschwindigkeit)

Es seien {xk}k∈N ⊂ Rn und limk→∞xk = x∗. Die Folge {xk}k∈N konvergiert gegen x∗

R. Reinhardt et al., Nichtlineare Optimierung, DOI 10.1007/978-3-8274-2949-0_3,

© Springer-Verlag Berlin Heidelberg 2013

76 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

(a) Q-sublinear, wenn eine Folge {ck}k∈N mit limk→∞ck = 1 und ein k0 ∈ N existieren,

sodass

‖xk+1 − x∗‖ ≤ ck‖xk − x∗‖

(b) Q-linear mit dem Konvergenzfaktor C, wenn ein C ∈ (0, 1) und ein k0 ∈ N existie-

ren, sodass

‖xk+1 − x∗‖ ≤ C‖xk − x∗‖

(c) Q-superlinear, wenn eine positive Nullfolge {ck}k∈N und ein k0 ∈ N existieren,

sodass

‖xk+1 − x∗‖ ≤ ck‖xk − x∗‖

(d) Q-quadratisch, wenn ein C > 0 und ein k0 ∈ N existieren, sodass

‖xk+1 − x∗‖ ≤ C‖xk − x∗‖2

für alle k ∈ N mit k ≥ k0 gilt.

Offensichtlich gilt: Eine Folge {xk}k∈N ⊂ Rn konvergiert genau dann Q-sublinear, Q-

linear, Q-superlinear bzw. Q-quadratisch gegen x∗ ∈ Rn, wenn

• die Folge {xk − x∗}k∈N ⊂ Rn mit der entsprechenden Q-Konvergenzgeschwindigkeitgegen 0 ∈ Rn konvergiert.

• für alle α ∈ R \ {0} die Folge {αxk}k∈N ⊂ Rn mit der entsprechenden Q-

Konvergenzgeschwindigkeit gegen αx∗ konvergiert.

Weiterhin möchten wir bemerken, dass im Gegensatz zur Q-linearen und Q-superlinearen

Konvergenz bei der Definition der Q-sublinearen und Q-quadratischen Konvergenz einer

Folge {xk}k∈N gegen x∗ die Voraussetzung limk→∞xk = x∗ explizit gefordert werden muss

und die Eigenschaft der linearen Konvergenz abhängig von der gewählten Norm ist.

Die aufgeführten Definitionen zur Q-Konvergenzgeschwindigeit basieren auf dem Quoti-

entenkriterium zur absoluten Konvergenz von Reihen. Analog gibt es Definitionen zur

R-Konvergenzgeschwindigkeit, die sich auf das Wurzelkriterium beziehen (siehe z. B.

Ortega und Rheinboldt (1970)).

Definition 3.2 (R-Konvergenzgeschwindigkeit)

Es seien {xk}k∈N ⊂ Rn und limk→∞xk = x∗. Die Folge {xk}k∈N konvergiert R-linear,

R-superlinear bzw. R-quadratisch gegen x∗, wenn eine Q-lineare, Q-superlineare bzw.

Q-quadratische positive Nullfolge {εk}k∈N (als Majorante) und ein k0 ∈ R existieren,

sodass ‖xk − x∗‖ ≤ εk. für alle k ≥ k0 gilt.

3.1 Numerische Grundlagen 77

Offensichtlich folgt bei Vorliegen einer Q-Konvergenzgeschwindigkeit die entsprechende

R-Konvergenzgeschwindigkeit. Die hier definierte R-Konvergenzgeschwindigkeit ist genau

genommen eine Mindestgeschwindigkeit (siehe Abb. 3.2). Weitergehende Betrachtungen

findet man in Kosmol (1993) und detailliert in Schwetlick (1979). In den Abbildungen

3.1 und 3.2 zeigen wir anhand einfacher Folgen, wie eine entsprechende Q- bzw. R-

Konvergenzgeschwindigkeit in einer halblogarithmischen Darstellung zu erkennen ist.

0 10 20 30 40 50 60 70 80 90 10010−20

10−15

10−10

10−5

100

k

Q−sublinear, ck = k/(k+1), x

k= 1/k

Q−linear, C = 0.9, xk= 0.9k

Q−linear, C = 0.5, xk= 0.5k

Q−linear, C = 0.1, xk= 0.1k

Q−superlinear, ck= 1/k, x

k= (1/k)k

Q−quadratisch, C = 1, xk= 0.52

k

Abb. 3.1 Q-Konvergenzgeschwindigkeiten in halblogarithmischer Darstellung

0 10 20 30 40 50 60 70 8010−20

10−15

10−10

10−5

100

k

R−linear, xk = (0.5 + 0.05(−1)k)k

Schranke Q−linear, C = 0.55, εk= 0.55k

R−superlinear, xk = ((4 − 0.5(−1)k)/k)k

Schranke Q−superlinear, εk= (4.5/k)k

R−quadratisch, xk = (0.5 + 0.1(−1)k)2

k

Schranke Q−quadratisch, C = 0.6, εk= 0.62

k

Abb. 3.2 R-Konvergenzgeschwindigkeiten in halblogarithmischer Darstellung

78 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Für Funktionen f ∈ C1(Rn,R) bzw. f ∈ C2(Rn,R) kann aus der Q-Konvergenzge-

schwindigkeit einer Folge {xk}k∈N gegen x∗ auf die entsprechende R-Konvergenzge-

schwindigkeit der zugehörigen Funktionswertfolge {f(xk)}k∈N gegen f(x∗) bzw. der zu-gehörigen Gradientenfolge {∇f(xk)}k∈N gegen ∇f(x∗) geschlossen werden, wie der fol-gende Satz zeigt.

Satz 3.3

Es seien f ∈ C1(Rn,R) und {xk}k∈N eine gegen x∗ Q-linear, Q-superlinear bzw. Q-quadratisch konvergente Folge. Dann gilt:

(a) Die Folge der Funktionswerte {f(xk)}k∈N konvergiert in der entsprechenden R-

Konvergenzgeschwindigkeit gegen f(x∗).

Für f ∈ C2(Rn,R) gilt zusätzlich:

(b) Die Folge der Gradienten {∇f(xk)}k∈N konvergiert in der entsprechenden R-

Konvergenzgeschwindigkeit gegen ∇f(x∗).

Beweis: Es sei {xk}k∈N eine gegen x∗ Q-linear, Q-superlinear bzw. Q-quadratisch kon-vergente Folge. Wegen lim

k→∞xk = x∗ existiert ein k0 mit

‖o(x∗ − xk)‖ ≤ ‖x∗ − xk‖

für alle k ≥ k0.Zu (a): Für f ∈ C1(Rn,R) gilt

f(x∗) = f(xk) +∇f(xk)T (x∗ − xk) + o(‖x∗ − xk‖) ,

und es existiert ein K ≥ 0 mit ‖∇f(xk)‖ ≤ K für alle k ∈ N. Somit folgt∥∥f(xk)− f(x∗)∥∥ =∥∥∇f(xk)T (x∗ − xk) + o(‖x∗ − xk‖)∥∥

≤∥∥∇f(xk)T (x∗ − xk)∥∥+ ∥∥o(‖x∗ − xk‖)∥∥

≤∥∥∇f(xk)∥∥ ∥∥x∗ − xk∥∥+ ∥∥x∗ − xk∥∥

= (K + 1)∥∥xk − x∗∥∥

für alle k ≥ k0, womit die Konvergenz der Folge {f(xk)}k∈N gegen f(x∗) in der entspre-chenden R-Konvergenzgeschwindigkeit gezeigt ist.

Zu (b): Für f ∈ C2(Rn,R) existiert ein M ≥ 0 mit ‖∇2f(xk)‖ ≤M für alle k ∈ N, undes folgt analog in diesem Fall die Abschätzung

‖∇f(xk)−∇f(x∗)‖ ≤ (M + 1) ‖xk − x∗‖

3.1 Numerische Grundlagen 79

für alle k ≥ k0 und somit die Konvergenz der Folge {∇f(xk)}k∈N gegen ∇f(x∗) in derentsprechenden R-Konvergenzgeschwindigkeit. �

Wenn die Funktion f in einer konvexen Umgebung eines stationären Punktes x∗ gleich-mäßig konvex ist, dann kann wiederum unter zusätzlichen Differenzierbarkeitsvorausset-

zungen aus der Konvergenzgeschwindigkeit der Funktionswerte oder Gradienten auch auf

die Konvergenzgeschwindigkeit der Iterierten geschlossen werden. Aus diesem Grunde ist

die (lokale) gleichmäßige Konvexität der Zielfunktion eine entscheidende Voraussetzung

bei Konvergenzsätzen für Verfahren der Optimierung.

Satz 3.4

Die Funktion f ∈ C1(Rn,R) sei gleichmäßig konvex über einer konvexen Umgebung Uvon x∗ ∈ Rn mit ∇f(x∗) = 0. Ferner existiere ein k0 mit xk ∈ U für alle k ≥ k0. Danngilt:

(a) Konvergiert die Folge {f(xk) − f(x∗)}k∈N Q-linear, Q-superlinear bzw. Q-

quadratisch gegen 0, dann konvergiert die Folge {‖xk − x∗‖}k∈N in der entspre-

chenden R-Geschwindigkeit gegen 0.

Für f ∈ C2(Rn,R) gilt zusätzlich:

(b) Konvergiert eine der Folgen

{f(xk)− f(x∗)}k∈N, {‖∇f(xk)‖}k∈N oder {‖xk − x∗‖}k∈N

Q-superlinear bzw. Q-quadratisch gegen 0, dann sind die jeweils beiden anderen

Folgen ebenfalls Q-superlinear bzw. Q-quadratisch gegen 0 konvergent.

(c) Konvergiert eine der Folgen

{f(xk)− f(x∗)}k∈N, {‖∇f(xk)‖}k∈N oder {‖xk − x∗‖}k∈N

Q-linear gegen 0, dann sind die jeweils beiden anderen Folgen R-linear gegen 0

konvergent.

Wir möchten an dieser Stelle auf den Beweis von Satz 3.4 verzichten und verweisen

diesbezüglich auf Aufgabe 3.2.

Bemerkung 3.5

Bei den später betrachteten numerischen Verfahren werden wir anhand von Experimen-

ten auch solche charakteristischen Eigenschaften der Verfahren aufzeigen, die sich nicht in

mathematischen Sätzen formulieren lassen. In den entstehenden Tabellen und Abbildun-

gen findet man endlich viele Glieder der Folgen der Funktionswerte („fiter“) und der

Gradientennormen („err“), wobei sich der maximale Index k durch ein entsprechendes

80 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Abbruchkriterium ergibt. Aus den ersten k+1 Gliedern einer Folge mit Startpunktindex

k = 0 kann man natürlich nicht auf die Konvergenzgeschwindigkeit der gesamten Folge

schließen, sondern nur eine Tendenz feststellen. Diese Tendenzen erkennt man häufig be-

reits bis zum Abbruch des Verfahrens. Bei superlinearer bzw. quadratischer Konvergenz

ist diese Tendenz oftmals jedoch erst kurz vor dem Abbruch des Verfahrens festzustel-

len. Wir formulieren dann in den Experimenten, dass man in den Tabellenbzw. Abbildungen die lineare, superlineare bzw. quadratische Konvergenzge-

schwindigkeit erkennen kann, meinen aber immer, dass eine Tendenz dazu

feststellbar ist. Auch spezifizieren wir hier (im Gegensatz zu den theoretischen Kon-

vergenzaussagen) nicht, ob Q- oder R-lineare Konvergenz vorliegt. Wir sprechen in den

Experimenten einfach von linearer, superlinearer bzw. quadratischer Konvergenz. Man

erkennt bei einer abgebrochenen positiven Nullfolge, beispielsweise der Folge der Gra-

dientennormen, eine Tendenz zur linearen (superlinearen) Konvergenz an der linearen

(schneller als linearen) Zunahme der führenden (Nachkomma-)Nullen. Bei quadratischer

Konvergenz verdoppeln sich faktisch von Iteration zu Iteration die korrekten führenden

Nullen. Bei Exponentialschreibweise der Zahlen erkennt man dies gut an dem Exponenten

in der Zehnerpotenz. �

3.1.2 Symbolische, automatische und numerische Differenziation

Symbolische Differenziation (SD)

Wenn wir von symbolischer Differenziation sprechen, dann verstehen wir darunter, dass

die analytischen Formeln für die Gradienten und Hesse-Matrizen aus der analytischen

Darstellung der zugehörigen Funktion berechnet werden (also z. B. unter Matlab als

m-File). Diese analytischen Ausdrücke können aufwendig per Hand oder maschinell durch

Formelmanipulationssoftware wie z. B. Mathematika®1 oder Maple™2 bestimmt werden.

Unter EdOptLab wird dies mit der Symbolic Math Toolbox von Matlab realisiert,

indem aus einem m-File zur Beschreibung des Optimierungsproblems (Problem m-File)

die m-Files für die Problemfunktion (func0.m) und ihre ersten (grad0.m) und zweiten

partiellen Ableitungen (hess0.m) erzeugt werden.

Automatische Differenziation (AD)

Die automatische Differenziation wurde in den vergangenen 25 Jahren entwickelt. Es

existieren eine Reihe von diesbezüglichen Software-Paketen, wie z. B. Adol C (siehe

Griewank et. al. (1996)) bzw. Intlab (siehe Rump (1999)) zur Einbindung unter C++

1Mathematika® ist ein eingetragenes Warenzeichen der Firma Wolfram Research, U.S.A.,http://www.wolfram.com

2Maple™ ist ein eingtragenes Warenzeichen der Firma Waterloo Maple Inc.,Kanada,www.maplesoft.com

3.1 Numerische Grundlagen 81

bzw. Matlab. Im Folgenden geben wir eine kurze Einführung zur AD. Für ein tieferes

Studium empfehlen wir Griewank und Walther (2008).

Um die AD benutzen zu können, benötigt man wie bei der SD einen Code für die ana-

lytische Darstellung der Funktion. Unter Matlab ist dies z. B. ein m-File. Die Software

zur AD berechnet eine analytische Darstellung der ersten bzw. zweiten Ableitungen.

Die AD zerlegt zu diesem Zweck eine Funktion f ∈ C1(Rn,R), deren Gradient zu ermit-teln ist, unter Berücksichtigung bekannter Differenziationsregeln in eine endliche Anzahl

„elementarer Funktionen“ fi (unäre und binäre Funktionen), sodass sich die Funktion f

und ihr Gradient sukzessive aus diesen fi und ihren Ableitungen an einer gewünschten

Stelle x berechnen lassen.

Es seien f ∈ C1(Rn,R) und fi ∈ C1(Rni ,R), i = n+ 1, . . . ,m (m > n) gemäß vorliegen-

der AD-Software auswertbare elementare Funktionen. Jede dieser Funktionen fi sei von

xk, k ∈ Ji, | Ji |= ni ≤ 2 Variablen abhängig, und f sei wie folgt aus diesen elementaren

Funktionen berechenbar:for i = n+ 1 : 1 : m

xi := fi(xk, k ∈ Ji);end;

f(x) = xm;

(3.1)

Im Folgenden erläutern wir am Beispiel der sogenannten zweidimensionalen Rosenbrock-

Funktion (wegen der Gestalt ihrer Höhenlinien auch Bananen-Funktion genannt)

f : R2 → R mit f(x) := 100(x21 − x2)

2 + (1− x1)2

das Prinzip der AD, wenn eine Zerlegung der zu differenzierenden Funktion in elemen-

tare Funktionen bekannt ist. Wie die AD-Software erkennt, aus welchen elementaren

Bestandteilen sich die Funktion zusammensetzt, beschreiben wir an dem Beispiel nicht.

Zunächst definieren wir für das Beispiel zusätzliche Variablen x3 bis x9 bzw. Funktionen

f3 bis f9 wie folgt:

x3 = f3(x1) := x21 ,

x4 = f4(x2, x3) := x3 − x2 ,

x5 = f5(x4) := x24 ,

x6 = f6(x5) := 100x5 ,

x7 = f7(x1) := 1− x1 ,

x8 = f8(x7) := x27 ,

x9 = f9(x6, x8) := x6 + x8 ,

f(x1, x2) = x9 .

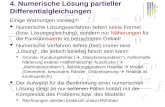

Diese Zerlegung von f wird durch den gerichteten Graphen G = (V,E) gemäß Abb. 3.3

repräsentiert.

82 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

x2

x1

x3 = f

3(x

1)

x4 = f

4(x

2,x

3)

x5 = f

5(x

4)

x6 = f

6(x

5)

x7 = f

7(x

1)

x8 = f

8(x

7)

x9 = f

9(x

6,x

8)

2 1

3

4

5

6

7

8

9

Abb. 3.3 Graph der Zerlegung für die zweidimensionale Rosenbrock-Funktion in elementareFunktionen

Die Indexmengen Ji aus (3.1) für i = 3, . . . , 9 entsprechen dabei den Knotenmengen der

Bögen (j, i) ∈ E, die den Endknoten i besitzen (Indexmenge der unmittelbaren Vorgängerdes Knotens i).

Es gilt für das Beispiel:

J3 = {1}, J4 = {2, 3}, J5 = {4}, J6 = {5}, J7 = {1}, J8 = {7}, J9 = {6, 8}.

Wir können nun zusammen mit der sukzessiven Berechnung (der Werte) der Funktionen

fi entsprechend (3.1) bzw. der xi, i = 3, . . . , 9 auch die (totalen) Gradienten �xi :=�fi(xk, k ∈ Ji) der elementaren Funktionen bzgl. der Variablen x1, x2 berechnen.

Wir erhalten zunächst

�x1 = (∂x1

∂x1,∂x1

∂x2)T = (1, 0)T , �x2 = (0, 1)T

und berechnen weiter mit den üblichen Differenziationsregeln

�x3 = 2x1 � x1 ,

�x4 = �x3 −�x2 ,

�x5 = 2x4 · �x4 ,

�x6 = 100� x5 ,

�x7 = −� x1 ,

�x8 = 2x7 � x7 ,

�x9 = �x6 +�x8 ,

�f = �x9 .

3.1 Numerische Grundlagen 83

Sukzessives Einsetzen bestätigt das erwartete Resultat:

�f(x1, x2) =

(400(x2

1 − x2)x1 − 2(1− x1)

−200(x21 − x2)

).

Setzt man voraus, dass die Struktur des Graphen G und die Bewertungen fi der Knoten

V gespeichert sind, so können Funktionswerte und partielle Ableitungen in einfacher

Weise in dem sogenannten Vorwärts-Mode (engl. forward mode) wie folgt „synchron“ be-

rechnet werden:

x1 = 2, x2 = 2 �x1 = (1, 0)T , �x2 = (0, 1)T

· · · · · · · · · · · · · · · · · · · · · · · · · · ·x3 = 4 �x3 = (4, 0)T

x4 = 2 �x4 = (4,−1)T

x5 = 4 �x5 = (16,−4)T

x6 = 400 �x6 = (1600,−400)T

x7 = −1 �x7 = (−1, 0)T

x8 = 1 �x8 = (2, 0)T

x9 = 401 �x9 = (1602,−400)T

· · · · · · · · · · · · · · · · · · · · · · · · · · ·f = 401 �f = (1602,−400)T

Man erkennt, dass simultan zur Berechnung des Gradienten auch der Funktionswert be-

rechnet wird und bei der Berechnung der Hesse-Matrix gleichzeitig sowohl der Gradient

als auch der Funktionswert berechnet werden. Bei der SD werden im Gegensatz dazu der

Funktionswert, der Gradient und die Hesse-Matrix unabhängig voneinander berechnet.

Der Vorwärtsmode der AD wird von dem unter EdOptLab verwendeten AD-Tool Int-

lab V 5.5 (siehe Rump (1999)) benutzt. Der numerische Aufwand zur Berechnung des

Gradienten liegt lt. Theorie dabei in der gleichen Größenordnung wie der für eine nume-

rische Approximation des Gradienten − ist also proportional zur Anzahl n der Variablen

der Funktion f . Das Experiment 3.1.1 zeigt aber bezüglich der benötigten CPU-Zeiten

große Unterschiede.

Neben dem Vorwärts-Mode ist der sogenannte Rückwärts-Mode (engl. reverse mode)

von Bedeutung. Dabei beginnt man mit der letzten elementaren Funktion, im Beispiel

x9 = f9(x8, x6) und leitet diese Funktion unter Benutzung der Kettenregel und der ele-

mentaren Zerlegung von f nach allen Veränderlichen x8, ..., x1 ab. Zum Schluss entstehen

dann im Beispiel die gesuchten Ableitungen nach x1 bzw. x2. Der Nachteil bei dieser

Methode ist, dass alle Zwischenergebnisse geeignet gespeichert werden müssen. Bemer-

84 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

kenswert ist dagegen, dass für den Rückwärts-Mode in Griewank und Walther (2000)

gezeigt wurde, dass der Aufwand für die Berechnung des Gradienten das Fünffache des

Rechenaufwandes für den Funktionswert von f nicht übersteigt, wenn die fi nicht von n

abhängen.

Eine effektive Implementierung von Algorithmen zur AD unter unterschiedlichen Ge-

sichtpunkten (Rechenzeit, Speicherbedarf) und für unterschiedliche Anwendungen ( Op-

timierung, Differenzialgleichungen, Optimale Steuerung) beschäftigt Informatiker und

Mathematiker seit etwa zwei Jahrzehnten. Es gibt im Internet unter dem Stichwort „au-

tomatic differentiation“ eine Fülle von Hinweisen zu freier und kommerzieller Software.

Numerische Differenziation (ND)

Der wesentliche Vorteil bei der SD und AD besteht darin, dass die Ableitungen im Rah-

men der möglichen Floating-Point Arithmetik (8, 16 oder mehr Stellen bei C++ oder ca.

16 Stellen bei Matlab) genau berechnet werden. Im Gegensatz dazu entstehen bei der

numerischen Differenziation Fehler durch die Approximation der Ableitungen mittels fi-

niter Differenzen. In der Optimierung verwendet man fast immer nur Vorwärtsdifferenzen

und approximiert

• Gradienten durch erste Vorwärtsdifferenzen der Funktionswerte:

∂f(x)

∂xk=f(x+ hek)− f(x)

h+O(‖h‖) ,

• Hesse-Matrizen durch erste Vorwärtsdifferenzen der Gradienten:

∂2f(x)

∂xk∂xj=

f(x+hek)∂xj

− f(x)∂xj

h+O(‖h‖) ,

• Hesse-Matrizen durch zweite Vorwärtsdifferenzen der Funktionswerte:

∂2f(x)

∂xk∂xj=f(x+ h(ek + ej))− f(x+ hek)− f(x+ hej) + f(x)

h2+O(‖h‖) .

Mit ersten zentralen Differenzen (siehe Hoffmann et al. (2005, 2006), S. 581) erreicht

man einen kleineren Fehler von O(‖h‖2), wobei sich der Aufwand in etwa verdoppelt.

Die ND findet dort Anwendung, wo es unmöglich oder nur mit einem unvertretbar hohen

Aufwand möglich ist, die Ableitungen analytisch zu bestimmen. Außerdem kann man

die ND zu Kontrollzwecken benutzen, insbesondere dann, wenn die Ableitungen vom

Nutzer „per Hand“ berechnet worden sind. An zwei Experimenten demonstrieren wir,

welchen Einfluss die Wahl des Inkrementes h auf die Genauigkeit der Approximation der

Ableitung durch erste Vorwärtsdifferenzen hat.

3.1 Numerische Grundlagen 85

Experiment 3.1.1 (Numerische Approximation der 1. Ableitung )

gradapprox.m: Die Ableitung der Funktion f : R → R mit f(x) := sin(x) wird an der

Stelle x = 2 durch (erste) Vorwärts-Differenzenquotienten

f(x+ h)− f(x)h

approximiert. In Tab. 3.1 wird der Fehler zwischen exakter Ableitung und dem Differen-

zenquotienten in Abhängigkeit vom Inkrement h protokolliert.

Das Experiment bestätigt in etwa die Empfehlung (siehe Dennis und Schnabel (1983))

für die Wahl des Inkrementes h gemäß

h := max{√macheps |xi|,

√macheps

}sign(xi) (3.2)

bei ersten Differenzenquotienten, wobei macheps die Maschinengenauigkeit bezogen auf

die Zahl 1 darstellt. Dabei versucht man mit dem Faktor sign(xi) der Auslöschung von

Stellen zu begegnen, wenn x nahe Null ist. In Tab. 3.1 ist das gegensätzliche Wirken des

Approximationsfehlers∣∣∣ f(x+h)−f(x)

h− f ′(x)

∣∣∣ für die Ableitung und des Auslöschungsfeh-lers 2

∣∣∣ f(x)δh

∣∣∣ beim Differenzenquotienten gut zu erkennen. Wo beide Fehler sich die Waage

halten, erhalten wir die beste Approximation der ersten Ableitung. �

---------------------------------------------------

h df/dx Vorw. Diff error

---------------------------------------------------

1e -001 -0.416146837 -0.460880602 4.47e -002

1e -002 -0.416146837 -0.420686350 4.54e -003

1e -003 -0.416146837 -0.416601416 4.55e -004

1e -004 -0.416146837 -0.416192301 4.55e -005

1e -005 -0.416146837 -0.416151383 4.55e -006

1e -006 -0.416146837 -0.416147291 4.55e -007

1e -007 -0.416146837 -0.416146881 4.49e -008

1e -008 -0.416146837 -0.416146839 2.66e -009

1e -009 -0.416146837 -0.416146895 5.82e -008

1e -010 -0.416146837 -0.416147117 2.80e -007

1e -011 -0.416146837 -0.416144896 -1.94 e -006

1e -012 -0.416146837 -0.416222612 7.58e -005

1e -013 -0.416146837 -0.416333634 1.87e -004

1e -014 -0.416146837 -0.421884749 5.74e -003

1e -015 -0.416146837 -0.333066907 -8.31 e -002

1e -016 -0.416146837 0.000000000 -4.16 e -001

---------------------------------------------------

Die Wurzel aus macheps =2.22 e -016 ergibt : 1.49e -008

---------------------------------------------------

Tab. 3.1 Erste Vorwärtsdifferenzen zur Approximation der 1. Ableitung von sin(x) an der Stellex = 2 im Exp. 3.1.1

86 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Experiment 3.1.2 (Numerische Approximation der Hesse-Matrix )

hessapprox.m: Die Hesse-Matrix der Funktion

f : R2 → R mit f(x) := (x1 − 2)4 + x22(x1 − 2)2 + (x2 + 1)2

wird an der Stelle x = (1, 1)T durch erste Vorwärtsdifferenzen der Gradienten und zweite

Vorwärtsdifferenzen der Funktionswerte approximiert, wobei bei den zweiten Vorwärts-

differenzen für das Inkrement h := max{EPS|xi|, EPS} die folgenden Werte von EPSgewählt werden:

EPS = 10−8, EPS =√macheps ≈ 1.5× 10−8 und EPS = 3

√macheps ≈ 6.1× 10−6.

Offensichtlich ist die Wahl von h gemäß (3.2) für zweite Vorwärtsdifferenzen zur Appro-

ximation der Hesse-Matrix nicht geeignet. Der größere Wert (siehe Dennis und Schnabel

(1983))

h := max{

3√macheps |xi|, 3

√macheps

}sign(xi)

liefert hier eine „halbwegs brauchbare“ Approximation (siehe Tab. 3.2).

Als Schlussfolgerung ergeben sich bei Anwendung der zweiten Differenzenquotienten zur

Approximation der Hesse-Matrix für Lösungsverfahren starke Einschränkungen in Bezug

auf die Genauigkeit. �

Berechnung der exakten Hesse - Matrix :

------------------------------------------------------

14.0000000000000000 -4.0000000000000000

-4.0000000000000000 4.0000000000000000

Approximation : Inkrement h=max ( EPS * abs (x), EPS )

------------------------------------------------------

1. Vorwärtsdiff. der Gradienten und EPS = 1.5 E -008:

------------------------------------------------------

13.9999998211860660 -4.0000000000000000

-4.0000000000000000 4.0000000000000000

2. Vorwärtsdiff. der Funktionswerte und EPS = 1.0 E -008:

------------------------------------------------------

8.8817841970012505 -6.6613381477509375

-6.6613381477509375 0.0000000000000000

2. Vorwärtsdiff. der Funktionswerte und EPS = 1.5 E -008:

------------------------------------------------------

12.0000000000000000 -3.0000000000000000

-3.0000000000000000 8.0000000000000000

2. Vorwärtsdiff. der Funktionswerte und EPS = 6.1 E -006:

------------------------------------------------------

13.9998715884840480 -2.9999932448047044

-2.9999932448047044 3.9999183276195103

Tab. 3.2 Erste und zweite Vorwärtsdifferenzen zur Approximation der Hesse-Matrix für dieFunktion aus Exp. 3.1.2 an der Stelle x = (1, 1)T

3.1 Numerische Grundlagen 87

Experiment 3.1.3 (CPU-Zeit-Vergleich der Differenziationstechniken)

vergldiff01.m, vergldiff02.m: Zur Demonstration der Geschwindigkeiten für die ein-

zelnen Differenziationstechniken unter Matlab 7.4. betrachten wir die n-dimensionale

Rosenbrock-Funktion (Problem Nr. 50, Dimension n = 20, 30, . . . , 100)

f : R2 → R mit f(x) :=n−1∑k=1

(100(x2

k − xk+1)2 + (1− xk)2

)(3.3)

und berechnen die Gradienten (siehe Abb. 3.4) und Hesse-Matrizen (siehe Abb. 3.5) mit

Vorwärtsdifferenzen, AD (Intlab V 5.5 AD Tool ohne Sparse - Technik) sowie SD (Er-

zeugung eines m-Files für die jeweiligen Ableitungen).

Sehr deutlich zeigt sich die Überlegenheit sowohl der AD als auch der SD gegenüber der

ND. Bei der Berechnung der Hesse-Matrizen verstärkt sich dieser Effekt bei Benutzung

der zweiten Differenzen. Berücksichtigt man zusätzlich die Zeiten für die einmalige Er-

zeugung der m-Files des Gradienten und der Hesse-Matrizen bei der SD (im Beispiel und

für den verwendeten Rechner bei Dimension 50 ca. 15 Sekunden und bei Dimension 100

ca. 30 Sekunden für Gradient und Hesse-Matrix), dann ist die AD gegenüber der SD zu

bevorzugen, erst recht, wenn Sparse-Techniken bei der AD genutzt werden können. Die

Benutzung von Vorwärtsdifferenzen sollte nur in dem Fall erfolgen, wenn keine AD oder

SD möglich ist. In EdOptLab ist die AD aus den oben genannten Gründen als Standard

eingestellt. Durch Änderung des Parameters „diffmode“ kann sowohl die SD als auch

die ND verwendet werden. �

20 30 40 50 60 70 80 90 10010−4

10−3

10−2

10−1

Dimension der Rosenbrock−Funktion

CPU

Zei

t in

Seku

nden Vorwärtsdifferenzen

AD mit INTLABSD

Abb. 3.4 CPU-Zeit zur Berechnung der Gradienten der Rosenbrock-Funktion mit ersten Vor-wärtsdifferenzen, AD und SD im Exp. 3.1.3

88 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

20 30 40 50 60 70 80 90 10010−4

10−3

10−2

10−1

100

101

102

Dimension der Rosenbrock−Funktion

CPU

Zei

t in

Seku

nden

2. Vorwärtsdifferenzen der Funktionswerte1. Vorwärtsdifferenzen der GradientenAD mit INTLABSD

Abb. 3.5 CPU-Zeit zur Berechnung der Hesse-Matrizen der Rosenbrock-Funktion mit erstenund zweiten Vorwärtsdifferenzen, SD und AD im Exp. 3.1.3

3.1.3 Abbruchkriterien für Verfahren zur Lösung vonOptimierungsproblemen ohne Nebenbedingungen

Bei einer Implemetierung von Algorithmen benötigen wir Kriterien für den Abbruch

der zu berechnenden Folge {xk}k∈N, wobei der letzte Iterationspunkt eine geeignete

Näherungslösung der betrachteten Minimierungsaufgabe sein soll (Bertsekas (1999), S.

36/37, Fletcher (1987), S. 23, Schwetlick (1979), S. 80, 126 und Dennis und Schnabel

(1983), S. 159-161). Zunächst erscheint es sinnvoll, für einen vorgegebenen absoluten

Abstand εx > 0 zur Lösung x∗ bzw. εf > 0 zum Minimum f(x∗) die Kriterien

‖xk − x∗‖ < εx und |f(xk)− f(x∗)| < εf

zu verwenden. Wegen der Unkenntnis der Lösung bzw. des Funktionswertes am Lösungs-

punkt sind diese Kriterien i. Allg. nicht handhabbar. Aus den inkrementellen Kriterien

‖xk+1 − xk‖ < ε und |f(xk+1)− f(xk)| < ε

kann man ohne spezielles Wissen über die theoretische Konvergenzgeschwindigkeit der

Iterationsfolge nichts über die Nähe der Iterationspunkte zur Lösung aussagen. Setzt

man z. B. xk =k∑j=1

1j, so folgt lim

k→∞‖xk+1 − xk‖ = lim

k→∞1k+1

= 0, aber limk→∞xk = ∞.

Wird die Folge der Iterationspunkte z. B. über einen kontrahierenden Operator T gemäß

xk+1 = Txk mit der globalen Kontraktionsbedingung ‖Tx−Ty‖ ≤ c‖x−y‖ und mit der

3.1 Numerische Grundlagen 89

festen Konstante 0 ≤ c < 1 erzeugt, dann gelten nach dem Banachschen Fixpunktsatz

die Abschätzungen

‖xk+1 − x∗‖ ≤ c

1− c‖xk+1 − xk‖ sowie ‖xk+1 − x∗‖ ≤ c

n+1

1− c‖x1 − x0‖ ,

und die inkrementelle Abbruchbedingung ist ein probates Mittel, eine Näherungslösung

im Rahmen der vorgegebenen Genauigkeit zu bestimmen.

Gilt xk �= x∗ für alle k, so ist die Q-superlineare Konvergenz äqiuvalent zu

limk→∞

‖xk+1 − x∗‖‖xk − x∗‖ = 0 ,

und es folgt

0 = limk→∞

‖xk+1 − x∗‖‖xk − x∗‖ = lim

k→∞

∣∣∣∣‖xk+1 − xk‖ − ‖xk − x∗‖‖xk − x∗‖

∣∣∣∣ = limk→∞

∣∣∣∣‖xk+1 − xk‖‖xk − x∗‖ − 1

∣∣∣∣bzw.

limk→∞

‖xk+1 − xk‖‖xk − x∗‖ = 1.

Im Fall Q-superlinearer Konvergenz kann somit als Abbruchkriterium für numerische

Lösungsverfahren die Bedingung ‖xk+1−xk‖ ≤ ε mit einem fest vorgegebenen (kleinen)

ε prinzipiell genutzt werden. Eine quantitative Abstandsabschätzung zum Lösungspunkt

wie beim Banachschen Fixpunktsatz ist damit aber nicht gegeben.

Deshalb nutzt man bei der restriktionsfreien Minimierung als Abbruchbedingung die

näherungsweise Erfüllung der notwendigen Optimalitätsbedingung, d. h. man bricht ab,

wenn

‖∇f(xk)‖ < ε (3.4)

gilt. Bei unseren folgenden Experimenten benutzen wir in den Tabellen die Bezeichnung

err = norm(g) = ‖∇f(xk)‖. Jedoch erhalten wir durch (3.4) i. Allg. keine Informationüber den Abstand von xk zur Lösung x∗. Im Falle der gleichmäßigen Konvexität von f

gilt zwar die Abschätzung

‖xk − x∗‖ ≤ 1

m‖∇f(xk)‖ ,

jedoch ist in der Regel die Konstante m nicht bekannt. Die oft benutzte Abbruchbe-

dingung (3.4) besitzt noch eine Reihe weiterer Nachteile. Oft ist es besser, das relative

Abbruchkriterium

‖∇f(xk)‖ < ε‖∇f(xtyp)‖ ,

zu verwenden, wobei xtyp einen für die Funktion f „typischen“ x-Wert darstellt. Mit

diesem relativen Abbruchkriterium würde aber bei der Minimierung von f oder αf, α > 0

ein Verfahren jeweils nach der gleichen Anzahl von Iterationen abbrechen, was bei einem

absoluten Abbruchkriterium natürlich nicht der Fall ist.

90 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Wir benutzen in unseren Experimenten stets die Abbruchbedingung (3.4), auch wenn

sie die aufgeführten Nachteile besitzt. Ist die Bedingung (3.4) erfüllt, dann wurde erfolg-

reich eine Näherungslösung im Rahmen der vorgegebenen Genauigkeit ε > 0 gefunden.

Es kann jedoch passieren, dass ein Verfahren keinen stationären Punkt findet oder die

Anzahl der Iterationen sehr groß wird. Um auch diese Fälle zu berücksichtigen, werden

Absicherungen zur Beendigung des Verfahrens nach endlicher Zeit − sogenannte Safe-

guards − getroffen. Das sind z. B.

1 Überschreiten einer vorgegebenen Iterationsanzahl „maxit“

2 Überschreiten einer vorgegebenen Anzahl von Funktionswertberechnungen

3 Überschreiten einer vorgegebenen CPU-Zeit

4 Unterschreiten eines vorgegebenen Abstandes zwischen aufeinanderfolgenden Iterati-

onspunkten oder Funktionswerten

5 Unterschreiten einer vorgegebenen positiven Schrittlänge (siehe Abschnitt 3.3)

6 Unterschreiten einer vorgegebenen Länge der berechneten Suchrichtung (siehe Ab-

schnitt 3.3)

7 Unterschreiten einer vorgegebenen Schranke für die Funktionswerte

8 Auftreten von nicht verarbeitbaren Zahlenformate (nan’s, inf etc. in Matlab)

Die Safeguards 1, 4, 5, 6, 7 und 8 werden z. T. auch bei unseren Experimenten benutzt.

Die unter EdOptLab programmierten Verfahren zeigen das jeweilige Abbruchkriterium

an. In den „theoretischen“ Algorithmen benutzen wir als Abbruchbedingung ∇f(xk) = 0,

die nur in Ausnahmefällen für endliches k erreicht wird.

3.2 Das Newton-Verfahren

Es sei f ∈ C2(Rn,R). Dann gilt für alle x ∈ Rn und x0 ∈ Rn mit der Taylor-Formel 2.Ordung in Landau-Symbolik

f(x) = f(x0) +∇f(x0)T (x− x0) +1

2(x− x0)T∇2f(x0)(x− x0) + o(‖(x− x0)‖2).

Approximiert man die Funktion f in einer Umgebung von x0 lokal durch ihr Taylor-

Polynom 2. Grades mit der Entwicklungsstelle x0 gemäß

T2(f,x0,x) := f(x0) +∇f(x0)T (x− x0) +

1

2(x− x0)T∇2f(x0)(x− x0),

so lautet nach Satz 2.2 eine notwendige Bedingung für das Vorliegen einer Minimalstelle

von T2(f,x0,x)

∇T2(f,x0,x) = ∇f(x0) +∇2f(x0)(x− x0) = 0.

Ist die Hesse-Matrix ∇2f(x0) invertierbar, so ergibt sich

x = x0 −(∇2f(x0)

)−1∇f(x0).

3.2 Das Newton-Verfahren 91

Sukzessive Anwendung dieser Beziehung liefert, ausgehend von einem Startpunkt x0 ∈Rn, für k ≥ 0 die Iterationsvorschrift des Newton-Verfahrens

xk+1 = xk −(∇2f(xk)

)−1∇f(xk).

In der algorithmischen Umsetzung des Newton-Verfahrens vermeidet man die explizite

Berechnung der inversen Hesse-Matrix. Stattdessen wird in jedem Iterationsschritt zu-

nächst eine Lösung dk ∈ Rn der Newton-Gleichung ∇2f(xk)d = −∇f(xk) bestimmt undanschließend xk+1 = xk+dk gesetzt. Das so bestimmte dk wird als Newton-Richtung von

f im Punkt xk bezeichnet. Somit lässt sich das Newton-Verfahren wie folgt formulieren:

Algorithmus 1 (Newton-Verfahren)

S0 Wähle x0 ∈ Rn, und setze k := 0.

S1 Wenn ∇f(xk) = 0, dann STOPP.

S2 Bestimme eine Lösung dk der Newton-Gleichung ∇2f(xk)d+∇f(xk) = 0.

S3 Setze xk+1 := xk + dk sowie k := k + 1, und gehe zu S1.

Es sei bemerkt, dass man das Newton-Verfahren auch als approximative Nullstellenbe-

stimmung von ∇f durch das Taylor-Polynom 1. Grades von ∇f mit Entwicklungsstellex0 deuten kann. Für den Beweis eines Konvergenzsatzes für das Newton-Verfahren be-

nötigen wir das folgende Lemma.

Lemma 3.6

Es seien f ∈ C2(Rn,R), x∗ ∈ Rn und ∇2f(x∗) invertierbar. Dann existieren ein ε > 0

und eine Konstante C > 0, sodass für alle x ∈ Uε(x∗) die Hesse-Matrix ∇2f(x) ebenfalls

invertierbar ist und außerdem ‖∇2f(x)−1‖ ≤ C gilt.

Beweis: Wegen f ∈ C2(Rn,R) existiert ein ε > 0 mit

‖∇2f(x∗)−∇2f(x)‖ ≤ 1

2

1

‖∇2f(x∗)−1‖

für alle x ∈ Uε(x∗). Somit gilt

‖En −∇2f(x∗)−1∇2f(x)‖ = ‖∇2f(x∗)−1(∇2f(x∗)−∇2f(x))‖≤ ‖∇2f(x∗)−1‖ ‖∇2f(x∗)−∇2f(x)‖≤ 1

2

ebenfalls für alle x ∈ Uε(x∗). Mit Lemma 1.24 (b) folgt die Invertierbarkeit von ∇2f(x)

und

‖∇2f(x)−1‖ ≤ ‖∇2f(x∗)−1‖1− ‖En −∇2f(x∗)−1∇2f(x)‖ ≤ 2‖∇2f(x∗)−1‖

92 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

für alle x ∈ Uε(x∗). Mit C := 2‖∇2f(x∗)−1‖ ist die Aussage bewiesen. �

Bezüglich der Konvergenz des Newton-Verfahrens gilt der folgende Satz.

Satz 3.7

Es seien f ∈ C2(Rn,R), x∗ ∈ Rn ein stationärer Punkt von f und ∇2f(x∗) invertierbar.Dann existiert eine ε-Umgebung Uε(x∗), sodass für jeden Startpunkt x0 ∈ Uε(x∗) dasNewton-Verfahren durchführbar ist und die durch den Algorithmus 1 erzeugte Folge{xk

}k∈N

Q-superlinear gegen x∗ konvergiert. Gilt darüber hinaus, dass ∇2f(x∗) in einerUmgebung von x∗ Lipschitz-stetig ist, dann konvergiert die durch den Algorithmus 1

erzeugte Folge{xk

}k∈N

Q-quadratisch gegen x∗.

Beweis: Wegen f ∈ C2(Rn,R) gilt ‖∇f(y) − ∇f(x) − ∇2f(x)(y − x)‖ = o(‖x − y‖)für beliebige x,y ∈ Rn. Mit der Iterationsvorschrift und ∇f(x∗) = 0 folgt unter der

Voraussetzung der Durchführbarkeit des Newton-Verfahrens für alle k ≥ 0∥∥xk+1 − x∗∥∥ =

∥∥∥xk − (∇2f(xk)

)−1∇f(xk)− x∗∥∥∥

=∥∥xk − x∗ −∇2f(xk)−1

[∇f(xk)−∇f(x∗)

]∥∥=

∥∥∇2f(xk)−1[∇f(x∗)−∇f(xk)−∇2f(xk)

(x∗ − xk

)]∥∥≤

∥∥∇2f(xk)−1∥∥∥∥∇f(x∗)−∇f(xk)−∇2f(xk)

(x∗ − xk

)∥∥=

∥∥∇2f(xk)−1∥∥ o(‖xk − x∗‖) .

Wegen f ∈ C2(Rn,R) und der Invertierbarkeit von ∇2f(x∗) folgt mit Lemma 3.6 dieExistenz eines r1 > 0 und einer Konstanten C > 0, sodass für alle x ∈ Ur1

(x∗) einer-seits die Hesse-Matrix ∇2f(x) invertierbar ist und andererseits ‖∇2f(x)−1‖ ≤ C gilt.

Aufgrund von limh→0

o(‖h‖)‖h‖ = 0 gibt es ein r2 > 0 mit o(‖h‖) ≤ 1

2C ‖h‖ für alle h mit

‖h‖ < r2. Mit ε := min{r1, r2} folgt für alle x0 ∈ Uε(x∗)

‖x1 − x∗‖ ≤ C 1

2C‖x0 − x∗‖ ≤ 1

2ε

und schließlich ‖xk+1 − x∗‖ ≤ 12ε für alle k ≥ 0, womit die Durchführbarkeit des

Newton-Verfahrens und wegen ‖xk+1 − x∗‖ ≤ C o(‖xk − x∗‖) auch die Q-superlineareKonvergenz der Folge {xk}k∈N für alle x0 ∈ Uε(x∗) gezeigt ist. Existiert darüberhin-aus ein r3 > 0, sodass für alle x ∈ Ur3

(x∗) die Hesse-Matrix ∇2f(x) Lipschitz-stetig

mit Lipschitz-Konstante L > 0 ist, dann existiert wegen limk→∞xk = x∗ ein k0 ∈ N mit

xk ∈ Umin{ε,r3}(x∗), und für alle k ≥ k0 sind die Ungleichungen

‖∇f(x∗)−∇f(xk)−∇2f(xk)(xk − x∗)‖ ≤ L2‖x∗ − xk‖2

bzw.

‖xk+1 − x∗‖ ≤ CL2‖x∗ − xk‖2

3.2 Das Newton-Verfahren 93

erfüllt. Damit ist auch die Q-quadratische Konvergenz der Folge {xk}k∈N gezeigt. �

Das Newton-Verfahren konvergiert unter den Voraussetzungen von Satz 3.7 generell lokal

superlinear bzw. lokal quadratisch gegen stationäre Punkte, die natürlich auch Maximal-

stellen sein können. Somit kann im Verlauf des Newton-Verfahrens f(xk+1) < f(xk)

für k = 0, 1, 2, . . . nicht garantiert werden. Weitere Nachteile des Newton-Verfahrens

bestehen einerseits im hohen rechentechnischen Aufwand, da in jedem Iterationsschritt

eine Hesse-Matrix berechnet werden muss, und andererseits in dem Sachverhalt, dass

die zur Bestimmung des (k + 1)-ten Iterationspunktes zu lösende Newton-Gleichung

unlösbar sein kann. Der hohe rechentechnische Aufwand wurde durch die Entwicklung

der AD relativiert, sodass es heute durchaus möglich ist, Optimierungsprobleme ho-

her Dimension effektiv durch Verfahren zu lösen, welche Hesse-Matrizen benutzen. Im

Fall der Nichtlösbarkeit der Newton-Gleichung bietet sich eine „least square“-Lösung

der Newton-Gleichung an, um das Newton-Verfahren fortführen zu können. Im Rahmen

der aufgeführten Konvergenzaussagen ist dieser so ermittelte Iterationspunkt als neuer

Startpunkt des Newton-Verfahrens aufzufassen.

3.2.1 Numerische Experimente zum Newton-Verfahren

Experiment 3.2.1 (Quadratische Konvergenzgeschwindigkeit des Newton-

Verfahrens)

Newton01.m: Wir betrachten die konvexe und beliebig oft stetig partiell differenzier-

bare Funktion (Problem Nr. 13) f : R2 → R mit

f(x) = (x1 − 2)4 + x22(x1 − 2)2 + (x2 + 1)2 ,

globaler Minimalstelle x∗ = (2,−1)T und f(x∗) = 0. Zur Minimierung dieser Funktion

wenden wir das Newton-Verfahren mit Startpunkt x0 = (1, 1)T und Abbruchtoleranz

‖∇f(xk)‖ ≤ 10−6 an. Da eine in einer beschränkten Umgebung von x∗ dreimal stetigdifferenzierbare Funktion dort auch eine Lipschitz-stetige 2. Ableitung besitzt, sind nach

Satz 3.7 in einer (hinreichend kleinen) Umgebung von x∗ alle Voraussetzungen für einequadratische Konvergenz der Iterierten xk bei Anwendung des Newton-Verfahrens erfüllt.

Die Spalten der von EdOptLab erzeugten Tabelle 3.3 geben den Iterationsverlauf des

Newton-Verfahrens wieder. Dabei bezeichnen die Spalte „iter“ die Iterationsnummer,

die Spalte „xiter(1)“ bzw. „xiter(2)“ die 1. bzw. 2. Koordinaten der Iterationspunkte

und die Spalte „fiter“ die zugehörigen Funktionswerte. In der Spalte „fiter“ ist die

quadratische Konvergenz der Funktionswerte des Verfahrens gegen den optimalen Ziel-

funktionswert unmittelbar ersichtlich (Verdopplung der Anzahl der führenden Nullen ab

der 4. Iteration bei jedem weiteren Iterationsschritt). Die Abbildung 3.6 illustriert den

Iterationsverlauf und die Norm der zugehörigen Gradienten. �

94 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

0 1 2 3 4−3

−2

−1

0

1

2

x1

x2

0.126

0.126

0.25

0.25

0.5

0.5

0.5

1

1

11

2

22

22

4

4

44

4

4

4

8

8

8

8

8

8

8

16

16

16

16

16

16

32

32 32

32

0 2 4 6 8

10−10

10−5

100

||gra

d(f)

||

Iterationsindex

Abb. 3.6 Iterationsverlauf des Newton-Verfahrens im Exp. 3.2.1, quadratische Konvergenz

iter xiter (1) xiter (2) fiter

-----------------------------------------------------------------

0 1.0000000000 1.0000000000 6.0000000000 e +000

1 1.0000000000 -0.5000000000 1.5000000000 e +000

2 1.3913043478 -0.6956521739 4.0920737133e -001

3 1.7459441208 -0.9487980942 6.4891623477e -002

4 1.9862783400 -1.0482080866 2.5309302111e -003

5 1.9987342021 -1.0001699932 1.6316892669e -006

6 1.9999995657 -1.0000016017 2.7540453499e -012

7 2.0000000000 -1.0000000000 1.9714253277e -024

-----------------------------------------------------------------

Tab. 3.3 Iterationsverlauf des Newton-Verfahrens im Exp. 3.2.1, quadratische Konvergenz

Experiment 3.2.2 (Lineare Konvergenzgeschwindigkeit des Newton-Verfahrens)

Newton02.m: Wir untersuchen die konvexe und beliebig oft stetig partiell differenzier-

bare Funktion (Problem Nr. 9) f : R2 → R mit

f(x) = (x1 − 2)4 + (x1 − 2x2)2 ,

globaler Minimalstelle x∗ = (2, 1)T und f(x∗) = 0. Das Newton-Verfahren wird mit

Startpunkt x0 = (0, 3)T und Abbruchtoleranz ‖∇f(xk)‖ ≤ 10−6 angewendet. Die Hesse-

Matrix ∇2f(x∗) =

(2 −4−4 8

)mit den Eigenwerten λ1 = 0 und λ2 = 10 ist nicht

regulär, womit die Voraussetzungen des Satzes 3.7 für eine superlineare Konvergenz der

Iterierten verletzt sind. In Tab. 3.4 bezeichnen „nf“, „ng“ und „nh“ die bis zur Ite-

ration „iter“ erfolgte kumulierte Anzahl von Funktionswert-, Gradienten- und Hesse-

Matrixberechnungen. Die Nullen in den Spalten „nd“ (steht für „non descent“) bzw. „LS“

(steht für „least square“) zeigen, dass in jeder Iteration f(xiter+1) ≤ f(xiter) gilt bzw.dass in jeder Iteration die Newton-Gleichung lösbar ist, und damit keine approximative

3.2 Das Newton-Verfahren 95

Lösung mittels „least square“-Ansatz bestimmt wurde. In der Spalte „norm(g)“ ist die eu-

klidische Norm des Gradienten der Zielfunktion im jeweiligen Iterationspunkt aufgeführt.

Abb. 3.7 veranschaulicht den Iterationsverlauf. Man erkennt, dass das Newton-Verfahren

nach einer Iteration näherungsweise einen Punkt auf der Achse zur Eigenrichtung mit dem

Eigenwert λ1 = 0 der Hesse-Matrix ∇2f(x∗) (grau gestrichelte Linie) erreicht und dannlangsam entlang dieser Richtung (2, 1)T gegen den Minimalpunkt mit linearer Konver-

genzgeschwindigkeit bzgl. der Funktionswerte und bzgl. der Norm des Gradienten strebt

(siehe auch Tab. 3.4). �

0 1 2 3 4 5−1

0

1

2

3

4

x1

x2

0.251

0.251

0.5

0.50.5

1

1

1

1

2 22

2

4

4

4

4

4

8

8

8

8

8

8

16

16

16

16

16

16

16

32

32

32

32

32

64

64

64

64

0 5 10 1510−8

10−6

10−4

10−2

100

102

||gra

d(f)

||

Iterationsindex

Abb. 3.7 Iterationsverlauf des Newton-Verfahrens im Exp. 3.2.2, lineare Konvergenz

iter nf ng nh fiter nd LS norm(g)

-----------------------------------------------------------

0 1 1 1 5.200000 e +001 0 0 5.01e +001

1 2 2 2 3.160494 e +000 0 0 9.48e +000

2 3 3 3 6.242951 e -001 0 0 2.81e +000

3 4 4 4 1.233175 e -001 0 0 8.32e -001

4 5 5 5 2.435902 e -002 0 0 2.47e -001

5 6 6 6 4.811659 e -003 0 0 7.31e -002

6 7 7 7 9.504511 e -004 0 0 2.17e -002

7 8 8 8 1.877434 e -004 0 0 6.42e -003

8 9 9 9 3.708512 e -005 0 0 1.90e -003

9 10 10 10 7.325456 e -006 0 0 5.63e -004

10 11 11 11 1.447004 e -006 0 0 1.67e -004

11 12 12 12 2.858279 e -007 0 0 4.94e -005

12 13 13 13 5.645983 e -008 0 0 1.47e -005

13 14 14 14 1.115256 e -008 0 0 4.34e -006

14 15 15 15 2.202975 e -009 0 0 1.29e -006

15 16 16 16 4.351555 e -010 0 0 3.81e -007

-----------------------------------------------------------

Tab. 3.4 Iterationsverlauf des Newton-Verfahrens im Exp. 3.2.2, lineare Konvergenz

96 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Experiment 3.2.3 (Mögliche Divergenz des Newton-Verfahrens)

Newton03.m: Die Funktion (Problem Nr. 21) f : R2 → R mit

f(x) = |x1| − ln(1 + |x1|) + |x2| − ln(1 + |x2|)

ist zweimal Lipschitz-stetig differenzierbar für alle x ∈ R2 und außerdem streng kon-

vex. Nach Satz 3.7 folgt (bei exakter Rechnung) die lokale quadratische Konvergenz des

Newton-Verfahrens gegen die globale Minimalstelle x∗ = (0, 0)T . Insbesondere gilt für

die Koordinaten xi mit i ∈ {1, 2} im Verlauf des Newton-Verfahrens:

• Ist x0i = −1 bzw. x0

i = 1, so folgt xki = (−1)k+1 bzw. xki = (−1)k.• Ist

∣∣x0i

∣∣ < 1, so folgt mit quadratischer Konvergenz limk→∞xki = 0 (oszilierend).

• Ist∣∣x0i

∣∣ > 1, so folgt limk→∞

|xki | =∞ (oszilierend).

Zum Nachweis dieser Aussagen sei auf Aufgabe 3.6 verwiesen. Wir demonstrieren dieses

Verhalten des Newton-Verfahrens für die drei Startpunkte x0 = (1,−1)T (siehe Abb. 3.8),x0 = (1,−0.97)T (siehe Abb. 3.9) und x0 = (1.01,−0.97)T (siehe Abb. 3.10), indem wir

jeweils den Iterationsverlauf von xk1 und xk2 für die ersten acht Iterationen darstellen.

Zusammenfassend stellen wir also fest, dass trotz der strengen Konvexität der Funktion f

das Newton-Verfahren außerhalb einer gewissen Umgebung des Minimalpunktes (hier also

‖x0‖ < 1) divergiert und nur bei Startpunkten innerhalb dieser Umgebung konvergent

ist. �

0 2 4 6 8−1

0

1

xi

Iterationsindex

x1x2

Abb. 3.8 Divergenz des Newton-Verfahrens mit Oszillation xki ∈ {−1, 1} für i = 1, 2 im Exp.3.2.3 bei Startpunkt x0 = (1,−1)T

0 2 4 6 8−1

0

1

xi

Iterationsindex

x1x2

Abb. 3.9 Divergenz des Newton-Verfahrens mit Oszillation xk1 ∈ {−1, 1} und Konvergenz fürxk2 im Exp. 3.2.3 bei Startpunkt x0 = (1,−0.97)T

3.2 Das Newton-Verfahren 97

0 2 4 6 8−4

−2

0

2

xi

Iterationsindex

x1x2

Abb. 3.10 Divergenz des Newton-Verfahrens mit Oszillation limk→∞

|xk1 | = ∞ und Konvergenz

für xk2 im Exp. 3.2.3 bei Startpunkt x0 = (1.01,−0.97)T

Experiment 3.2.4 („Theorie vs. Praxis“)

Newton04.m: Wir betrachten die zweimal stetig differenzierbare Funktion (Problem

Nr. 19) f : R2 → R mit

f(x) = (2x21 + x

22)

2 + (x21 + 2x2

2)54 ,

globaler Minimalstelle x∗ = (0, 0)T und f(x∗) = 0. Die 2. Ableitung im Optimalpunkt x∗

ist nicht Lipschitz-stetig. Nach Satz 3.7 folgt in einer (hinreichend kleinen) Umgebung

von x∗ bei exakter Arithmetik superlineare Konvergenz der Iterierten, und nach den

Ausführungen in Abschnitt 3.1.1 gilt limk→∞ck = 0 für ck :=

‖∇f(xk+1)‖‖∇f(xk)‖ . Die folgenden

Abbildungen zeigen, dass für das Newton-Verfahren mit Startpunkt x0 = (2, 2)T und ge-

wählter Abbruchbedingung ‖∇f(xk)‖ ≤ 10−16 eine superlineare Tendenz nur bis zu einer

Genauigkeit von ‖∇f(xk)‖ ≥ 10−3, d. h. bis zur 8. Iteration (siehe Abb. 3.12), erkennbar

ist. Der Grund liegt in den numerischen Ungenauigkeiten bei der Berechnung der Hesse-

Matrix, die sowohl bei der symbolischen als auch bei der automatischen Differenziation

für x→ 0 einen „ 00“-Term enthält. Als Konsequenz wird nur lineare Konvergenz mit dem

Konvergenzfaktor ck von etwa 0.06 erzielt (siehe Abb. 3.11). Wir sehen, dass selbst die Be-

rechnung der ersten und zweiten partiellen Ableitungen mithilfe der automatischen bzw.

symbolischen Differenziation im Rahmen der 16-stelligen Gleitkommagenauigkeit unter

Matlab nicht ausreicht, um die an sich theoretisch vorhandene superlineare Konvergenz

bis zu einer (moderateren) Abbruchbedingung von ‖∇f(xk)‖ ≤ 10−8 zu bestätigen, wenn

die Formeln für die Ableitungen nicht sachgerecht vereinfacht werden. Die Tatsache, dass

die theoretisch geltende Konvergenzgeschwindigkeit numerisch nicht erreicht wird, tritt

sehr häufig bei praktischen Optimierungsproblemen auf. Deshalb sollten die Abbruch-

schranken nicht zu klein gewählt werden, insbesondere dann, wenn die Ergebnisse nicht

mit hoher Genauigkeit benötigt werden. �

98 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

0 5 8 10 15 20 25 30

0.1

0.2

Iterationsindex

ck

Abb. 3.11 Keine (praktische) superlineare Konvergenz des Newton-Verfahrens im Exp. 3.2.4

100

10−5

10−10xi

x1x2

0 5 10 15 20 25 3010−1510−1010−5100

||gra

d(f)

||

Iterationsindex

Verletzung derAbbruchbed. + 1.e−20

Abb. 3.12 Lineare Konvergenz des Newton-Verfahrens im Exp. 3.2.4

Experiment 3.2.5 (Nichtmonotonie des Newton-Verfahrens)

Newton05.m:Wir betrachten die dreidimensionale Rosenbrock-Funktion (Problem Nr.

50, Dimension n = 3) gemäß (3.3) mit globaler Minimalstelle x∗ = (1, 1, 1)T und f(x∗) =0. Das Newton-Verfahren mit Startpunkt x0 = (−1.2, 1,−1.2)T und Abbruchbedingung‖∇f(xk)‖ ≤ 10−16 liefert f(xk+1) > f(xk) für k = 5 (in Abb. 3.13 nicht erkennbar),

k = 7 und k = 9. Ab k = 9 gilt f(xk+1) ≤ 70f(xk)2 und ‖xk+1 − x∗‖ ≤ 30‖xk − x∗‖2,

d. h. im Rahmen unserer numerischen Genauigkeit liegt sogar quadratische Konvergenz

bezüglich der Funktionswerte und Iterationspunkte vor. �

−5

0

5

xi

x1x2x3

0 5 10 15 20

100

10−4

10−8

f( xk ) −

f min

+1e−

20

Iterationsindex

Abb. 3.13 Nichtmonotonie des Newton-Verfahrens im Exp. 3.2.5

Experiment 3.2.6 (Konvergenz gegen stationäre Punkte)

Newton06.m: Wie bereits erwähnt, konvergiert das Newton-Verfahren nicht nur gegen

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 99

lokale Minimalstellen, sondern auch gegen ggf. existierende andere stationäre Punkte.

Wir betrachten die beliebig oft stetig partiell differenzierbare Funktion (Problem Nr. 6)

f : R2 → R mit

f(x) = (x21 + x2 − 11)2 + (x1 + x

22 − 7)2 .

Diese Funktion besitzt vier lokale Minimalstellen, eine lokale Maximalstelle und vier

Sattelpunkte. In Abhängigkeit vom Startpunkt x0 konvergiert das Newton-Verfahren

gegen jeden dieser neun stationären Punkte (siehe Abb. 3.14). �

−5 0 5−8

−6

−4

−2

0

2

4

6

8

x1

x2

8

8

8

8

16

16

16

16

32

32

32

32

32

50

5050

50

50

50

50

180

180

180

180

180180

180

180

150

150

150

150

150

150

150

110

110110

110

110

110

110

110

512

512 512

512

512

512

512

512

1024

10241024

1024

1024

10241024

1024

2048

20482048 2048

2048

2048

20482048

2048

2048

Abb. 3.14 Konvergenz des Newton-Verfahrens gegen stationäre Punkte im Exp. 3.2.6

3.3 Ein allgemeines Abstiegsverfahren mitRichtungssuche

Wie bereits aufgeführt kann im Verlauf des Newton-Verfahrens auch für konvexe Funk-

tionen f(xk+1) < f(xk) nicht garantiert werden. Verfahren, die diese Eigenschaft ge-

währleisten, werden als Abstiegsverfahren bezeichnet, und basieren bei den zunächst be-

trachteten Verfahren auf dem folgenden Begriff:

Definition 3.8

Es seien f : Rn → R und x ∈ Rn. Ein Vektor d ∈ Rn heißt Abstiegsrichtung von f in x,

wenn ein t0 > 0 existiert mit f(x+ td) < f(x) für alle t ∈ (0, t0].

Ein allgemeines Abstiegsverfahren mit Richtungssuche kann wie folgt formuliert werden:

100 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Algorithmus 2 (Prinzipalgorithmus für ein allgemeines Abstiegsverfahren)

S0 Wähle x0 ∈ Rn, und setze k := 0.

S1 Wenn ∇f(xk) = 0, dann STOPP.

S2 Ermittle eine Abstiegsrichtung dk von f im Punkt xk.

S3 Ermittle eine Schrittweite tk > 0 mit f(xk + tkdk) < f(xk).

S4 Setze xk+1 := xk + tkdk sowie k := k + 1, und gehe zu S1.

Es seien f ∈ C1(Rn,R), x ∈ Rn, d ∈ Rn und die Funktion h : R → R definiert durch

h(t) := f(x + td). Dann gilt h′(0) = ∇f(x)Td und somit die folgende hinreichende

Bedingung für das Vorliegen einer Abstiegsrichtung in einem Punkt x.

Lemma 3.9

Es seien f ∈ C1(Rn,R), x ∈ Rn und d ∈ Rn. Gilt ∇f(x)Td < 0, dann ist d eine

Abstiegsrichtung von f in x.

Es seien nun f ∈ C1(Rn,R) und x ∈ Rn ein striktes lokales Maximum von f . Natürlich

sind dann alle Richtungen d ∈ Rn \ {0} Abstiegsrichtungen von f in x, aber es gilt

∇f(x)Td = 0. Somit ist die in Lemma 3.9 formulierte Bedingung nicht notwendig für

das Vorliegen einer Abstiegsrichtung. Gilt f ∈ C1(Rn,R) und ist x ∈ Rn kein stationärerPunkt von f , so ist −∇f(x) eine Abstiegsrichtung von f in x. Allgemeiner gilt:

Lemma 3.10

Es seien f ∈ C1(Rn,R), x ∈ Rn kein stationärer Punkt von f und B ∈ SPDn. Dann istd = −B∇f(x) eine Abstiegsrichtung von f in x.

Da weiterhin mit ∇2f(x) ∈ SPDn auch(∇2f(x)

)−1 ∈ SPDn gilt, ergibt sich:

Folgerung 3.11

Es seien f ∈ C2(Rn,R), x kein stationärer Punkt von f und ∇2f(x) ∈ SPDn, dann ist

die Newton-Richtung d = −(∇2f(x)

)−1∇f(x) von f in x eine Abstiegsrichtung von fin x.

Somit stellt zwar unter den Voraussetzungen der Folgerung 3.11 die gewählte Richtung

d in jedem Schritt des Newton-Verfahrens eine Abstiegsrichtung dar, aufgrund der kon-

stanten Schrittweite tk = 1 für alle k = 0, 1, 2, . . . kann aber f(xk+1) > f(xk), wie

bereits erwähnt, für das Newton-Verfahren nicht ausgeschlossen werden (siehe Experi-

ment 3.2.3).

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 101

Beispiel 3.12

Wir betrachten die Funktion f : R → R mit f(x) = (x− 4)2, strikter globaler Minimal-stelle x∗ = 4 und f(x∗) = 0. Wählt man nun x0 = 0 und berechnet für k = 0, 1, 2, . . . die

weiteren Iterationspunkte mittels xk+1 = xk +(

12

)k= x0 +

k∑i=0

(12

)i=k∑i=0

(12

)i, so gilt

f(xk+1) < f(xk) für alle k, limk→∞xk = 2 und lim

k→∞f(xk) = f(2) = 4. Die Iterationspunkte

bewegen sich zwar in jedem Iterationsschritt auf die globale Minimalstelle x∗ zu, jedochwerden im Verlauf des Verfahrens die gewählten Schrittweiten zu klein und das Verfahren

konvergiert nicht gegen x∗. �

Es seien f : Rn → R, x ∈ Rn und d ∈ Rn eine Abstiegsrichtung von f in x. Einenaheliegende Wahl für die Schrittweite in Richtung d wäre (im Falle der Existenz) die

erste lokale Minimalstelle tperf der Funktion h : [0,∞)→ R mit h(t) := f(x+ td). Diese

Schrittweite wird als perfekte Schrittweite im Punkt x in Richtung d bezeichnet. Im

Allgemeinen lassen sich perfekte Schrittweiten natürlich nur näherungsweise bestimmen.

Das folgende Beispiel zeigt aber, dass im Prinzipalgorithmus 2 die Wahl einer beliebigen

Abstiegsrichtung dk mit der zugehörigen perfekten Schrittweite im Iterationspunkt xk

nicht ausreicht, um die Konvergenz der Folge {xk}k∈N gegen eine Minimalstelle von f zu

garantieren.

Beispiel 3.13

Wir betrachten die streng konvexe Funktion f : R2 → R mit f(x) = ‖x‖2, strikter

globaler Minimalstelle x∗ = (0, 0)T und f(x∗) = 0. Für ≥ 0 sind die Höhenlinien der

Zielfunktion f(x) = 2 (konzentrische) Kreise mit Mittelpunkt x∗ und Radius . Wir

werden im Folgenden ein Abstiegsverfahren basierend auf dem Prinzipalgorithmus 2 defi-

nieren. Dazu betrachten wir eine streng monoton fallende Folge von Radien {ρk}k∈Nmit

ρk > 0 für alle k. Der Iterationspunkt xk liege für alle k auf dem Kreis mit dem Mittel-

punkt x∗ und Radius ρk und sei für k ≥ 1 als der Berührpunkt der Tangente durch xk−1

an diesen Kreis definiert. Um die Eindeutigkeit dieser Wahl in jedem Iterationsschritt zu

gewährleisten, vereinbaren wir, dass die Iterationspunkte xk den Punkt x∗ im mathema-

tisch positiven Sinn umlaufen. Als Startpunkt des Verfahrens wählen wir x0 = (2, 0)T

und somit ρ0 = 2. Offensichtlich haben wir dadurch ein Abstiegsverfahren mit perfekter

Schrittweite und Abstiegsrichtungen dk = xk+1−xk definiert, welches genau dann gegenx∗ konvergiert, wenn lim

k→∞ρk = 0 gilt. Wir wollen das Verhalten des Verfahrens für den

Fall limk→∞ρk = ρ > 0 noch etwas genauer analysieren. Für k ≥ 1 seien die Winkel βk und

γk definiert durch βk := �(x∗,xk−1,xk

)und γk := �

(xk−1,x∗,xk

). Mit diesen Verein-

barungen lassen sich die Iterationspunkte für k ≥ 1 mittels Polarkoordinaten darstellen

durch

xk = ρk

(cos (ϕk)

sin (ϕk)

)mit ϕk =

k∑j=1

γj .

102 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Im Fall der Nichtkonvergenz des Verfahrens gegen x∗ können prinzipiell zwei Iterati-

onsverläufe auftreten. Wählen wir zunächst ρk = 1 + 2−k für alle k ≥ 0, dann gilt

limk→∞ϕk =

∞∑j=1

γj <∞ (siehe Aufgabe 3.8 (a)), d. h. die Folge {xk}k∈N konvergiert gegen

einen Punkt auf dem Kreis mit dem Radius 1 (siehe Abb. 3.15 (links)). Wählen wir hin-

gegen ρk = 1 + 1√k+1

für alle k ≥ 0, dann gilt limk→∞ϕk =

∞∑j=1

γj =∞ (siehe Aufgabe 3.8

(b)), d. h. die Folge {xk}k∈N konvergiert nicht (siehe Abb. 3.15 (rechts)). Abschließend

möchten wir bemerken, dass in den beiden letzten Beispielen offensichtlich limk→∞βk = π

2

gilt. Mit anderen Worten, der Winkel zwischen dem negativen Gradienten −∇f(xk) undder Abstiegsrichtung dk konvergiert gegen π2 . �

Zur Sicherung der Konvergenz des Prinzipalgorithmus 2 gegen eine Minimalstelle müssen

somit neben Voraussetzungen an die Funktion f sowohl Bedingungen an die Wahl der

Abstiegsrichtungen dk als auch Bedingungen an die Schrittweiten tk gestellt werden.

−2 −1 0 1 2

−2

−1

0

1

2

x1

x2o

x1

x*

x3

γ1

γ3 γ2

β3

β2

x2

f = 9/4f = 25/16f = 1

f = 4

x0

Iterationsweg

β1

Grenzpunkt

−2 −1 0 1 2

−2

−1

0

1

2

x1

x2

GrenzlinieIterationsweg

x0

x2

x*

f = 9/16f = 2.914...

f = 2.488...f = 4

f = 1x200

γ1

γ2γ3

β3 x1x3

β2

β1

Abb. 3.15 Konvergenz des Abstiegsverfahrens gegen einen nicht-optimalen Grenzpunkt bzw.gegen eine Grenzlinie in Beispiel 3.13

3.3.1 Das Verfahren des steilsten Abstiegs

Es seien f ∈ C1(Rn,R) und x ∈ Rn. Gilt ∇f(x) �= 0, dann wird die Richtung −∇f(x)als Richtung des steilsten Abstiegs von f im Punkt x bezeichnet, da für d := − ∇f(x)

‖∇f(x)‖

∇f(x)T d = min{∇f(x)Td | ‖d‖ = 1}

gilt. Wählt man im Prinzipalgorithmus 2 für die Abstiegsrichtung die Richtung des steils-

ten Abstiegs, so erhält man ein sogenanntes Verfahren des steilsten Abstiegs.

Bei der Untersuchung der Konvergenzgeschwindigkeit für Verfahren des steilsten Abstiegs

beschränken wir uns zunächst auf eine Variante mit perfekter Schrittweite, angewandt

auf eine streng konvexe quadratische Zielfunktion.

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 103

Lemma 3.14

Es seien f : Rn → R mit f(x) = 12xTQx+ bTx+ a, Q ∈ SPDn, b ∈ Rn und a ∈ R sowie

d ∈ Rn eine Abstiegsrichtung von f in x ∈ Rn. Dann gilt für die eindeutig bestimmteperfekte Schrittweite tperf im Punkt x in Richtung d

tperf = −(Qx+ b)Td

dTQd. (3.5)

Beweis: Die Funktion h : [0,∞) → R sei definiert durch h(t) = f(x + td). Somit gilt

h′(t) = ∇f(x + td)Td und h′′(t) = dT∇2f(x + td)d = dTQd > 0. Für die perfekte

Schrittweite folgt

0 = h′(t) = ∇f(x+ tperfd)Td = (Q(x+ tperfd) + b)

Td = (Qx+ b)T d+ tperfd

TQd

und damit die Aussage. �

Bezüglich der Konvergenzgeschwindigkeit gilt für das Verfahren des steilsten Abstiegs

mit perfekter Schrittweite und streng konvexer quadratischer Zielfunktion der folgende

Satz.

Satz 3.15

Es sei f : Rn → R mit f(x) = 12xTQx + bTx + a, Q ∈ SPDn, b ∈ Rn, a ∈ R sowie

eindeutiger globaler Minimalstelle x∗ = −Q−1b. Weiter sei {xk}k∈N eine gemäß

xk+1 := xk + tkdk

mit perfekter Schrittweite tk := tperf > 0 im Punkt xk in Richtung dk, dk := −∇f(xk)und ∇f(xk) �= 0 für alle k ∈ N erzeugte Folge. Dann gilt

f(xk+1)− f(x∗) ≤(λmax(Q)− λmin(Q)

λmax(Q) + λmin(Q)

)2 (f(xk)− f(x∗)

).

Beweis: Wir betrachten die Funktion f : Rn → R mit f(x) = 12 (x− x∗)

TQ (x− x∗).

Dann gilt

f(x) = 12xTQx+ bTx+ a

= 12 (x− x∗)

TQ (x− x∗) + (x∗)T Qx− 1

2 (x∗)T Qx∗ + (−Qx∗)T x+ a

= f(x)− 12(x∗)T Qx∗ + a

= f(x) + f(x∗) .

Somit unterscheiden sich die beiden Funktionen f und f nur durch die additive Kon-

stante f(x∗), und es kann o. B. d. A. b = 0, a = 0 und f(x∗) = 0 angenommen werden.

104 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Weiterhin seien λ1 ≤ · · · ≤ λn die Eigenwerte von Q und v1, · · · ,vn die zugeordneten or-thonormierten Eigenvektoren. Da diese Eigenvektoren eine Basis des Rn bilden, lässt sich

jeder Iterationspunkt mittels xk =n∑i=1

αki vi mit αki ∈ R für alle i = 1, · · · , n darstellen.

Mit Qvi = λivi folgt

f(xk) =1

2(xk)TQxk =

1

2

n∑i=1

(αki )2λi

und nach kurzer Rechnung

f(xk − tQxk) = 1

2

n∑i=1

(αki )2λi(1− tλi)2

für alle t > 0. Mit tperf in xk ergibt sich für die konstante Schrittweite t = 2λn+λ1

f(xk − tperfQxk) ≤ f(xk − tQxk) = 1

2

n∑i=1

(αki )2λi

(λn + λ1 − 2λiλn + λ1

)2

.

Mit maxi=1,··· ,n

(λn+λ1−2λiλn+λ1

)2

=(λn−λ1

λn+λ1

)2

folgt

f(xk+1)− f(x∗) = f(xk − tperfQxk)− f(x∗)

≤ 12

n∑i=1

(αki )2λi

(λn+λ1−2λiλn+λ1

)2

− f(x∗)

≤(λn−λ1

λn+λ1

)2(

12

n∑i=1

(αki )2λi − f(x∗)

)und somit f(xk+1)− f(x∗) ≤

(λmax(Q)−λmin(Q)λmax(Q)+λmin(Q)

)2 (f(xk)− f(x∗)

). �

Wie das Beispiel aus Aufgabe 3.11 zeigt, ist die Abschätzung aus Satz 3.15 bestmöglich.

Mit der spektralen Konditionszahl κ := κ(Q) = λmax(Q)λmin(Q) (für die positiv definite Matrix

Q) lässt sich diese Abschätzung auch wie folgt formulieren:

f(xk+1)− f(x∗) ≤(κ− 1κ+ 1

)2 (f(xk)− f(x∗)

).

Somit gilt unter den Voraussetzungen des Satzes 3.15 Q-lineare Konvergenz für die Folge

der Funktionswerte {f(xk)}k∈N. Für die Folge der Iterierten {xk}k∈N folgt hieraus mit

Satz 3.3 aber nur die R-lineare Konvergenz (siehe auch Aufgabe 3.10). Die Konvergenz

des Verfahrens des steilsten Abstiegs mit perfekter Schrittweite bei streng konvexer qua-

dratischer Zielfunktion f(x) = 12xTQx+ bTx+ a ist also umso langsamer, je größer die

spektrale Konditionszahl der Matrix Q ist. Für κ = 1000 ergibt sich beispielsweise als

Konvergenzfaktor(κ−1κ+1

)2 ≈ 0.996.

Die Aussage des Satzes 3.15 lässt sich lokal auf den Fall nichtquadratischer Funktionen

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 105

f ∈ C2,L(Rn,R) übertragen (siehe Spellucci (1993), Satz 3.1.9). Dabei sind λmax(Q)

bzw. λmin(Q) durch obere bzw. untere Schranken des größten bzw. kleinsten Eigenwertes

der symmetrisch positiv definiten Hesse-Matrizen ∇2f(x) für alle x aus einer gewissen

Kugel um das lokale Minimum x∗ zu ersetzen und eine asymptotisch perfekte Schritt-weitenfolge (siehe Abschnitt 3.4.1) zu wählen.

Es sei erwähnt, dass beim Verfahren des steilsten Abstiegs mit perfekter Schrittweite

∇f(xk)T∇f(xk+1) = 0 für zwei aufeinanderfolgende Iterationspunkte xk und xk+1 gilt

(siehe Aufgabe 3.7) und damit die Abstiegsrichtungen paarweise zueinander orthogonal

sind.

Wir wollen im Folgenden hinreichende Bedingungen zur Sicherung der Konvergenz von

Abstiegsverfahren auch für den Fall betrachten, dass die in einem Iterationspunkt ge-

wählte Abstiegsrichtung bzw. Schrittweite nicht notwendig die Richtung des steilsten

Abstiegs bzw. die perfekte Schrittweite ist. Dabei stehen die folgenden zwei Fragen im

Mittelpunkt unserer Betrachtungen:

• Welche Forderungen sind an die Abstiegsrichtungen zur Sicherung der Konvergenz

von Abstiegsverfahren zu stellen?

• Wie kann die perfekte Schrittweite durch andere Schrittweitenstrategien ersetzt wer-

den, die auch für nichtquadratische Zielfunktionen mit geringem Aufwand implemen-

tierbar und durchführbar sind?

3.3.2 Zur Konvergenz allgemeiner Abstiegsverfahren

Wir betrachten die in Lemma 3.9 formulierte hinreichende Bedingung ∇f(x)Td < 0 fürdas Vorliegen einer Abstiegsrichtung d von f in x. Geometrisch bedeutet dies, dass der

Winkel zwischen der Abstiegsrichtung d und der negativen Gradientenrichtung ∇f(x)kleiner als π

2ist. Um Konvergenz von Abstiegsverfahren zu garantieren, erscheint es daher

naheliegend (siehe auch die abschließende Bemerkung im Beispiel 3.13), diese Winkel-

bedingung für alle Iterationen xk und alle gewählten Abstiegsrichtungen dk zu fordern.

Definition 3.16 ((Streng) gradientenähnliche Richtungen)

Es seien f ∈ C1(Rn,R) und {xk}k∈N ⊂ Rn mit ∇f(xk) �= 0 für alle k ∈ N.

• Eine Folge {dk}k∈N ⊂ Rn heißt gradientenähnlich und ihre Elemente heißen gra-

dientenähnliche Richtungen bezüglich f und {xk}k∈N, wenn eine von xk und dk

unabhängige Konstante μ > 0 existiert mit − ∇f(xk)Tdk

‖∇f(xk)‖‖dk‖≥ μ für alle xk und dk.

• Eine Folge {dk}k∈N ⊂ Rn heißt streng gradientenähnlich und ihre Elemente heißen

streng gradientenähnliche Richtungen bezüglich f und {xk}k∈N, wenn von xk und

106 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

dk unabhängige Konstanten μ1, μ2 > 0 existieren mit μ1‖∇f(xk)‖2 ≤ −∇f(xk)Tdk

sowie ‖dk‖ ≤ μ2‖∇f(xk)‖ für alle xk und dk.

Offensichtlich ist jede streng gradientenähnliche Folge auch gradientenähnlich. Die Menge{d ∈ Rn

∣∣ −∇f(x)Td ≥ μ‖∇f(x)‖‖d‖}bildet für festes x ∈ Rn mit ∇f(x) �= 0 und μ > 0 einen abgeschlossenen konvexen Kegel

(siehe Aufgabe 3.15), den wir als Abstiegskegel von f bzgl. x und μ bezeichnen werden.

Es seien f ∈ C1(Rn,R), xk ∈ Rn der aktuelle Iterationspunkt eines auf den Prinzipalgo-rithmus 2 basierenden Abstiegsverfahrens und dk die in xk gewählte Abstiegsrichtung

mit ∇f(xk)Tdk < 0. Wie bereits erwähnt, lässt sich i. Allg. die zugehörige perfekte

Schrittweite tperf nur näherungsweise bestimmen. Daher ist es unser Ziel, Schrittweiten

tk > 0 zu bestimmen, sodass f(xk + tkdk) gegenüber f(xk) einen für die Konvergenz

des Verfahrens hinreichenden Abstieg garantiert. Das folgende Lemma liefert für gewisse

t > 0 eine Abschätzung der Differenz f(x+ td)− f(x) nach oben.

Lemma 3.17Es seien f ∈ C1(Rn,R), x ∈ Rn, Nf (f(x)) kompakt, ∇f auf Nf (f(x)) Lipschitz-stetigmit Lipschitz-Konstante L > 0, d ∈ Rn mit ∇f(x)Td < 0. Ferner sei t = t(x,d) die

erste Nullstelle der Hilfsfunktion ϕ : [0,∞)→ R mit ϕ(t) := f(x+ td)− f(x). Dann gilt

f(x+ td) ≤ f(x) + t∇f(x)Td+ t2L2‖d‖2

für alle t ∈[0, t

]mit −2∇f(x)

Td

L ‖d‖2 ≤ t.

Beweis: Wir folgen Werner (1992). Für die Hilfsfunktion ϕ gilt ϕ(0) = 0, ϕ′(t) =∇f(x+ td)Td, ϕ′(0) < 0 und somit ϕ(t) < 0 für alle hinreichend kleinen t > 0. Wegen

der Kompaktheit von Nf (f(x)) kann ϕ(t) < 0 nicht für alle t ∈ (0,∞) gelten, womitdie Existenz der ersten Nullstelle t > 0 von ϕ gezeigt ist, und es gilt x+ td ∈ Nf (f(x))für alle t ∈

[0, t

]. Somit folgt mit der Cauchy-Schwarzschen-Ungleichung und wegen der

Lipschitz-Stetigkeit von ∇f auf Nf (f(x))

f(x+ td) = f(x) + t∇f(x)Td+t∫s=0

(∇f(x+ sd)−∇f(x))T d ds

≤ f(x) + t∇f(x)Td+t∫s=0

‖∇f(x+ sd)−∇f(x)‖ ‖d‖ ds

≤ f(x) + t∇f(x)Td+t∫s=0

Ls‖d‖2 ds

= f(x) + t∇f(x)Td+ t2 L2‖d‖2

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 107

und damit −t∇f(x)Td−t2 L2 ‖d‖2 ≤ f(x)−f(x+td) für alle t ∈

[0, t

]. Für t = t > 0 folgt

aus der letzten Ungleichung −t∇f(x)Td− t2 L2 ‖d‖2 ≤ 0 und somit −2∇f(x)

Td

L ‖d‖2≤ t. �

Der folgende Satz liefert eine Abschätzung von f(x + td) − f(x) nach oben, wenn t

gleich der (i. Allg. unbekannten) perfekten Schrittweiten tperf gesetzt wird.

Satz 3.18

Es seien f ∈ C1(Rn,R), x ∈ Rn, Nf (f(x)) kompakt, ∇f auf Nf (f(x)) Lipschitz-stetigmit Lipschitz-Konstante L > 0, d ∈ Rn mit ∇f(x)Td < 0. Ferner sei t∗ die ersteNullstelle von h′ mit h : [0,∞)→ R und h(t) = f(x+ td). Dann gilt

−∇f(x)Td

L ‖d‖2≤ t∗ und f(x+ t∗d) ≤ f(x)− 1

2L

(∇f(x)Td‖d‖

)2

.

Beweis:Wir folgen erneut Werner (1992). Für die Funktion h gilt h′(t) = ∇f(x+td)Td,h′(0) < 0 und somit h′(t) < 0 für alle hinreichend kleinen t > 0. Wegen der Kompaktheitvon Nf (f(x)) kann h′(t) < 0 nicht für alle t ∈ (0,∞) gelten, womit die Existenz derersten positiven Nullstelle t∗ > 0 von h′ gezeigt ist. Die Hilfsfunktion h ist monotonfallend für alle t ∈ [0, t∗], und es gilt t∗ ≤ t, wobei t wie in Lemma 3.17 definiert ist.Wegen der Lipschitz-Stetigkeit von ∇f auf Nf (f(x)) folgt

0 = ∇f(x+ t∗d)Td = ∇f(x)Td+ (∇f(x+ t∗d)−∇f(x))T d ≤ ∇f(x)Td+ Lt∗ ‖d‖2

bzw.

t := −∇f(x)Td

L ‖d‖2≤ t∗ .

Mit Lemma 3.17 gilt nun abschließend

f(x+ t∗d) ≤ f(x+ td) ≤ f(x) + t∇f(x)Td+ t2L2‖d‖2

= f(x)− ∇f(x)Td

L ‖d‖2∇f(x)Td+

(∇f(x)TdL ‖d‖2

)2L

2‖d‖2

= f(x)− 1

2L

(∇f(x)Td‖d‖

)2

.

�

Die Aussage des Satzes 3.18 ist Motivation für die folgende Definition (siehe auch Kosmol

(1993) sowie Warth und Werner (1977)).

108 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Definition 3.19

Es seien f ∈ C1(Rn,R) und Desc f ⊂ Rn × Rn die Menge aller Paare (x,d) mit

∇f(x)Td < 0.

• Eine Funktion T , die jedem Paar (x,d) ∈ Desc f eine Teilmenge T = T (x,d) des R+

zuordnet, heißt Schrittweitenstrategie.

• Eine Schrittweitenstrategie T heißt wohldefiniert, wenn T (x,d) �= ∅ für alle Paare(x,d) ∈ Desc f gilt.

• Eine wohldefinierte Schrittweitenstrategie T heißt effizient bzgl. f , wenn für alle

(x,d) ∈ Desc f eine von x und d unabhängige Konstante ν > 0 existiert mit

f(x+ td) ≤ f(x)− ν(∇f(x)Td‖d‖

)2

für alle t ∈ T (x,d).• Eine wohldefinierte Schrittweitenstrategie T heißt semi-effizient bzgl. f , wenn für

alle (x,d) ∈ Desc f zwei von x und d unabhängige Konstanten ν1 > 0 und ν2 > 0

existieren mit

f(x+ td) ≤ f(x)−min{ν1

(∇f(x)Td‖d‖

)2

, ν2(−∇f(x)Td

)}

für alle t ∈ T (x,d).

Wir nennen eine Schrittweite t ∈ T (x,d) �= ∅ selbst effizient bzw. semi-effizient, wenn Teffizient bzw. semi-effizient ist.

Offensichtlich ist mit dieser Definition die perfekte Schrittweite (unter den Voraussetzun-

gen des Satzes 3.18) effizient und jede effiziente Schrittweitenstrategie auch semi-effizient.

Das folgende Lemma zeigt, dass die Kombination von gradientenähnlichen Abstiegsrich-

tungen und effizienten Schrittweiten bzw. von streng gradientenähnlichen Abstiegsrich-

tungen und semi-effizienten Schrittweiten für den Prinzipalgorithmus 2 einen gewissen

Mindestabstieg in jedem Iterationsschritt garantiert.

Lemma 3.20

Es seien f ∈ C1(Rn,R) und {xk}k∈N eine durch den Algorithmus 2 erzeugte Folge.

Wenn entweder die zugehörige Folge der {dk}k∈N gradientenähnlich und die zugehörigen

Schrittweiten tk effizient sind oder die zugehörige Folge der {dk}k∈N streng gradien-

tenähnlich und die zugehörigen Schrittweiten tk semi-effizient sind, dann existiert eine

Konstante γ > 0, sodass für alle k ∈ N die folgende Abstiegsbedingung gilt:

f(xk+1) ≤ f(xk)− γ‖∇f(xk)‖2 . (3.6)

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 109

Beweis: Wir betrachten zunächst den Fall gradientenähnlicher Abstiegsrichtungen und

effizienter Schrittweiten. Aus der Effizienz der Schrittweiten tk folgt die Existenz einer

Konstanten ν > 0 mit

f(xk)− f(xk+1) = f(xk)− f(xk + tkdk) ≥ ν(∇f(xk)Tdk

‖dk‖

)2

für alle k ∈ N. Da weiterhin die Abstiegsrichtungen dk gradientenähnlich für alle k ∈ N

sind, existiert eine Konstante μ > 0 mit −∇f(xk)Tdk

‖dk‖≥ μ‖∇f(xk)‖ für alle xk und

alle dk. Somit folgt f(xk) − f(xk+1) ≥ γ‖∇f(xk)‖2 mit γ := νμ2 > 0 für alle k ∈ N.Im Fall streng gradientenähnlicher Abstiegsrichtungen und semi-effizienter Schrittweiten

folgt aus der Semi-Effizienz der Schrittweiten tk die Existenz zweier Konstanten ν1, ν2 > 0

mit

f(xk)−f(xk+1) = f(xk)−f(xk+tkdk) ≥ min

{ν1

(∇f(xk)Tdk

‖dk‖

)2

, ν2(−∇f(xk)Tdk

)}

für alle k ∈ N. Wegen der strengen Gradientenähnlichkeit der dk für alle k ∈ N existieren

Konstanten μ1, μ2 > 0 mit μ1‖∇f(xk)‖2 ≤ −∇f(xk)Tdk sowie ‖dk‖ ≤ μ2‖∇f(xk)‖ füralle xk und alle dk. Somit folgt

ν1

(∇f(xk)Tdk

‖dk‖

)2

≥ ν1

(μ1‖∇f(xk)‖2

μ2‖∇f(xk)‖

)2

= ν1

(μ1

μ2

)2

‖∇f(xk)‖2 ,

ν2(−∇f(xk)Tdk

)≥ ν2μ1‖∇f(xk)‖2

und schließlich f(xk) − f(xk+1) ≥ γ‖∇f(xk)‖2 mit γ := min

{ν1

(μ1

μ2

)2

, ν2μ1

}> 0

für alle k ∈ N. �

Das folgende Lemma wird für den Beweis des Konvergenzsatzes 3.22 benötigt.

Lemma 3.21

Es seien f ∈ C1(Rn,R), {xk}k∈N eine durch den Algorithmus 2 erzeugte Folge, und es

gelte die Abstiegsbedingung (3.6) für alle k ∈ N, dann ist jeder Häufungspunkt der Folge{xk}k∈N ein stationärer Punkt.

Beweis: Es konvergiere die Teilfolge {xkl}l∈N gegen x∗. Dann folgt liml→∞f(xkl) = f(x∗).

Wegen der Monotonie der Folge {f(xk)}k∈N ergibt sich limk→∞f(xk) = f(x∗), hieraus

limk→∞

(f(xk)− f(xk+1)

)= 0 sowie mit (3.6) unmittelbar lim

k→∞‖∇f(xk)‖ = 0. �

Es folgt ein erster Konvergenzsatz für Abstiegsverfahren mit Schrittweitenstrategien.

110 3 Lösungsverfahren für Optimierungsprobleme ohne Nebenbedingungen

Satz 3.22 (Ortega und Rheinboldt (1970), Schwetlick (1979))

Es seien f ∈ C2(Rn,R), {xk}k∈N eine durch den Algorithmus 2 erzeugte Folge,Nf (f(x0))

eine konvexe Menge, f eine über Nf (f(x0)) gleichmäßig konvexe Funktion, und es gelte

die Abstiegsbedingung (3.6) für alle k ∈ N, dann konvergieren die Folge {xk}k∈N R-

linear gegen die eindeutig bestimmte globale Minimalstelle x∗ und die Folge {f(xk)}k∈N

Q-linear gegen f(x∗).

Beweis: Aus der gleichmäßigen Konvexität von f über der konvexen Menge Nf (f(x0))

und f ∈ C2(Rn,R) folgt analog der Beweisführung im Beweis von Satz 1.75 (b) die

Kompaktheit von Nf (f(x0)) und dadurch die Existenz der eindeutig bestimmten glo-

balen Minimalstelle x∗ mit ∇f(x∗) = 0. Mit der Monotonie von {f(xk)}k∈N und der

Beschränktheit der Funktion f nach unten durch f(x∗) folgt die Konvergenz der Folge{f(xk)}k∈N und somit lim

k→∞(f(xk)− f(xk+1)

)= 0. Wegen der Kompaktheit der Menge

Nf (f(x0)) enthält die Iterationsfolge {xk}k∈N ⊂ Nf (f(x0)) eine in Nf (f(x0)) konver-

gente Teilfolge und damit einen Häufungspunkt x ∈ Nf (f(x0)). Mit Lemma 3.21 folgt

∇f(x) = 0 und hieraus x = x∗ bzw. limk→∞f(xk) = f(x∗) wegen Satz 2.3. Mit Satz

1.73 (c) gilt dT∇2f(x)d > 0 für alle x ∈ Nf (f(x0)) und alle d ∈ Rn \ {0}. Infolge derKompaktheit von Nf (f(x0)) liegen die Eigenwerte von ∇2f(x) für alle x ∈ Nf (f(x0))

in einem Intervall [λ,Λ] mit 0 < λ ≤ Λ <∞. Also gilt λ‖d‖2 ≤ dT∇2f(x)d ≤ Λ‖d‖2 für

alle x ∈ Nf (f(x0)) und alle d ∈ Rn. Wegen ∇f(x∗) = 0 folgt

λ

2‖xk − x∗‖2 ≤ f(xk)− f(x∗) ≤ Λ

2‖xk − x∗‖2 .

Mit der Cauchy-Schwarzschen-Ungleichung, dem Mittelwertsatz in der Integralform an-

gewendet auf ∇f und aus ∇f(x∗) = 0 folgt∥∥∇f(xk)−∇f(x∗)∥∥∥∥xk − x∗∥∥ ≥(∇f(xk)−∇f(x∗)

)T (xk − x∗

)=

1∫t=0

(xk − x∗

)T ∇2f(x∗ + t

(xk − x∗

))(xk − x∗

)dt

≥1∫t=0

λ∥∥xk − x∗∥∥2

dt

= λ∥∥xk − x∗∥∥2 ≥ 0

bzw.

λ∥∥xk − x∗∥∥ ≤ ∥∥∇f(xk)∥∥ .

Mit diesen Abschätzungen und der Abstiegsbedingung (3.6) ergibt sich

0 < f(xk+1)− f(x∗) = f(xk)− f(x∗) + f(xk+1)− f(xk)≤ f(xk)− f(x∗)− γ‖∇f(xk)‖2 ≤ f(xk)− f(x∗)− γλ2‖xk − x∗‖2

≤ f(xk)− f(x∗)− 2γλ2

Λ(f(xk)− f(x∗)) = (1− 2γλ2

Λ)(f(xk)− f(x∗)).

3.3 Ein allgemeines Abstiegsverfahren mit Richtungssuche 111

Wegen f(xk) − f(x∗) > 0 und 2γλ2

Λ > 0 folgt 1 − 2γλ2

Λ ∈ (0, 1) und somit die Q-lineareKonvergenz der Funktionswerte sowie mit Satz 3.4 (a) auch die R-lineare Konvergenz für

die Iterationspunkte. �