Nichtlineare Optimierung || Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Transcript of Nichtlineare Optimierung || Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

4 Lösungsverfahren fürOptimierungsprobleme mitNebenbedingungen

Übersicht

4.1 Sattelpunkte, Dualität und Sensitivität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 298

4.2 Straffunktionen und Strafverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 306

4.3 Multiplikatorverfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 319

4.4 Verfahren für quadratische Optimierungsprobleme . . . . . . . . . . . . . . . . . . . . . . . 328

4.5 SQP-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 337

4.6 Barrierefunktionen und Innere-Punkt-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . 345

4.7 Numerische Experimente zu Verfahren der restringierten Optimierung . . . . . 349

4.8 Übungsaufgaben zu Kapitel 4 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 368

In diesem Abschnitt werden wichtige Lösungsverfahren für Optimierungsprobleme mit

Nebenbedingungen motiviert und darauf aufbauend Algorithmen mit zugehörigen Kon-

vergenzaussagen angegeben. Abschließend werden die Algorithmen anhand der Imple-

mentationen unter EdOptLab getestet, wobei an ausgewählten Beispielen auf numeri-

sche Effekte eingegangen wird. Ein Vergleich mit den Lösungsalgorithmen der Optimi-

zation Toolbox von Matlab beschließt die numerischen Experimente. Eine ausführliche

Darlegung der Theorie und der Konvergenzeigenschaften der Verfahren analog dem Kapi-

tel 3 würde den Rahmen dieses Buches sprengen. Bezüglich tiefergehender Darstellungen

verweisen wir auf Bertsekas (1999), Geiger und Kanzow (2002), Jarre und Stoer (2004)

sowie Spellucci (1993).

R. Reinhardt et al., Nichtlineare Optimierung, DOI 10.1007/978-3-8274-2949-0_4,

© Springer-Verlag Berlin Heidelberg 2013

298 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

4.1 Sattelpunkte, Dualität und Sensitivität

Um die betrachteten numerischen Verfahren für Probleme mit Nebenbedingungen besser

motivieren zu können, ergänzen wir die Theorie aus Abschnitt 2.2 um einige Aussagen

zu Sattelpunkten, Dualität und Sensitivität für restringierte Probleme.

Lemma 4.1

Es seien F : X × Y × Z → R mit X ⊂ Rn, Y ⊂ Rm und Z ⊂ Rp. Dann gilt

supy∈Y, z∈Z

infx∈XF (x,y, z) ≤ inf

x∈Xsup

y∈Y, z∈ZF (x,y, z) .

Beweis: Offensichtlich gilt

infx∈XF (x, y, z) ≤ F (x, y, z) ≤ sup

y∈Y, z∈ZF (x,y, z)

für alle (x, y, z) ∈ X × Y × Z und somit auch

supy∈Y, z∈Z

infx∈XF (x,y, z) ≤ inf

x∈Xsup

y∈Y, z∈ZF (x,y, z) ,

womit die Aussage des Lemmas bewiesen ist. �

Definition 4.2Es seien F : X × Y × Z → R mit X ⊂ Rn, Y ⊂ Rm und Z ⊂ Rp. Ein Vektor (x, y, z) ∈X × Y × Z heißt Sattelpunkt von F bezüglich X × Y × Z, wenn

F (x,y, z) ≤ F (x, y, z) ≤ F (x, y, z)

für alle (x,y,z) ∈ X × Y × Z gilt.

Ist (x, y, z) ein Sattelpunkt von F bezüglich X × Y × Z, so ist x ein globales Minimumder Funktion Fy,z : X → R mit Fy,z(x) := F (x, y, z) bzw. (y, z) ein globales Maximum

der Funktion Fx : Y × Z → R mit Fx(y,z) := F (x,y,z). Die Aussage des folgenden

Lemmas folgt nun unmittelbar aus Lemma 4.1 und der Definition eines Sattelpunktes.

Lemma 4.3

Es seien F : X × Y ×Z → R mit X ⊂ Rn, Y ⊂ Rm und Z ⊂ Rp. Das Tripel (x, y, z) istgenau dann ein Sattelpunkt von F bezüglich X × Y × Z, wenn

F (x, y, z) = maxy∈Y, z∈Z

minx∈XF (x,y, z) = min

x∈Xmax

y∈Y, z∈ZF (x,y, z)

gilt.

4.1 Sattelpunkte, Dualität und Sensitivität 299

Der folgende Satz zeigt, dass jeder Sattelpunkt der Lagrange-Funktion eines Optimie-

rungsproblems der Form(P≤=

)mit differenzierbaren Problemfunktionen gleichzeitig ein

KKT-Punkt dieses Problems ist.

Satz 4.4

Es seien f ∈ C1(Rn,R), G ∈ C1(Rn,Rm) und H ∈ C1(Rn,Rp). Ist (x, u, v) ein Sat-telpunkt der Lagrange-Funktion des Optimierungsproblems

(P≤=

)bzgl. Rn × Rm+ × Rp,

dann ist (x, u, v) ein KKT-Punkt und x eine globale Lösung von(P≤=

).

Beweis: Ist (x, u, v) ein Sattelpunkt der Lagrange-Funktion eines Optimierungsproblemsder Form

(P≤=

)bzgl. Rn ×Rm+ ×Rp, so ist x ein globales Minimum der Funktion Lu,v :

Rn → R mit Lu,v(x) := f(x) + uTG(x) + vTH(x) und Lu,v ∈ C1(Rn,R). Mit Satz 2.2

folgt

∇Lu,v(x) = ∇xL(x, u, v) = 0 .

Aufgrund der Sattelpunkteigenschaft des Punktes (x, u, v) gilt weiterhin

L(x,u, v) ≤ L(x, u, v) bzw. (u− u)TG(x) + (v − v)TH(x) ≤ 0

für alle (u,v) ∈ Rm+ ×Rp und somit

∇uL(x, u, v) = G(x) ≤ 0 und ∇vL(x, u, v) = H(x) = 0 .

Weiterhin folgt für die spezielle Wahl u = 0 sowie v = v

uTG(x) ≥ 0

und wegen u ∈ Rm+uT∇uL(x, u, v) = uTG(x) = 0 .

Wiederum wegen der Sattelpunkteigenschaft des Punktes (x, u, v) gilt

L(x, u, v) ≤ L(x, u, v) ,

und es folgt

f(x) = f(x) + uTG(x) + vTH(x) ≤ f(x) + uTG(x) + vTH(x) ≤ f(x)

für alle x ∈ M = {x ∈ Rn| G(x) ≤ 0, H(x) = 0}, womit die Aussage des Satzesbewiesen ist. �

Die Umkehrung von Satz 4.4 gilt i. Allg. nicht (siehe Aufgabe 4.2). Für konvexe Op-

timierungsprobleme mit differenzierbaren Problemfunktionen gilt jedoch:

300 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Satz 4.5

Es seien f ∈ C1(Rn,R), G = (g1, · · · , gm)T ∈ C1(Rn,Rm), H = (h1, · · · , hp)T , f konvexüber Rn, gi : Rn → R konvex über Rn für alle i ∈ {1, · · · ,m} und hj : Rn → R affin-linear

für alle j ∈ {1, · · · , p}. Ein Punkt (x, u, v) ist genau dann ein Sattelpunkt der Lagrange-Funktion des konvexen Optimierungsproblems

(P f,≤ konv.= aff.−l.

)bzgl. Rn ×Rm+ ×Rp, wenn

(x, u, v) ein KKT-Punkt von(P f,≤ konv.= aff.−l.

)ist.

Beweis: Mit Satz 4.4 genügt es zu zeigen, dass jeder KKT-Punkt (x, u, v) des kon-

vexen Problems(P f,≤ konv.= aff.−l.

)ein Sattelpunkt der zugehörigen Lagrange-Funktion ist.

Wir betrachten hierfür wiederum die im Beweis von Satz 4.4 definierte Funktion Lu,v.

Aufgrund der Konvexität der Funktionen f und g1, · · · , gm sowie der affinen Lineari-

tät der Funktionen h1, · · · , hp ist die Funktion Lu,v eine konvexe Funktion über Rn. Istnun (x, u, v) ein KKT-Punkt des konvexen Optimierungsproblems, so gilt aufgrund der

KKT-Bedingungen

∇xL(x, u, v) = ∇Lu,v(x) = 0 ,

und mit Satz 2.3 folgt

Lu,v(x) ≤ Lu,v(x) bzw. L(x, u, v) ≤ L(x, u, v)

für alle x ∈ Rn. Weiterhin gilt aufgrund der KKT-Bedingungen

∇uL(x, u, v) = G(x) ≤ 0, u ≥ 0, uT∇uL(x, u, v) = uTG(x) = 0 sowie

∇vL(x, u, v) = H(x) = 0 .

Es ergibt sich für alle (u,v) ∈ Rm+ ×Rp

L(x, u, v) = f(x) + uTG(x) + vTH(x)

= f(x)

≥ f(x) + uTG(x) + vTH(x)

= L(x,u,v)

und zusammengefasst

L(x,u, v) ≤ L(x, u, v) ≤ L(x, u, v)

für alle (x,u, v) ∈ Rn ×Rm+ ×Rp. �

Für die Lagrange-Funktion L eines Optimierungsproblems der Form(P≤=

)mit steti-

gen Problemfunktionen f , G und H sowie zulässigem Bereich M gilt

supu∈Rm+ , v∈Rp

L(x,u, v) = supu∈Rm+ , v∈Rp

(f(x) +G(x)Tu+H(x)Tv

)=

{f(x) , falls x ∈M∞ , sonst

4.1 Sattelpunkte, Dualität und Sensitivität 301

und somit

infx∈Rn

supu∈Rm+ , v∈Rp

L(x,u,v) = infx∈Mf(x) .

Vereinbaren wir weiterhin

dom q :=

{(u, v) ∈ Rm+ ×Rp

∣∣∣∣ infx∈RnL(x,u, v) > −∞

},

dann gilt für die Funktion

q : dom q ⊂ Rm+ ×Rp → R mit q(u, v) := infx∈RnL(x,u, v)

offensichtlich

supu∈Rm+ , v∈Rp

infx∈RnL(x,u, v) = sup

(u,v)∈dom q

q(u, v) .

Die Problemstellungen

(P ) MIN {f(x) | x ∈M } ,(D) MAX {q(u, v) | (u,v) ∈ dom q }

werden zueinander duale Problemstellungen genannt. Dabei wird (P ) als primales Pro-

blem und (D) als duales Problem bezeichnet. Die zugehörigen Zielfunktionen f bzw. q

heißen primale Zielfunktion bzw. duale Zielfunktion. Weiterhin ist dom q eine konvexe

Menge, die duale Zielfunktion q konkav über dom q und somit jede lokale Lösung des

dualen Problems auch eine globale Lösung (siehe Aufgabe 4.3).

Beispiel 4.6

Wir betrachten das primale (lineare) Optimierungsproblem

(P ) MIN{cTx

∣∣ Ax = b, x ≥ 0}

mit A ∈ R(p,n), c,x ∈ Rn sowie b ∈ Rp und zugehöriger Lagrange-Funktion L : Rn ×Rn+ ×Rp → R mit

L(x,u, v) := cTx+ (−x)Tu+ (b−Ax)Tv = bTv +(c− u−ATv

)Tx .

Offensichtlich gilt für die duale Zielfunktion q : Rn+ ×Rp → R mit

q(u,v) := infx∈RnL(x,u,v) =

{−∞ , falls c−ATv �= u ≥ 0

bTv , falls c−ATv = u ≥ 0,

und das duale Problem zu (P ) lautet

(D) MAX{bTv

∣∣ ATv ≤ c} .�

302 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Mit Lemma 4.1 folgt unmittelbar:

Satz 4.7 (Schwache Dualität)

Es seien (P ) ein primales Problem mit Zielfunktion f und zulässigem Bereich M sowie

(D) das zugehörige duale Problem mit dualer Zielfunktion q und dual zulässigem Bereich

dom q. Dann gilt

sup(u,v)∈dom q

q(u,v) ≤ infx∈Mf(x) .

Mit anderen Worten besagt Satz 4.7, dass der duale Zielfunktionswert eines jeden dual

zulässigen Punktes eine untere Schranke für den optimalen Zielfunktionswert des pri-

malen Problems ist. Umgekehrt liefert auch der primale Zielfunktionswert eines jeden

primal zulässigen Punktes eine obere Schranke für den optimalen Zielfunktionswert des

dualen Problems.

Beispiel 4.8

Wir betrachten das primale Optimierungsproblem

(P ) MIN{f(x) = x2

1 + x22

∣∣ g(x1, x2) = 2− x1 ≤ 0}

mit der globalen Lösung x = (2, 0)T und optimalem primalen Zielfunktionswert f(2, 0) =

4. Für die zugehörige Lagrange-Funktion L gilt

infx∈R2L(x, u) = inf

x∈R2

(x2

1 + x22 + u (2− x1)

)= − 1

4u2 + 2u ,

und das duale Problem zu (P ) lautet

(D) MAX

{q(u) = −1

4u2 + 2u

∣∣∣∣ u ∈ R+

}.

Weiterhin ist offensichtlich u = 4 die globale Lösung des dualen Problems mit optimalem

dualen Zielfunktionswert q(4) = 4. �

Im Gegensatz zu linearen Optimierungsproblemen (siehe z. B. Beispiel 4.8) gilt für ein

Paar dualer Probleme i. Allg. jedoch nicht

sup(u,v)∈dom q

q(u,v) = infx∈Mf(x) ,

sondern es können durchaus sogenannte Dualitätslücken mit

sup(u,v)∈dom q

q(u, v) < infx∈Mf(x)

auftreten, womit in diesem Fall auch der Optimalwert des dualen Problems keine scharfe

untere Schranke für den optimalen Zielfunktionswert des primalen Problems darstellt.

4.1 Sattelpunkte, Dualität und Sensitivität 303

Beispiel 4.9

Das primale Optimierungsproblem

(P ) MIN {f(x) | g(x) = −x ≤ 0}

mit

f(x) =

⎧⎪⎪⎪⎪⎨⎪⎪⎪⎪⎩2x+ 4 , falls x < −2−x2 − 2x , falls − 2 ≤ x < 0x2 − 2x , falls 0 ≤ x < 22x− 4 , falls 2 ≤ x

besitzt die globale Lösung x = 1. Für die zugehörige Lagrange-Funktion L gilt

L(x, u) =

⎧⎪⎪⎪⎪⎨⎪⎪⎪⎪⎩(2− u)x+ 4 , falls x < −2−x2 − (2 + u)x , falls − 2 ≤ x < 0x2 − (2 + u)x , falls 0 ≤ x < 2(2− u)x− 4 , falls 2 ≤ x

und

infx∈R

L(x, u)

{−∞ , falls u �= 2

−4 , falls u = 2,

womit zwischen dem optimalen dualen Zielfunktionswert q(2) = −4 und dem optimalen

primalen Zielfunktionswert f(1) = −1 eine (endliche) Dualitätslücke besteht. �

Existieren jedoch ein x ∈ M und ein (u, v) ∈ dom q mit q(u, v) = f(x), so ist offen-

sichtlich x eine globale Lösung des primalen Problems und (u, v) eine globale Lösung

des dualen Problems. Mit Lemma 4.3 folgt weiterhin unmittelbar:

Satz 4.10 (Starke Dualität)

Es seien (P ) ein primales Problem der Form(P≤=

)mit Zielfunktion f und zulässigem

BereichM sowie (D) das duale Problem zu (P ) mit dualer Zielfunktion q und dual zuläs-

sigem Bereich dom q. Das Tripel (x, u, v) ist genau dann ein Sattelpunkt der zugehörigen

Lagrange-Funktion L bezüglich Rn ×Rm+ ×Rp, wenn

L(x, u, v) = max(u,v)∈dom q

q(u, v) = minx∈Mf(x)

gilt.

Für konvexe Optimierungsprobleme mit differenzierbaren Problemfunktionen folgt aus

Satz 4.5 und Satz 4.10:

304 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Satz 4.11 (Starke Dualität bei konvexen Optimierungsproblemen)

Es seien f ∈ C1(Rn,R), G = (g1, · · · , gm)T ∈ C1(Rn,Rm), H = (h1, · · · , hp)T , f konvexüber Rn, gi : Rn → R konvex über Rn für alle i ∈ {1, · · · ,m} und hj : Rn → R affin-

linear für alle j ∈ {1, · · · , p}. Für das konvexe Optimierungsproblem(P f,≤ konv.= aff.−l.

)mit

zulässigem Bereich M sind die folgenden Aussagen äquivalent:

(a) (x, u, v) ist ein KKT-Punkt von(P f,≤ konv.= aff.−l.

).

(b) (x, u, v) ist ein Sattelpunkt der Lagrange-Funktion L von(P f,≤ konv.= aff.−l.

)bzgl. Rn×

Rm+ ×Rp.

(c) Für die Lagrange-Funktion L von(P f,≤ konv.= aff.−l.

)gilt

L(x, u, v) = max(u,v)∈dom q

q(u, v) = minx∈Mf(x) .

Zum Abschluss dieses Abschnittes wollen wir noch einen zweiten Zugang zu den Duali-

tätsaussagen anführen, welcher für numerische Zwecke zwar kaum Bedeutung hat, aber

bei der Entwicklung von Lösungsverfahren für Probleme mit Nebenbedingungen ein wich-

tiges Denkmodell liefert. Wir werden später diesen Zugang in abgewandelter Form im-

mer wieder aufgreifen. Dafür wollen wir für Optimierungsprobleme der Form(P≤

)mit

stetigen Problemfunktionen f und G sowie zulässigem Bereich M �= ∅ die „Empfindlich-keit“ der ggf. existierenden optimalen Lösungen gegenüber Änderungen der Nebenbedin-

gungen betrachten. Die Funktion λ : Λ ⊂ Rm → R mit

λ(b) := infx{f(x) | G(x) ≤ b} und Λ := {b ∈ Rm | ∃x ∈ Rn mit G(x) ≤ b}

heißt Sensitivitätsfunktion des Optimierungsproblems(P≤

). Oft definiert man zusätzlich

λ(b) :=∞ für alle b /∈ Λ, und setzt somit die Sensitivitätsfunktion auf dem gesamten Rm

fort. Die so definierte Sensitivitätsfunktion λ ist monoton fallend, d. h. für alle b1, b2 ∈ Λmit b1 ≤ b2 gilt λ(b1) ≥ λ(b2), jedoch i. Allg. nicht differenzierbar (auch im Falle

differenzierbarer Problemfunktionen). Sind ferner alle Koordinatenfunktionen gi konvex

über Rn, so ist Λ eine konvexe Menge (siehe Aufgabe 4.4) und λ konvex über Λ (siehe

beispielsweise Elster et al. (1977)). Für jedes festes u ∈ Rm+ definieren wir nun

ρ(u) := sup{ρ ∈ R

∣∣ ρ− uTb ≤ λ(b) ∀ b ∈ Λ}und darauf aufbauend für den Fall ρ(u) > −∞ eine affin-lineare Funktion

l : Rm → R mit l(b) := ρ(u)− bTu ,

welche den Graphen der Sensitivitätsfunktion λ „stützt“. Mit

4.1 Sattelpunkte, Dualität und Sensitivität 305

s(x, b) :=

{0 , falls G(x) ≤ b∞ , sonst

und der Definition der dualen Zielfunktion für Problemstellungen der Form(P≤

)folgt

ρ(u) = infb∈Λ

(infx∈Rn

{f(x)| G(x) ≤ b}+ uTb)= infb∈Λ

infx∈Rn

(f(x) + uTb+ s(x, b)

)= inf

x∈Rninfb∈Λ

(f(x) + uTb+ s(x, b)

)= infx∈Rn

(f(x) + inf

b∈Λ

{uT b | G(x) ≤ b

})= inf

x∈Rn

(f(x) +G(x)Tu

)= infx∈RnL(x,u)

und somit infx∈Mf(x) = λ(0) ≥ sup

u∈Rm+

ρ(u) = supu∈Rm+

infx∈RnL(x,u) = sup

u∈dom qq(u), was einen

Zusammenhang zwischen λ und dem schwachen Dualitätssatz herstellt.

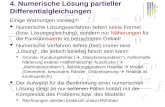

Beispiel 4.12

Wir betrachten erneut das primale Problem (P ) aus Beispiel 4.9 mit zulässigem Bereich

M = {x ∈ R | g(x) = −x ≤ 0}. Für die Sensitivitätsfunktion λ : R → R von (P ) gilt

λ(b) :=

⎧⎪⎪⎪⎪⎨⎪⎪⎪⎪⎩−2b− 4 , falls b < −2b2 + 2b , falls − 2 ≤ b < −1

−1 , falls − 1 ≤ b < 52

−2b+ 4 , falls 52 ≤ b

, ρ(u) =

{−∞ , falls u �= 2

−4 , falls u = 2

und infx∈Mf(x) = λ(0) = −1 > −4 = sup

u∈dom qq(u). �

−8 −6 −4 −2 0 2 4 6 8−8

−6

−4

−2

0

2

4

b

λ

max D = ρ(2)

inf P = λ(0)

Dualitätslücke

Stützpunkt

l

Abb. 4.1 Sensitivitätsfunktion λ und stützende affin-lineare Funktion l für Beispiel 4.12

306 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

4.2 Straffunktionen und Strafverfahren

Die in diesem Abschnitt betrachteten sogenannten Strafverfahren zählen historisch ge-

sehen mit zu den ersten Verfahrensansätzen zur Lösung von restringierten nichtlinearen

Optimierungsproblemen. Hierbei wird im Idealfall das ursprüngliche restringierte Pro-

blem durch die Lösung einer Folge von unrestringierten Problemen ersetzt, wobei die

Zielfunktionen dieser Folge von unrestringierten Problemen eine Verletzung der Neben-

bedingungen bzgl. des zugrundeliegenden restringierten Optimierungsproblems mit ei-

nem wachsenden Folgenparameter immer stärker „bestrafen“. Von zentraler Bedeutung

für die Beschreibung der Strafverfahren ist deshalb der Begriff der Straffunktion, den wir

im Folgenden einführen wollen. Wir betrachten dafür ein Optimierungsproblem der Form(P≤=

)mit zumindest stetigen Problemfunktionen f , G und H sowie zulässigem Bereich

M . Ferner sei Ψ : Rn → R+ eine stetige Funktion mit

Ψ(x) = 0⇔ x ∈M sowie Ψ(x) > 0⇔ x /∈M .

Die (stetige) Funktion S : Rn ×R++ → R mit

S(x, r) := f(x) + rΨ(x) (4.1)

wird als Straffunktion, der Parameter r > 0 als Strafparameter und die Funktion Ψ als

Strafterm für die Problemstellung(P≤=

)bezeichnet. Für nicht zulässige Punkte x wird

zu dem entsprechenden Wert der Zielfunktion also ein positives Vielfaches des Straf-

terms addiert. Wir werden uns bei unseren weiteren Betrachtungen in diesem Abschnitt

zunächst auf eine spezielle Klasse von Straffunktionen, die sogenannten quadratischen

Straffunktionen, beschränken.

Für einen Vektor a ∈ Rm sei der Vektor [a]+ ∈ Rm koordinatenweise definiert durch

[a]+i := max{0, ai} mit i ∈ {1, · · · ,m} .

Die Funktion S : Rn ×R++ → R mit

S(x, r) := f(x) + r(‖ [G(x)]+ ‖2 + ‖H(x)‖2

)wird als quadratische Straffunktion für die Problemstellung

(P≤=

)bezeichnet, und für

jedes (feste) r > 0 lässt sich der ursprünglichen Problemstellung(P≤=

)nun ein unrestrin-

giertes Optimierungsproblem gemäß(SP≤=

)r

MIN{Sr(x) := f(x) + r

(‖ [G(x)]+ ‖2 + ‖H(x)‖2

)∣∣∣ x ∈ Rn}

zuordnen.

4.2 Straffunktionen und Strafverfahren 307

Die den Strafverfahren (mit quadratischer Straffunktion) zugrundeliegende Idee besteht

nun darin, für eine streng monoton wachsende Folge von Strafparametern {rk}k∈Nglobale

(oder auch lokale) Lösungen xk der zugehörigen unrestringierten Optimierungsprobleme(SP≤=

)rkzu bestimmen, natürlich in der Hoffnung, sich damit einer globalen (oder auch

lokalen) Lösung des ursprünglichen restringierten Optimierungsproblems(P≤=

)anzunä-

hern. Ein entsprechender Prinzipalgorithmus kann wie folgt formuliert werden:

Algorithmus 21 (Prinzipalgorithmus Strafverfahren)

S0 Wähle r0 > 0, und setze k := 0.

S1 Bestimme xk ∈ arg minx∈RnS(x, rk) .

S2 Gilt G(xk) ≤ 0 und H(xk) = 0, dann STOPP.

S3 Wähle rk+1 > rk, setze k := k + 1, und gehe zu S1.

Wir setzen also bei der Formulierung von S1 die Existenz globaler Lösungen voraus

und möchten zunächst die (theoretische) Abbruchbedingung in S2 motivieren. Aus der

Definition der Straffunktion S folgt für alle Iterierten xk

f(xk) ≤ S(xk, rk) ≤ infx∈MS(x, rk) = inf

x∈Mf(x) . (4.2)

Gilt nun G(xk) ≤ 0 und H(xk) = 0, so folgt f(xk) ≥ infx∈Mf(x) wegen xk ∈ M bzw.

f(xk) = minx∈Mf(x) wegen (4.2), womit xk eine globale Lösung des ursprünglichen Pro-

blems(P≤=

)ist. Bei den folgenden Betrachtungen beschränken wir uns zunächst auf

Problemstellungen der Form (P=).

Satz 4.13

Es seien f ∈ C0(Rn,R), H ∈ C0(Rn,Rp), M := {x ∈ Rn | H(x) = 0} �= ∅ und

{rk}k∈N⊂ R++ eine streng monoton wachsende Folge mit lim

k→∞rk = ∞. Dann gilt

für jede durch den Prinzipalgorithmus 21 für das Optimierungsproblem (P=) erzeugte

Folge{xk

}k∈N

:

(a) Die Folge{S(xk, rk)

}k∈N

ist monoton wachsend.

(b) Die Folge{‖H(xk)‖

}k∈N

ist monoton fallend.

(c) Die Folge{f(xk)

}k∈N

ist monoton wachsend.

(d) Es gilt limk→∞H(xk) = 0.

(e) Jeder Häufungspunkt der Folge{xk

}k∈N

ist (globale) Lösung von (P=).

308 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Beweis:

Zu (a): Offensichtlich gilt wegen xk ∈ arg minx∈RnS(x, rk) und rk+1 > rk > 0

S(xk, rk) ≤ S(xk+1, rk) ≤ S(xk+1, rk+1)

für alle k ∈ N.Zu (b) und (c): Wiederum wegen xk ∈ arg min

x∈RnS(x, rk) gilt

S(xk, rk) + S(xk+1, rk+1) ≤ S(xk+1, rk) + S(x

k, rk+1)

für alle k ∈ N. Mit der Definition der Funktion S folgt

(rk − rk+1)(‖H(xk)‖2 − ‖H(xk+1)‖2

)≤ 0

und somit wegen rk+1 > rk

‖H(xk)‖2 − ‖H(xk+1)‖2 ≥ 0

für alle k ∈ N. Dies impliziert jedoch unmittelbar

‖H(xk)‖ ≥ ‖H(xk+1)‖

und damit wegen S(xk, rk) ≤ S(xk+1, rk) sowie rk > 0 auch

f(xk+1)− f(xk) ≥ rk(‖H(xk)‖2 − ‖H(xk+1)‖2

)≥ 0

für alle k ∈ N.Zu (d): Wegen M �= ∅ gilt inf

x∈Mf(x) <∞. Mit (c) sowie (4.2) folgt

f(x0) + rk‖H(xk)‖2 ≤ S(xk, rk) <∞

für alle k ∈ N und somit wegen limk→∞rk =∞ unmittelbar lim

k→∞H(xk) = 0.

Zu (e): Es seien x ein Häufungspunkt der Folge{xk

}k∈N

und {xk(l)}l∈N eine gegen x

konvergente Teilfolge. Mit (d) folgt H(x) = 0 und somit x ∈ M . Weiterhin gilt wegen(4.2)

infx∈Mf(x) ≤ f(x) = lim

l→∞f(xk(l)) ≤ lim

l→∞S(xk(l), rk(l)) ≤ inf

x∈Mf(x)

und damit f(x) = minx∈Mf(x). �

Sind für Problemstellungen der Form (P=) die Problemfunktionen f und H stetig dif-

ferenzierbar, dann sind auch die Funktionen Sr für alle r stetig differenzierbar, und es

gilt

∇Sr(x) = ∇f(x) + 2r∇H(x)H(x) .

4.2 Straffunktionen und Strafverfahren 309

Nach Satz 2.2 gilt also für die Iterierten xk des Prinzipalgorithmus 21

0 = ∇f(xk) + 2rk∇H(xk)H(xk) . (4.3)

Ein Vergleich von (4.3) mit den KKT-Bedingungen des ursprünglichen Problems (P=)

zeigt, dass die Werte

vk := 2rkH(xk) (4.4)

als Näherung der Lagrange-Multiplikatoren betrachtet werden können, was wiederum die

Verletzung der KKT-Bedingungen in (xk,vk) und der Zulässigkeit beispielsweise gemäß

‖∇f(x) + 2r∇H(x)H(x)‖∞ < ε und ‖H(x)‖∞ < ε

für ein vorgegebenes ε > 0 als praktisches Abbruchkriterium in S2 des Prinzipalgorith-

mus 21 nahelegt. Zur weiteren Motivation dieser Vorgehensweise dient der folgende Satz:

Satz 4.14

Es seien f ∈ C1(Rn,R), H = (h1, · · · , hp)T ∈ C1(Rn,Rp), {rk}k∈N⊂ R++ eine

streng monoton wachsende Folge mit limk→∞rk = ∞,

{xk

}k∈N

eine durch den Prin-

zipalgorithmus 21 für das zugehörige Optimierungsproblem (P=) erzeugte Folge mit

limk→∞xk = x und die Folge

{vk

}k∈N

⊂ Rp definiert gemäß (4.4). Sind ferner die Gradi-

enten ∇h1(x), · · · ,∇hp(x) linear unabhängig, dann gilt:

(a) Es existiert ein v ∈ Rp mit limk→∞vk = v.

(b) x ist eine (globale) Lösung, und das Paar (x, v) ist ein KKT-Punkt von (P=).

Beweis:

Zu (a): Wegen der linearen Unabhängigkeit der Gradienten ∇h1(x), · · · ,∇hp(x) gilt

rang∇H(x) = rang∇H(x)T = p

und somit wegen limk→∞xk = x und der stetigen Differenzierbarkeit von H

rang∇H(xk) = rang∇H(xk)T = p

für alle hinreichend großen k. Damit sind aber sowohl die Matrix ∇H(x)T∇H(x) alsauch die Matrix ∇H(xk)T∇H(xk) für alle hinreichend großen k invertierbar. Wegen

(4.3) und (4.4) folgt

0 = ∇H(xk)T∇f(xk) +∇H(xk)T∇H(xk)vk

310 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

und daher wegen limk→∞xk = x

limk→∞vk = − lim

k→∞(∇H(xk)T∇H(xk)

)−1∇H(xk)T∇f(xk)

= −(∇H(x)T∇H(x)

)−1∇H(x)T∇f(x)=: v ,

womit die Aussage (a) bewiesen ist.

Zu (b): Wegen H ∈ C1(Rn,Rp), limk→∞rk =∞, lim

k→∞xk = x, (4.4) sowie (a) folgt

H(x) = limk→∞H(xk) = lim

k→∞vk

2rk= 0 ,

weshalb x nach Satz 4.13 (e) eine (globale) Lösung des Optimierungsproblems (P=) ist.

Da weiterhin in x die Regularitätsbedingung (LICQ) erfüllt ist, existiert nach Satz 2.22,

Satz 2.26, Satz 2.28 und Aufgabe 2.12 ein eindeutig bestimmter Lagrange-Multiplikator

v ∈ Rm mit 0 = ∇f(x) +∇H(x)v bzw. 0 = ∇H(x)T∇f(x) +∇H(x)T∇H(x)v. UnterVerwendung der Ausführungen und der Definition von v im Beweis von (a) folgt nun

v = v und somit 0 = ∇f(x) +∇H(x)v, wodurch auch die Aussage (b) gezeigt ist. �

Wir bemerken nochmals, dass wir bei der Formulierung von Satz 4.13 und Satz 4.14

implizit vorausgesetzt haben, dass für alle Strafparameter rk die in Schritt S1 des Prin-

zipalgorithmus 21 betrachteten Funktionen globale Minimalstellen über Rn besitzen (wasi. Allg. nicht der Fall ist) und diese globalen Minimalstellen sogar jeweils exakt bestimmt

werden können. Sind für Problemstellungen der Form(P≤

)die Problemfunktionen f

und G stetig differenzierbar, dann sind die Funktion Sr für alle r ebenfalls stetig diffe-

renzierbar, und es gilt

∇Sr(x) = ∇f(x) + 2r∇G(x) [G(x)]+ . (4.5)

Da weiterhin G(x) ≤ 0 äquivalent zu [G(x)]+ = 0 ist, lassen sich die Aussagen der Sätze

4.13 und 4.14 auf Problemstellungen der Form(P≤

)und damit auch auf die allgemeine

Problemstellung(P≤=

)übertragen, worauf wir jedoch nicht weiter eingehen wollen.

Beispiel 4.15

Wir betrachten das Optimierungsproblem (Problem Nr. 101)

MIN{f(x) = −x2

1 + x22 | 0 ≤ x1 ≤ 1, −1 ≤ x2 ≤ 1

}mit (globaler) Lösung x = (1, 0)T und optimalen Zielfunktionswert f(x) = −1 (sieheAufgabe 2.15) sowie zugehöriger quadratischer Straffunktion

Sr(x) = −x21 + x

22 + r

(([−x1]

+)2+([x1 − 1]+

)2+([−x2 − 1]+

)2+([x2 − 1]+

)2).

4.2 Straffunktionen und Strafverfahren 311

Für alle r > 0 ist zunächst x = (0, 0)T ein Sattelpunkt von Sr. Ist weiterhin für r > 0

der Punkt x(r) eine globale Minimalstelle von Sr über R2, so muss x2(r) = 0 gelten, und

es genügt (für ein festes r > 0) zur Minimierung von Sr die Hilfsfunktion

Sr(x1) := −x21 + r

(([−x1]

+)2+([x1 − 1]+

)2)

=

⎧⎪⎪⎨⎪⎪⎩(r − 1)x2

1 , falls x1 < 0

−x21 , falls 0 ≤ x1 ≤ 1

(r − 1)x21 − 2rx1 + r , falls 1 < x1

zu betrachten. Gilt 0 < r ≤ 1, so besitzt die zugehörige Hilfsfunktion Sr und somit

die entsprechende Straffunktion Sr keine globale Minimalstelle. Für r > 1 ist jedoch

x(r) =(rr−1, 0)T

mit Sr(x(r)) = − rr−1

die globale Minimalstelle der Straffunktion Srüber R2, und es gilt lim

r→∞x(r) = x = (1, 0)T sowie lim

r→∞Sr(x(r)) = f(x) = −1. �

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

(r = 0)

−3

−3

−2.5

−2.5

−2

−2

−2

−1.5

−1.5

−1.5

−1

−1

−1

−1

−0.9

−0.9

−0.9

−0.5

−0.5

−0.5

−0.5

−0.25

−0.25

0

0

0

0

0

0

0

0.250.25

0.250.25

0.5

0.50.5

0.50.5

1

11

1

11

1.51.5

1.51.5

22

220.5

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 0.9

−3

−2.5

−2.5

−2

−2

−2

−1.5

−1.5

−1.5

−1

−1

−1

−1

−0.9

−0.9

−0.9

−0.5

−0.5

−0.5

−0.5

−0.25

−0.25

0

0

0

0

0

0

0.25

0.25

0.250.25

0.5

0.50.5

0.5

0.50.5

1

11

1

11

1.51.5

1.51.5

22

22

0

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 1

−2.5

−2

−2

−1.5

−1.5

−1.5

−1

−1

−1

−1

−0.9

−0.9

−0.9

−0.5

−0.5

−0.5

−0.5

−0.25

−0.25

0

0

0

0

0

0.250.25

0.250.25

0.5

0.50.5

0.5

0.50.5

1

11

1

11

1.51.5

1.51.5

22

22

0

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 5

−1.2

2

−1

−1 −1

−0.9

−0.9

−0.9

−0.5

−0.5

−0.5

−0.5

−0.25

−0.25

0

0

0

0

00

0.25

0.25

0.25

0.25

0.5

0.5

0.5

0.5

0.5

0.50.5

0.5

1

11 1

1

1

11

1

22

2

2

22

2

2

4

4

4

40 1 2

−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 25

−1

−0.9

−0.9

−0.5

−0.5−0

.25

−0.250

0

0

0

0

0.25

0.25

0.25

0.25

0.5

0.5

0.5

0.5

1

11

1

1

1

12

22

2

2

22

2

4

4 44

4

444

4

9

9

9

9

9

16

1616

25

25

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 50

−1−0

.9

−0.5−0

.25

−0.25

0

0

0

00.25

0.25

0.25

0.25

0.5

0.5

0.51

1 1

1

11

1

2

2 2

2

22

24

4

4 4

4

44

49

9

9 9

9

9

99

9

16

16

16

16

16

25

2525

3636

36

49

49

Abb. 4.2 Höhenlinien der Zielfunktion (r = 0) und der zugehörigen quadratischen Straffunktionmit Strafparameter r = 0.9, 1, 5, 25, 50 für Beispiel 4.15

312 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

In Analogie zum vorhergehenden Abschnitt wollen wir für quadratische Straffunktionen

einen zweiten Zugang über die Sensitivitätsfunktion diskutieren. Wir betrachten wieder-

um ein Optimierungsproblem der Form(P≤

)mit zumindest stetigen Problemfunktionen

f und G, zulässigem Bereich M �= ∅ sowie Sensitivitätsfunktion λ. Für jedes feste r > 0definieren wir nun

ρ(r) := sup{ρ ∈ R

∣∣∣ ρ− r ‖b‖2 ≤ λ(b) ∀ b ∈ Λ}

mit der Absicht, den Graphen der Sensitivitätsfunktion λ des Problems(P≤

)durch

quadratische Funktionen

π : Rm → R mit π(b) := ρ(r) − r‖b‖2

zu „stützen“. Analog der Schlussweise im vorhergehenden Abschnitt folgt

ρ(r) = infx∈Rn

(f(x) + r‖ [G(x)]+ ‖2

)= infx∈RnSr(x) .

Vereinbaren wir nun

domΘ :=

{r > 0

∣∣∣∣ infx∈RnSr(x) > −∞

}und

Θ : domΘ→ R mit Θ(r) := infx∈RnSr(x) ,

so können wir durch

MAX {Θ(r) | r ∈ domΘ}

ein anderes „duales“ Problem zu (P ) formulieren, für welches

infx∈Mf(x) = λ(0) ≥ sup

r>0ρ(r) = sup

r>0infx∈RnSr(x) = sup

r∈dom ΘΘ(r) (4.6)

gilt. Offensichtlich ist die Funktion Θ monoton wachsend, und in (4.6) kann Gleichheit

i. Allg. nur für r→∞ erreicht werden.

Beispiel 4.16

Wir betrachten erneut das primale Problem (P ) aus Beispiel 4.8 mit der globalen Lösung

x = (2, 0)T und optimalen primalen Zielfunktionswert f(x) = 4. Für die Sensitivitäts-

funktion λ : R → R von (P ) gilt

λ(b) :=

{(b− 2)2 , falls b < 2

0 , falls b ≥ 2

und somit λ(0) = f(x) = 4. Weiterhin folgt für alle r > 0

ρ(r) = infx∈R2Sr(x) = inf

x∈R2

(x2

1 + x22 + r([2 − x1]

+)2)= S(x(r), r)

4.2 Straffunktionen und Strafverfahren 313

mit

x(r) =

(2r

1 + r, 0

)Tsowie ρ(r) =

4r

1 + r.

Die die Sensitivitätsfunktion λ „stützenden“ quadratischen Funktionen π : R → R haben

daher die Form

π(b) =4r

1 + r− rb2

und berühren („stützen“) den Graphen der Sensitivitätsfunktion λ in den Punkten(2

1 + r,

4r2

(1 + r)2

)T.

Ferner gilt limr→∞x(r) = (2, 0)T sowie sup

r>0ρ(r) = lim

r→∞ρ(r) = 4. �

−2 −1 0 1 2 3 4

−2

0

2

4

6

8

10

b

λπ, r = 100π, r = 10π, r = 5π, r = 1λ(0)ρ(100)ρ(10)ρ(5)ρ(1)

Abb. 4.3 Sensitivitätsfunktion λ und stützende quadratische Funktionen π für Beispiel 4.16

Die bisher betrachteten Strafverfahren (mit quadratischen Straffunktionen) haben (wie

bereits erwähnt) den Nachteil, dass i. Allg. eine (globale) Lösung der unrestringierten

Hilfsprobleme(SP≤=

)rnur für r→∞ auch eine (globale) Lösung des ursprünglichen Pro-

blems(P≤=

)ist und die Hilfsprobleme mit wachsendem Strafparameter r immer schlechter

konditionierte Hesse-Matrizen besitzen. So gilt im Beispiel 4.16

∇2xS≤(x(r), r) =

(2 + 2r 0

0 2

),

d. h. die spektrale Konditionszahl der Hesse-Matrix ∇2xS≤(x(r), r) strebt mit r gegen

unendlich (siehe auch Beispiel 4.15). Es existieren jedoch sogenannte exakte Straffunk-

tionen, die diesen Nachteil für gewisse Problemklassen nicht aufweisen.

314 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Definition 4.17

Es seien x eine lokale Lösung eines Optimierungsproblems der Form(P≤=

)mit stetigen

Problemfunktionen f , G und H sowie S : Rn × R+ → R eine Straffunktion für die

Problemstellung(P≤=

)gemäß (4.1). Die Straffunktion S heißt exakt in x, wenn ein

r > 0 existiert, sodass x für alle r ≥ r auch eine lokale Minimalstelle der Funktion

Sr : Rn → R mit Sr(x) := S(x, r)

über Rn ist.

Beispielsweise ist unter zusätzlichen Voraussetzungen durch die sogenannten lq-

Straffunktionen

Sq : Rn ×R+ → R mit Sq(x, r) := f(x) + r

∥∥∥∥∥([G(x)]+

H(x)

)∥∥∥∥∥q

mit 1 ≤ q ≤ ∞ eine Klasse exakter Straffunktionen gegeben. Der nachfolgende Satz zeigt,

dass wir uns beim Nachweis der Exaktheit der lq-Straffunktionen beispielsweise auf die

l1-Straffunktion

S1 : Rn ×R+ → R mit S1(x, r) := f(x) + r(‖ [G(x)]+ ‖1 + ‖H(x)‖1

)beschränken können.

Satz 4.18

Existiert für ein Optimierungsproblem der Form(P≤=

)mit stetigen Problemfunktionen

f , G und H sowie lokaler Lösung x ein q, sodass die zugehörige lq-Straffunktion S q exakt

in x ist, so sind für alle q mit 1 ≤ q ≤ ∞ die zugehörigen lq-Straffunktionen Sq exakt in

x.

Beweis: Wir vereinbaren zunächst

Ψq(x) :=

∥∥∥∥∥([G(x)]+

H(x)

)∥∥∥∥∥q

und Ψq(x) :=

∥∥∥∥∥([G(x)]+

H(x)

)∥∥∥∥∥q

mit 1 ≤ q, q ≤ ∞. Aufgrund der Normäquivalenz im Rm+p, und da nach Voraussetzung

S q exakt in x ist, existieren ein C ≥ 1, ein r′ > 0 und eine ε-Umgebung Uε(x) mit

Ψq(x) ≤ CΨq(x) und S qr′(x) ≤ Sqr′(x)

für alle x ∈ Uε(x) und alle r′ ≥ r′, woraus unmittelbar

SqCr′(x) = Sqr′(x) = S

qr′(x) ≤ S

qr′(x) = f(x) + r

′Ψq(x) ≤ f(x) + r′CΨq(x) = SqCr′(x)

4.2 Straffunktionen und Strafverfahren 315

für alle x ∈ Uε(x) und alle r′ ≥ r′ folgt. Somit ist x auch eine lokale Minimalstelle vonSqr über Rn für alle r ≥ r := Cr′ und die gewünschte Aussage bewiesen. �

Wir formulieren nun zunächst ein Exaktheitsresultat für die l1-Straffunktion bei kon-

vexen Problemstellungen.

Satz 4.19

Ist (x, u, v) ∈ Rn × Rm × Rp ein KKT-Punkt des konvexen Optimierungsproblems(P f,≤ konv.= aff.−l.

)mit f ∈ C1(Rn,R) und G ∈ C1(Rn,Rm), dann ist x für alle

r > r := max {‖u‖∞, ‖v‖∞}

sowohl eine globale Lösung von(P f,≤ konv.= aff.−l.

)als auch eine strenge globale Minimalstelle

von S1r : Rn → R mit S1

r (x) := f(x) + r(‖ [G(x)]+ ‖1 + ‖H(x)‖1

)über Rn.

Beweis: Ist (x, u, v) ein KKT-Punkt von(P f,≤ konv.= aff.−l.

), so ist x nach Satz 2.24 eine

globale Lösung des konvexen Optimierungsproblems, und es gilt

∇f(x) +∇G(x)u+∇H(x)v = 0, G(x) ≤ 0, u ≥ 0, uTG(x) = 0 sowie H(x) = 0 .

Mit Satz 1.68 (a) und der Definition von r folgt

S1r (x) = f(x) +G(x)T u+H(x)T v

= f(x) +G(x)T u+H(x)T v + (∇f(x) +∇G(x)u+∇H(x)v)T (x− x)= f(x) +∇f(x)T (x− x) +

(G(x) +∇G(x)T (x− x)

)Tu

+(H(x) +∇H(x)T (x− x)

)Tv

≤ f(x) +G(x)T u+H(x)T v

= f(x) +m∑i=1

uigi(x) +p∑j=1

vjhj(x)

≤ f(x) +m∑i=1

ui [gi(x)]+ +

p∑j=1

|vj | |hj(x)|

≤ f(x) +m∑i=1

r [gi(x)]+ +

p∑j=1

r |hj(x)|

= f(x) + r(‖ [G(x)]+ ‖1 + ‖H(x)‖1

)< f(x) + r

(‖ [G(x)]+ ‖1 + ‖H(x)‖1

)= S1

r (x)

für alle x ∈ Rn und alle r > r, womit die Aussage gezeigt ist. �

Für nichtkonvexe Problemstellungen kann die in Satz 4.19 formulierte „globale“ Exakt-

heit der lq-Straffunktionen i. Allg. nicht garantiert werden (siehe Beispiel 4.21). Es gilt

jedoch der folgende Satz, den wir ohne Beweis zitieren.

316 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Satz 4.20 (Bertsekas (1999))

Es sei x eine lokale Lösung des Optimierungsproblems(P≤=

)mit f ∈ C2(Rn,R), G ∈

C2(Rn,Rm), H ∈ C2(Rn,Rp) sowieM := {x ∈ Rn | G(x) ≤ 0, H(x) = 0}. Sind in x dieRegularitätsbedingung (LICQ) und im eindeutig bestimmten zugehörigen KKT-Punkt

(x, u, v) von(P≤=

)das hinreichende Optimalitätskriterium 2. Ordnung nach Satz 2.32

erfüllt, dann ist x für alle

r > r := max {‖u‖∞, ‖v‖∞}

sowohl eine strenge lokale Minimalstelle von f über M als auch eine strenge lokale Mini-

malstelle von S1r : Rn → R mit S1

r (x) := f(x) + r(‖ [G(x)]+ ‖1 + ‖H(x)‖1

).

Beispiel 4.21

Wir betrachten erneut das Optimierungsproblem aus Beispiel 4.15 (Problem Nr. 101)

mit (globaler) Lösung x = (1, 0)T , den eindeutig bestimmten zugehörigen Lagrange-

Multiplikatoren u = (0, 2, 0, 0)T und der l1-Straffunktion

S1(x, r) = −x21 + x

22 + r

([−x1]

+ + [x1 − 1]+ + [−x2 − 1]+ + [x2 − 1]+).

Offensichtlich besitzt für alle r > 0 wegen

limx1→∞

S1r (x1, 0) = lim

x1→∞(−x2

1 + r(x1 − 1))= −∞

die korrespondierende Funktion S1r keine globale Minimalstelle über Rn, und x ist nur

für r > 2 eine lokale Minimalstelle von S1r . �

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 1

−2.5

−2

−2

−1.5

−1.5

−1.5

−1

−1

−1

−1

−0.75

−0.75

−0.5

−0.5

−0.5

−0.5

−0.25

−0.25

−0.25

0

0

0

0

0.25

025

0.25

0.5

0.5

0.5

0.5

0.5

0.5

1

11

1

11

1.51.5

1.51.5

22

22

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 2

−1.75

−1.5

−1.5

−1.25

−1.25

−1

−1

−0.9

−0.9

−0.9

−0.75

−0.75

−0.5

−0.5

−0.5−0.5

−0.25

−0.25

−0.25

00

0

0

00

0.25

0.25

0.25

0.50.5

0.5

0.5

0.5

0.50.5

1

11

1

1

11

1

1.51.5

1.5

1.51.5

1.5

22

2

22

2

33

33

0 1 2−1.5

−1

−0.5

0

0.5

1

1.5

x1

x2

r = 3

−0.9

−0.9

−0.75

−0.75

−0.7

5

−0.75

−0.625

−0.625

−0.5−0.5

−0.5 −0.5

−0.25−0.25

−0.2

5

−0.25−0.25

00

0

0

0 0

0.25

0.25

0.250.25

0.50.5

0.5

0.5

0.5

0.5 0.5

111

1

11 1

1.5

1.51.5 1.5

1.5

1.51.5 1.5

2

22 2

2

22 2

33

33

Abb. 4.4 Höhenlinien der l1-Straffunktion mit Strafparameter r = 1, 2, 3 für Beispiel 4.21

4.2 Straffunktionen und Strafverfahren 317

Wir bemerken, dass für eine beliebige lq-Norm mit 1 ≤ q ≤ ∞ die Aussagen der Sätze

4.19 und 4.20 erhalten bleiben, wenn

r :=

∥∥∥∥∥(u

v

)∥∥∥∥∥q′

= max‖(u,v)‖q=1

∣∣uTu+ vTv∣∣ (induzierte Matrixnorm der Matrix (uT , vT ))

mit 1q+ 1q′= 1 für 1 < q, q′ < ∞ bzw. q′ = 1 für q = ∞ gesetzt wird. Weiterhin lassen

sich auf Grund der Normäquivalenz die Aussagen der Sätze 4.18, 4.19 und 4.20 sogar

auf beliebige Normen im Rm+p übertragen. Der nachfolgende Satz offenbart jedoch den

grundlegenden Nachteil von exakten Straffunktionen.

Satz 4.22

Es seien f ∈ C1(Rn,R), G ∈ C1(Rn,Rm) sowie H ∈ C1(Rn,Rp) und x eine lokale

Lösung des zugehörigen Optimierungsproblems(P≤=

)mit ∇f(x) �= 0. Dann gilt: Ist

S : Rn ×R+ → R mit S(x, r) := f(x) + rΨ(x) eine in x exakte Straffunktion, dann istder Strafterm Ψ in x nicht differenzierbar.

Beweis: Ist S : Rn×R+ → R mit S(x, r) := f(x)+rΨ(x) eine in x exakte Straffunktion,dann existiert per Definition ein r > 0, sodass x für alle r ≥ r eine lokale Minimalstelleder Funktion Sr : Rn → R mit Sr(x) := S(x, r) über Rn ist. Angenommen, der StraftermΨ : Rn → R+ sei differenzierbar in x (und damit auch die Straffunktion S), dann giltnach Satz 2.2

0 = ∇xS(x, r) = ∇f(x) + r1∇Ψ(x) = ∇f(x) + r2∇Ψ(x)

für alle r2 > r1 ≥ r, und es folgt sukzessive

0 = (r2 − r1)∇Ψ(x), 0 = ∇Ψ(x) sowie 0 = ∇f(x)

− im Widerspruch zur Voraussetzung ∇f(x) �= 0. �

Da wir uns in diesem Buch überwiegend auf Verfahren für glatte Optimierungsprobleme

beschränken, wollen wir an dieser Stelle nicht weiter auf Strafverfahren mit exakten

Straffunktionen eingehen. Wir werden jedoch im Abschnitt 4.5 im Rahmen unserer Aus-

führungen zu den SQP-Verfahren noch einmal auf die l1-Straffunktion zurückkommen

und wollen abschließend in Analogie zu den quadratischen Straffunktionen auch für

die exakten lq Straffunktionen den Zusammenhang mit der Sensitivitätsfunktion disku-

tieren. Wir betrachten auch hier wiederum ein Optimierungsproblem der Form(P≤

)mit zumindest stetigen Problemfunktionen f und G, zulässigem Bereich M �= ∅ sowieSensitivitätsfunktion λ. Für eine festgewählte lq-Norm und jedes r > 0 definieren wir

nun

ρ(r) := sup{ρ ∈ R

∣∣ ρ− r ‖b‖q ≤ λ(b)∀b ∈ Λ}

318 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

mit der Absicht, den Graphen der Sensitivitätsfunktion λ durch Funktionen der Form

κ : Rm → R mit κ(b) := ρ(r) − r‖b‖q

(also durch nach unten geöffnete Hyperkegel) zu „stützen“. Wiederum analog der vorher-

gehenden Schlussweisen folgt

ρ(r) = infx∈Rn

(f(x) + r‖ [G(x)]+ ‖

)= infx∈RnSqr (x)

mit Sqr : Rn → R und Sqr (x) := Sq(x, r) = f(x) + r

∥∥[G(x)]+∥∥q.

Vereinbaren wir nun

domΞ :=

{r > 0

∣∣∣∣ infx∈RnSqr (x) > −∞

}und

Ξ : domΞ→ R mit Ξ(r) := infx∈RnSqr (x) ,

so können wir durch

MAX {Ξ(r) | r ∈ domΞ}

ein weiteres „duales“ Problem zu (P ) formulieren, für welches

infx∈Mf(x) = λ(0) ≥ sup

r>0ρ(r) = sup

r>0infx∈RnSqr (x) = sup

r∈dom ΞΞ(r)

gilt. Offensichtlich ist auch die Funktion Ξ monoton wachsend. Im Gegensatz zur qua-

dratischen Straffunktion kann aber hier λ(0) = supr>0ρ(r) nach Satz 4.18 und Satz 4.19

bei konvexen Optimierungsproblemen bereits für endliches r erreicht werden, sofern der

Anstieg der Empfindlichkeitsfunktion λ in b = 0 längs aller Richtungen nach unten

beschränkt ist. Bei nichtkonvexen Problemen darf hierfür die Empfindlichkeitsfunktion

zusätzlich nicht stärker als linear fallen.

Beispiel 4.23

Wir betrachten erneut das primale Problem (P ) aus Beispiel 4.8 mit der globalen Lösung

x = (2, 0)T und λ(0) = 4. Für die Funktionen

κ : R → R mit κ(b) := ρ(r) − r|b|

gilt hier

ρ(r) =

{2r − r2

4 , falls 0 < r < 4

4 , falls 4 ≤ r.

�

Für tiefergehende Untersuchungen bzgl. Straffunktionen und Strafverfahren verweisen wir

auf Bertsekas (1982), Bertsekas (1999), Fiacco und McCormick (1968), Fletcher (1987),

Geiger und Kanzow (2002) sowie Großmann und Kleinmichel (1976).

4.3 Multiplikatorverfahren 319

−2 −1 0 1 2 3 4

−2

0

2

4

6

8

10

b

λκ, r = 10κ, r = 4κ, r = 2κ, r = 1λ(0)ρ(10)ρ(4)ρ(2)ρ(1)

Abb. 4.5 Sensitivitätsfunktion λ und stützende Funktionen κ für Beispiel 4.23

4.3 Multiplikatorverfahren

Die sogenannten Multiplikatorverfahren ähneln den im vorhergehenden Abschnitt be-

trachteten Strafverfahren. Sie sind jedoch bzgl. ihrer numerischen Eigenschaften vorteil-

hafter. Wir betrachten wiederum zunächst Problemstellungen der Form (P=) mit zwei-

mal stetig differenzierbaren Problemfunktionen f und H sowie zugehöriger Lagrange-

Funktion L : Rn ×Rp → R gemäß

L(x,v) := f(x) +H(x)Tv .

Für ein fest vorgegebenes r > 0 heißt die ebenfalls zweimal stetig differenzierbare Funk-

tion Lr : Rn ×Rp → R mit

Lr(x,v) := f(x) +H(x)Tv + r‖H(x)‖2

verallgemeinerte Lagrange-Funktion des Optimierungsproblems (P=). Offensichtlich

stimmt die verallgemeinerte Lagrange-Funktion mit der Lagrange-Funktion des Opti-

mierungsproblems

(P=)r MIN{Sr(x) := f(x) + r‖H(x)‖2

∣∣ H(x) = 0}

(4.7)

überein.

Ist nun (x, v) ∈ Rn ×Rp ein KKT-Punkt von (P=), dann gilt

∇xL(x, v) = ∇f(x) +∇H(x)v = 0 sowie ∇vL(x, v) = H(x) = 0 ,

320 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

und es folgt für die verallgemeinerte Lagrange-Funktion

∇xLr(x, v) = ∇f(x) +∇H(x)v + 2r∇H(x)H(x) = 0 .

Somit ist x gleichzeitig ein stationärer Punkt der Funktion

Lr,v : Rn → R mit Lr,v(x) := Lr(x, v) .

Ist in (x, v) für das Problem (P=) sogar das hinreichende Optimalitätskriterium 2. Ord-

nung nach Satz 2.32 erfüllt, d. h. gilt

dT∇2xL(x, v)d > 0

für alle d ∈ Rn \ {0} mit ∇H(x)Td = 0, so zeigt Satz 4.25, dass x nicht nur eine lokale

Lösung von (P=) ist, sondern für hinreichend große endliche Strafparameter r (analog

den exakten Straffunktionen) auch eine lokale Minimalstelle der Funktion Lr,v über Rn

ist. Zum Beweis dieser Aussage benötigen wir das folgende Lemma.

Lemma 4.24

Es seien P ∈ R(n,n) symmetrisch, Q ∈ R(n,n) positiv semi-definit und dTPd > 0 für alle

d ∈ Rn \ {0} mit Qd = 0. Dann existiert ein α > 0 mit P + αQ ∈ SPDn für alle α ≥ α.

Beweis: Angenommen, für jedes k ∈ N mit k ≥ 1 existiert ein dk ∈ Rn \ {0} mit

(dk)T (P + kQ)dk = (dk)TPdk + k(dk)TQdk ≤ 0

bzw.

(dk)TQdk ≤ −1k(dk)TPdk . (4.8)

O. B. d. A. gelte ‖dk‖ = 1 für alle k ≥ 1. Dann existiert eine konvergente Teilfolge

{dk(i)}i∈N von {dk}k∈N mit limi→∞dk(i) = d∗ �= 0. Mit (4.8) und aufgrund der positiven

Semidefinitheit der Matrix Q folgt

(d∗)TPd∗ ≤ 0 und (d∗)TQd∗ = 0 .

Weiterhin gilt jedoch auch

0 = (d∗)TQd∗ = (d∗)TQ12Q

12d∗ = ‖Q 1

2d∗‖2

und somit

Q12d∗ = 0 bzw. Qd∗ = 0

− im Widerspruch zur Voraussetzung, dass dTPd > 0 für alle d ∈ Rn \ {0} mit Qd = 0

gilt. �

4.3 Multiplikatorverfahren 321

Satz 4.25

Es seien f ∈ C2(Rn,R), H ∈ C2(Rn,Rp) und (x, v) ∈ Rn × Rp ein KKT-Punkt deszugehörigen Optimierungsproblems (P=). Ist in (x, v) das hinreichende Optimalitätskri-

terium 2. Ordnung nach Satz 2.32 erfüllt, so existiert ein r > 0, sodass x für alle r ≥ reine strikte lokale Minimalstelle der Funktion

Lr,v : Rn → R mit Lr,v(x) := f(x) +H(x)T v + r‖H(x)‖2

über Rn ist.

Beweis: Da (x, v) ∈ Rn×Rp ein KKT-Punkt von (P=) ist, gilt (wie bereits ausgeführt)

∇Lr,v(x) = ∇f(x) +∇H(x)v + 2r∇H(x)H(x) = 0 .

Wegen H(x) = 0 folgt weiterhin

∇2Lr,v(x) = ∇2xL(x, v) + 2r∇H(x)∇H(x)T .

Da in (x, v) das hinreichende Optimalitätskriterium 2. Ordnung nach Satz 2.32 erfüllt

ist, gilt

0 < dT∇2xL(x, v)d

für alle d ∈ Rn \{0} mit ∇H(x)Td = 0 bzw. ∇H(x)∇H(x)Td = 0. Mit P := ∇2xL(x, v)

und Q := ∇H(x)∇H(x)T existiert nach Lemma 4.24 ein r > 0 mit ∇2Lr,v(x) ∈ SPDn

für alle r ≥ r. Die Aussage des Satzes folgt nun unmittelbar mit Satz 2.5. �

Im Allgemeinen ist natürlich weder r > 0 noch der Lagrange-Multiplikator v be-

kannt. Aus diesem Grund muss bei der Implementierung von Multiplikatorverfahren

der optimale Lagrange-Multiplikator geeignet approximiert werden. Sind rk der aktuelle

Strafparameter, vk eine aktuelle Näherung von v und xk+1 ein stationärer Punkt von

Lrk,vk : Rn → R mit Lrk ,vk(x) := f(x) +H(x)Tvk + rk‖H(x)‖2 ,

dann gilt

∇Lrk,vk(xk+1) = ∇f(xk+1) +∇H(xk+1)

(vk + 2rkH(x

k+1))= 0 .

Da andererseits für einen KKT-Punkt (x, v) des Optimierungsproblems (P=)

∇xL(x, v) = ∇f(x) +∇H(x)v = 0

gilt, erscheint es naheliegend als neue Näherung für v

vk+1 := vk + 2rkH(xk+1)

zu wählen.

322 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

In Analogie zur Straffunktion wird durch den Term rk‖H(x)‖2 in Lrk,vk die Verletzung

der Nebenbedingung H(x) = 0 mit dem Ziel „bestraft“, dass sich die Iterierten dem

zulässigen Bereich nähern. Erfolgt in einer Iteration diese Annäherung an den zulässigen

Bereich (beispielsweise bzgl. der l∞-Norm) nicht hinreichend gut, so bietet es sich (in

Analogie zu den Strafverfahren) an, auch den Strafparameter rk+1 im Vergleich zu rk zu

erhöhen. Die bisherigen Betrachtungen motivieren den folgenden Prinzipalgorithmus für

Multiplikatorverfahren bei Problemstellungen der Form (P=).

Algorithmus 22 (Prinzipalgorithmus Multiplikatorverfahren (P=))S0 Wähle x0 ∈ Rn, v0 ∈ Rp, r0 > 0 sowie β ∈ (0, 1), und setze k := 0.

S1 Ist (xk,vk) ein KKT-Punkt von (P=), dann STOPP.

S2 Bestimme xk+1 ∈ arg minx∈RnLrk,vk (x) .

S3 Setze vk+1 := vk + 2rkH(xk+1).

S4 Gilt ‖H(xk+1)‖∞ ≥ β‖H(xk)‖∞, dann wähle rk+1 > rk.

S5 Gilt ‖H(xk+1)‖∞ < β‖H(xk)‖∞, dann setze rk+1 := rk.

S6 Setze k := k + 1, und gehe zu S1.

Offensichtlich besitzen die Probleme (P=) und (P=)r für alle r > 0 die gleichen lokalen

Lösungen. Ist (x, v) ∈ Rn×Rp ein KKT-Punkt von (P=), so ist unter den Voraussetzun-

gen von Satz 4.25 für alle r ≥ r die Hesse-Matrix ∇2Lr,v(x) in einer hinreichend kleinen

Umgebung von x positiv definit. Basierend auf dieser Beobachtung lassen sich mit Hilfe

des Satzes über implizite Funktionen die folgenden Differenzierbarkeitseigenschaften der

zugehörigen Familie von dualen Zielfunktionen beweisen.

Satz 4.26 (Bertsekas (1982))

Es seien f ∈ C2(Rn,R), H ∈ C2(Rn,Rm) und (x, v) ein KKT-Punkt von (P=), in dem

das hinreichende Optimalitätskriterium 2. Ordnung nach Satz 2.32 erfüllt ist. Weiterhin

seien ∇h1(x), · · · ,∇hp(x) linear unabhängig und r hinreichend groß. Dann existieren

ε(r) > 0 und δ(r) > 0, sodass für alle v ∈ Uδ(r)(v) eine lokale Lösung x(v) des Problems

MIN{Lr,v(x) | x ∈ Uε(r)(x)}

existiert und die (lokal definierte) duale Zielfunktion

qr(v) := infx∈Uε(r)(x)

Lr,v(x)

die folgenden Eigenschaften besitzt:

4.3 Multiplikatorverfahren 323

(a) qr ∈ C2(Uδ(r)(v),R),

(b) ∇qr(v) = H(x(v)),

(c) ∇2qr(v) = −∇xH(x(v))T [∇2xLr,v(x(v))]

−1∇xH(x(v)) und

(d) qr(v) = supv∈Uδ(r)(v)

q(v) = infx∈Uε(r)(x)

{Sr(x) | H(x) = 0}.

Wir bemerken, dass S3 im Algorithmus 22 mit Satz 4.26 (b) somit als ein Gradienten-

schritt zur Maximierung der (lokal konkaven) dualen Zielfunktion mit der (Konstant-)

Schrittweite 2r interpretiert werden kann. Der soeben formulierte Satz 4.26 bildet die

wesentliche Grundlage für tiefergehende Untersuchungen bzgl. der Multiplikatorverfah-

ren.

Wir wollen nun unsere bisherigen Überlegungen bzgl. der Multiplikatorverfahren auf

Optimierungsprobleme der Form(P≤

)mit zweimal stetig differenzierbaren Problem-

funktionen f und G übertragen. Für einen Vektor a ∈ Rm sei der Vektor [a]2 ∈ Rm

komponentenweise definiert durch

[a]2i := a2i mit i ∈ {1, · · · ,m} .

Durch die Einführung von zusätzlichen Variablen si ∈ R mit i ∈ {1, · · · ,m} lassen sichdie Ungleichungsnebenbedingungen gi(x) ≤ bi äquivalent als Gleichungsnebenbedingun-gen gi(x) + s2i = bi formulieren. Mit s := (s1, · · · , sm)T ist somit das Problem

(P≤

)äquivalent zu

MIN{f(x)| G(x) + [s]2 = 0} . (4.9)

Für ein fest vorgegebenes r > 0 lautet somit die verallgemeinerte Lagrange-Funktion

Lr : Rn ×Rm ×Rm → R von (4.9)

Lr(x,u, s) := f(x) + (G(x) + [s]2)Tu+ r‖G(x) + [s]2 ‖2 .

Die Minimierung der Funktion Lr bzgl. s liefert (siehe Aufgabe 4.9)

Lr(x,u) := mins∈Rm

Lr(x,u, s) = f(x) +m∑i=1

(ui(gi(x) + z

∗i ) + r (gi(x) + z

∗i )

2)

mit z∗i :=[−(ui2r + gi(x)

)]+. Für ein i ∈ {1, · · · ,m} gilt nun

ui(gi(x) + z∗i ) + r (gi(x) + z∗i )

2 =

{− 1

4ru2i , falls −

(ui2r + gi(x)

)≥ 0

uigi(x) + rg2i (x) , falls −(ui2r + gi(x)

)< 0

= 14r

(([ui + 2rgi(x)]+

)2 − u2i

),

324 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

und es folgt

Lr(x,u) = f(x) +1

4r

m∑i=1

(([ui + 2rgi(x)]+

)2 − u2i

).

Die so definierte und i. Allg. nur einmal stetig differenzierbare Funktion Lr : Rn×Rm →R heißt verallgemeinerte Lagrange-Funktion des Optimierungsproblems

(P≤

).

Definieren wir Lr,u : Rn → R mit Lr,u(x) := Lr(x, u) für festes u ∈ Rm, so können wirunter Beachtung von

∇Lr,u(x) = ∇f(x) +m∑i=1

[ui + 2rgi(x)]+∇gi(x) = ∇f(x) +∇G(x)[u+ 2rG(x)]+

den Prinzipalgorithmus 22 unmittelbar auf Problemstellungen der Form(P≤

)übertra-

gen.

Algorithmus 23 (Prinzipalgorithmus Multiplikatorverfahren(P≤

))

S0 Wähle x0 ∈ Rn, u0 ∈ Rm, r0 > 0 sowie β ∈ (0, 1), und setze k := 0.

S1 Ist (xk,uk) ein KKT-Punkt von(P≤

), dann STOPP.

S2 Bestimme xk+1 ∈ arg minx∈RnLrk,uk (x) .

S3 Setze uk+1 := [uk + 2rG(x)]+.

S4 Gilt ‖[G(xk+1)]+‖∞ ≥ β‖[G(xk)]+‖∞, dann wähle rk+1 > rk.

S5 Gilt ‖[G(xk+1)]+‖∞ < β‖[G(xk)]+‖∞, dann setze rk+1 := rk.

S6 Setze k := k + 1, und gehe zu S1.

Beispiel 4.27

Um die Arbeisweise einer Implementierung des Algorithmus 23 mit numerisch sinnvollen

Abbruchtoleranzen in S1 und S2 zu verdeutlichen, betrachten wir das Optimierungspro-

blem (Problem Nr. 109)

MIN

{f(x) =

10

3x1x2 +

1

6x1

∣∣∣∣ x21 +

5

2x2

2 ≤19

16, −x1 + x2 ≤

3

5

}mit globaler Lösung x =

(34 ,−

12

)Tund lokaler Lösung x ≈ (−0.325, 0.275)T. Im Schritt

S0 wählen wir x0 := (−0.8,−0.8)T , u0 := (0, 0)T , β = 0.25 und r0 := 5. Weiter-

hin verwenden wir zur Minimierung in S2 ein BFGS-Verfahren (innere Iterationen). In

der Abb. 4.6 sind oben links bzw. rechts die Höhenlinien der Zielfunktion f bzw. die

Höhenlinien der Funktion Lr0,u0 dargestellt. In der ersten äußeren Iteration liefert das

BFGS-Verfahren (bei voreingestellter grober Abbruchbedingung) den Punkt x1 als Nä-

herung für die lokale Minimalstelle von Lr0,u0 , und es ergeben sich u1 ≈ (0, 1.63)T sowie

4.3 Multiplikatorverfahren 325

r1 = r0 = 5. Die Höhenlinien der Funktion Lr1,u1 sind unten links dargestellt. Im zweiten

äußeren Iterationsschritt macht das BFGS-Verfahren zu Beginn der inneren Iteration in

S2 einen großen Schritt, umgeht dadurch die lokale Minimalstelle x ≈ (−0.319, 0.269)T

der Funktion Lr1,u1 in der Nähe von x, endet in unmittelbarer Nähe der gesuchten

Lösung x im Punkt x2 und liefert u2 = (1, 0)T . Da in dieser äußeren Iteration die Ver-

letzung der Restriktionen gemäß S4 nicht genug verringert wurde, wird darüberhinaus

r2 := 10r1 = 50 gesetzt. Unten rechts findet der Leser die entsprechende Abbildung für

die dritte äußere Iteration im vergrößerten Maßstab, wobei x3 der Lösung x im Rah-

men der Zeichengenauigkeit entspricht. Bei kleinen Änderungen des Startpunktes (z. B.

x0 = (−1,−1)T , r0 = 5) oder von r0 (z. B. x0 = (−0.8,−0.8)T , r0 = 6) konvergiert das

Verfahren gegen die lokale Lösung x. �

-1 -0.5 0 0.5 1

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

x1

x2

Lr( x , u ) = f(x), r u = 0, = [0,0]

-3

-3

-2

-2

-2

-1

-1

-1

-1

-0.5

-0.5

-0.5

-0.5

-0.2

5

-0.25

-0.2

5

-0.250

0 0

0

000.25

0.25

0.250.25

0.50.5

0.50.5

11

11

22

22

2.001

2.001

2.001

2.001

-1 -0.5 0 0.5 1

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

x2

Lr( x , u ), r u = 5, = [0,0]

-1

-1

-0.5-0

.5 -0.5

-0.5

-0.25-0

.25

-0.25

-0.25

-0.2

500

00

0 0

00

0.25

0.25

0.25

0.25

0.25 0.25

0.5

0.5

0.5

0.5

0.5

0.5 0.5

1

11

1

1

1

1

1

2

2 2

2

2

22

2

4

4 4

4

4

44

4

4.774.77

4.77

4.77 4.77

4.774.77

4.77

4.77 4.77

x1

x1

x0

-1 -0.5 0 0.5 1

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

x1

x2

Lr( x , u ), r u = 5, = [0,1.63]

-1

-1

-1

-0.5

-0.5

-0.25-0.25

-0.25

-0.250

0

0

0

0 0

0.25

0.250.25

0.25

0.5

0.5

0.5

0.5

0.5

1

11

1

1

11

2

2 2

2

2

22

2

4

4 4

4

4

44

x1

x2

BFGS durchtunnelt lokales Minimum0.7 0.72 0.74 0.76 0.78 0.8

-0.55

-0.54

-0.53

-0.52

-0.51

-0.5

-0.49

-0.48

-0.47

-0.46

-0.45

x1

x2

Lr( x , u ), r u = 50, = [1,0]

-1.12

-1.12

-1.1

2

-1.12

-1.12

-1.1

-1.1

-1.1

-1.1

-1.1

-1.1

-1.1

-1.1

-1.07

-1.07

-1.07

-1.07

-1.07

-1.07

-1.03

-1.03

-1.03

-1.03

-1.03

-1

-1

-1

-1

-1

-1

-0.9

-0.9

-0.9

-0.8

-0.8

-0.7

-0.7

-0.6

-0.6

-0.5-0.4

-0.3

-1.114

-1.114

-1.114

-1.114

-1.114-1.114

-1.114

-1.114

-1.114

-1.114

x3

x2

Abb. 4.6 Höhenlinien von f und Lrk,uk mit k = 0, 1, 2 für Beispiel 4.27

326 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Grundlegende Konvergenzbetrachtungen für Multiplikatorverfahren sind in Bertsekas

(1982) aufgeführt. Wir geben hier stellvertretend einen Konvergenzsatz für glatte konvexe

Probleme an, der auch als starker Dualitätssatz gedeutet werden kann. Dazu formulieren

wir zunächst ein modifiziertes Multiplikatorverfahren mit konstantem Strafparameter r.

Algorithmus 24 (Modifiziertes Multiplikatorverfahren für(P≤

))

S0 Wähle x0 ∈ Rn, u0 ∈ Rm sowie r > 0, und setze k := 0.

S1 Ist (xk,uk) ein KKT-Punkt von(P≤

), dann STOPP.

S2 Bestimme xk+1 ∈ arg minx∈RnLr,uk (x) .

S3 Setze uk+1 := [uk + 2rG(x)]+.

S4 Setze k := k + 1, und gehe zu S1.

Für dieses Verfahren gilt der folgende Konvergenzsatz:

Satz 4.28 (Großmann und Terno (1997))

Es seien f ∈ C1(Rn,R) sowie G ∈ C1(Rn,Rm) konvex über Rn und (x, u) ein Sattel-punkt der zugehörigen Lagrange-Funktion L. Dann ist (x, u) für beliebiges r > 0 auch

ein Sattelpunkt der verallgemeinerten Lagrange-Funktion Lr. Weiterhin ist jeder Häu-

fungspunkt der durch den Algorithmus 24 erzeugten Folge{xk

}k∈N eine Lösung des

zugehörigen Ausgangsproblems(P≤

).

Für nichtkonvexe Probleme benötigt man für einen Konvergenzbeweis des Algorithmus

24 weit schärfere zusätzliche Voraussetzungen, wie z. B. die strikte Komplementarität im

Lösungspunkt und die Erfüllung der linearen Unabhängigkeitsbedingung für die aktiven

Restriktionen. Diese beiden Bedingungen garantieren dann die zweifache stetige Diffe-

renzierbarkeit von Lr nach x, und ein Satz analog zu Satz 4.26 kann formuliert werden.

Im Gegensatz zur Anwendung auf konvexe Problemstellungen sind die Multiplikator-

verfahren trotz vorhandener Konvergenzbeweise bei nichtkonvexen Problemen weniger

erfolgreich (siehe Spellucci (1993)).

In Analogie zu den beiden vorhergehenden Abschnitten wollen wir auch für Multiplikator-

verfahren einen zweiten Zugang über die Sensitivitätsfunktion diskutieren. Wir betrach-

ten wiederum ein Optimierungsproblem der Form(P≤

)mit zweimal stetig differenzier-

baren Problemfunktionen f und G, zulässigem BereichM �= ∅ sowie Sensitivitätsfunktionλ. Für festes u ∈ Rm und festes r > 0 definieren wir zunächst

ρ(u, r) := sup{ρ ∈ R

∣∣∣ ρ− uT b− r ‖b‖2 ≤ λ(b) ∀ b ∈ Λ}

4.3 Multiplikatorverfahren 327

mit der Absicht, den Graphen der Sensitivitätsfunktion λ (falls möglich) nun durch qua-

dratische Funktionen

π : Rm → R mit π(b) := ρ(u, r) − uTb− r ‖b‖2

zu „stützen“. Analog der Schlussweisen in den beiden vorhergehenden Abschnitten und

den entsprechenden Ausführungen in diesem Abschnitt folgt

ρ(u, r) = infx∈Rn

(f(x) + inf

b∈Λ

{uTb+ r‖b‖2 | G(x) ≤ b

})= inf

x∈Rn

(f(x) + inf

s∈Rm

(uT

(G(x) + [s]2

)+ r‖G(x) + [s]2 ‖2

))= inf

x∈Rn

(f(x) + 1

4r

m∑i=1

([ui + 2rgi(x)]

2+ − u2

i

))= inf

x∈RnLr(x,u) .

Vereinbaren wir nun für r > 0

domΩr :=

{u ∈ Rm

∣∣∣∣ infx∈RnLr(x,u) > −∞

}und

Ωr : domΩr → R mit Ωr(u) := infx∈RnLr(x,u) ,

so können wir durch

MAX {Ωr(u) | u ∈ domΩr }

eine von r > 0 abhängige Familie von „dualen“ Problemen formulieren, für welche unter

zusätzlichen Voraussetzungen (beispielsweise Konvexität der Problemstellung mit erfüll-

ter Regularitätsbedingung) sogar für hinreichend große r

minx∈Mf(x) = λ(0) = ρ := max

u∈dom ΩrΩr(u)

gilt.

Beispiel 4.29

Wir betrachten nochmals das primale Problem (P ) aus Beispiel 4.8 mit der globalen

Lösung x = (2, 0)T , zugehörigem Lagrange-Multiplikator u = 4 und λ(0) = 4. Für die

mit u korrespondierenden quadratischen Funktionen

π : R → R mit π(b) := ρ(4, r)− 4b− rb2 ,

gilt offensichtlich ρ(4, r) = λ(0) = 4 für alle r ≥ 0. Es existieren also Parabeln, die den

Graphen von λ im Punkt 0 stützen, und der zugehörige Strafparameter r ist endlich (vgl.

Abb. 4.3). �

328 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

−2 0 2 4

−2

0

2

4

6

8

10

b

λπ, r = 10π, r = 4π, r = 2π, r = 1π, r=0λ(0)

Abb. 4.7 Sensitivitätsfunktion λ und stützende quadratische Funktion π für Beispiel 4.29

Bezüglich weiterer Ausführungen zu Multiplikatorverfahren verweisen wir auf Bertsekas

(1982), Bertsekas (1999), Fletcher (1987), Großmann und Kaplan (1979), Großmann und

Terno (1997) sowie Spellucci (1993).

4.4 Verfahren für quadratischeOptimierungsprobleme

In diesem Abschnitt wollen wir uns mit quadratischen Optimierungsproblemen beschäf-

tigen − der wohl einfachsten Klasse von nichtlinearen Optimierungsproblemen. Unter ei-

nem quadratischen Optimierungsproblem versteht man Problemstellungen mit einer qua-

dratischen Zielfunktion und (affin-)linearen Nebenbedingungen, also Problemstellungen

der Form

(QP≤=

)MIN

{f(x) = 1

2xTQx+ bTx+ c

∣∣∣∣∣ aTi x ≤ βi, i ∈ {1, · · · ,m}aTi x = βi, i ∈ {m+ 1, · · · ,m+ p}

},

(QP≤

)MIN

{f(x) = 1

2xTQx+ bTx+ c

∣∣ aTi x ≤ βi, i ∈ {1, · · · ,m} }bzw.

(QP=) MIN{f(x) = 1

2xTQx+ bTx+ c

∣∣ aTi x = βi, i ∈ {1, · · · , p} }mit symmetrischer Matrix Q ∈ R(n,n), b ∈ Rn, c ∈ R, ai ∈ Rn und βi ∈ R.

4.4 Verfahren für quadratische Optimierungsprobleme 329

Lemma 4.30

Es seien ai ∈ Rn und βi ∈ R für alle i ∈ {1, · · · ,m+ p}, sowie

M :=

{x ∈ Rn

∣∣∣∣∣ aTi x ≤ βi, i ∈ {1, · · · ,m}aTi x = βi, i ∈ {m+ 1, · · · ,m+ p}

},

dann ist für alle x ∈M die Regularitätsbedingung (CQ) erfüllt.

Beweis: Es seien x ∈M , I(x) ={i∣∣ aTi x = βi, i ∈ {1, 2, · · · ,m}} und somit

K(x) =

{y ∈ Rn

∣∣∣∣∣ aTi y ≤ 0, i ∈ I(x)aTi y = 0, i ∈ {m+ 1, · · · ,m+ p}

}.

Mit Lemma 2.15 genügt es zu zeigen, dass K(x) ⊂ T (M,x) gilt. Es seien dafür d ∈ K(x),d �= 0 und {xk}k∈N mit xk := x+ 1

kd. Für die so definierte Folge gilt

limk→∞xk = x und lim

k→∞xk − x‖xk − x‖ =

d

‖d‖ .

Weiterhin gilt für alle k und i ∈ I(x) bzw. i ∈ {m+ 1, · · · ,m+ p}

aTi xk ≤ βi bzw. aTi xk = βi

sowie für alle hinreichend großen k und i ∈ {1, 2, · · · ,m} \ I(x)

aTi xk = aTi x+

1

kaTi d < βi +

1

kaTi d ≤ βi .

Somit ist xk ∈M für alle hinreichend großen k und damit offensichtlich d ∈ T (M,x). �

Mit Satz 2.22 und Lemma 4.30 folgt unmittelbar:

Satz 4.31

Ist x eine lokale Lösung des Optimierungsproblems(QP≤=

), dann existieren Multiplika-

toren u ∈ Rm und v ∈ Rp, sodass (x, u, v) ein KKT-Punkt von(QP≤=

)ist.

Wir betrachten nun zunächst quadratische Optimierungsprobleme der Form (QP=) und

vereinbaren

A :=

⎛⎜⎜⎝aT1...

aTp

⎞⎟⎟⎠ ∈ R(p,n) und β :=

⎛⎜⎜⎝β1

...

βp

⎞⎟⎟⎠ ∈ Rp .

330 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Nach Satz 4.31 existieren zu jeder lokalen Lösung x von (QP=) Lagrange-Multiplikatoren

v ∈ Rp derart, dass (x, v) die zugehörigen KKT-Bedingungen(Q AT

A 0

)(x

v

)=

(−bβ

)(4.10)

erfüllt. Die Bestimmung eines KKT-Punktes für Problemstellungen der Form (QP=)

reduziert sich somit auf das Lösen eines linearen Gleichungssystems.

Satz 4.32

Für ein Optimierungsproblem der Form (QP=) sei dTQd > 0 für alle d ∈ Rn \ {0} mit

Ad = 0. Dann gilt:

(a) Ist (x, v) ∈ Rn × Rp ein KKT-Punkt des Optimierungsproblems (QP=), dann ist

x die eindeutig bestimmte globale Lösung von (QP=).

(b) Sind die Vektoren a1, · · · ,ap linear unabhängig, dann besitzt das Gleichungssystem(4.10) eine eindeutige Lösung (x, v)T und das Optimierungsproblem (QP=) somit

den eindeutig bestimmten KKT-Punkt (x, v) ∈ Rn ×Rp.

Beweis:

Zu (a): Für einen beliebigen zulässigen Punkt x von (QP=) mit x �= x gilt A(x− x) = 0

und somit wegen (4.10)

f(x) = f(x) + 12xTQx+ bTx− 1

2 xTQx− bT x

= f(x) + 12 (x− x)

TQ (x− x) + (Qx+ b)T (x− x)

> f(x) + (Qx+ b)T (x− x)= f(x)− vTA (x− x)= f(x) .

Zu (b): Offensichtlich genügt es wegen (a) zu zeigen, dass das zu (4.10) korrespondierende

homogene lineare Gleichungssystem(Q AT

A 0

)(x

v

)=

(0

0

)

nur die triviale Lösung x = 0 und v = 0 besitzt. Angenommen es gilt dTQd > 0 für alle

d ∈ Rn \ {0} mit Ad = 0, Qx+ATv = 0 und Ax = 0, dann folgt

xTQx+ xTATv = xTQx+ vTAx = xTQx = 0

4.4 Verfahren für quadratische Optimierungsprobleme 331

und somit sowohl x = 0 als auch ATv = 0. Da nach Voraussetzung die Vektoren

a1, · · · ,ap linear unabhängig sind, folgt weiterhin rangA = rangAT = p und somit

ebenfalls v = 0. �

Setzen wir x = xk + d mit Axk = β, so erhalten wir als äquivalente Formulierung

zu (4.10) (Q AT

A 0

)(d

v

)=

(−b−Qxk

β −Axk

)bzw. (

Q AT

A 0

)(d

v

)=

(−∇f(xk)

0

). (4.11)

Diese Darstellung wird sich für unser weiteres Vorgehen, speziell bei der Herleitung und

Formulierung eines iterativen Verfahrens zur Lösung von quadratischen Problemstellun-

gen der allgemeinen Form(QP≤=

), als nützlich erweisen.

Wir betrachten nun Problemstellungen der Form(QP≤=

)und vereinbaren

A(1) :=

⎛⎜⎜⎝aT1...

aTm

⎞⎟⎟⎠ ∈ R(m,n) und β(1) :=

⎛⎜⎜⎝β1

...

βm

⎞⎟⎟⎠ ∈ Rm

bzw.

A(2) :=

⎛⎜⎜⎝aTm+1

...

aTm+p

⎞⎟⎟⎠ ∈ R(p,n) und β(2) :=

⎛⎜⎜⎝βm+1

...

βm+p

⎞⎟⎟⎠ ∈ Rp.

Wiederum nach Satz 4.31 existieren nun zu jeder lokalen Lösung x von(QP≤=

)Lagrange-

Multiplikatoren u ∈ Rmund v ∈ Rp derart, dass der Vektor (x, u, v) die zugehörigenKKT-Bedingungen

(Q (A(1))T (A(2))T

A(2) 0 0

)⎛⎜⎜⎝x

u

v

⎞⎟⎟⎠ =

(−bβ(2)

), A(1)x ≤ β(1), u ≥ 0 und uTA(1)x = 0

erfüllt. Die Lösung dieses Systems von linearen Gleichungen und linearen Ungleichungen

zur Bestimmung eines KKT-Punktes (x, u, v) ist im Vergleich zur Lösung des linearen

Gleichungssystems (4.10) erheblich schwieriger. Dies liegt darin begründet, dass für eine

unbekannte Lösung x natürlich auch die Indexmenge der aktiven Ungleichungsneben-

bedingungen unbekannt ist. Die wesentliche Idee zur Bestimmung eines KKT-Punktes

(x, u, v) eines Optimierungsproblems der Form(QP≤=

)mittels der sogenannten Strate-

gie der aktiven Indizes besteht nun darin, iterativ gleichungsrestringierte quadratische

332 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

Hilfsprobleme zu lösen, die sich dadurch ergeben, dass in einem aktuellen und zulässigen

Iterationspunkt xk von den m Ungleichungsnebenbedingungen lediglich eine Teilmenge

der in xk aktiven Ungleichungsnebenbedingungen berücksichtigt werden. Mit

I(xk) ⊂ I(xk) :={i∣∣ aTi xk = βi, i ∈ {1, 2, · · · ,m}}

lautet also das im Iterationspunkt xk betrachtete Hilfsproblem

(QP=)k MIN

{f(x) =

1

2xTQx+ bTx+ c

∣∣∣∣ A(1)k x = β

(1)k , A

(2)x = β(2)

},

wobei die Matrix A(1)k aus A(1) bzw. der Vektor β(1)

k aus β(1) durch Streichen aller Zeilen

aTi bzw. aller Komponenten βi mit i ∈ {1, · · · ,m}\ I(xk) unter Beibehaltung der Zeilen-bzw. Koordinatenindizes i ∈ I(xk) entstehen. Analog der vorhergehenden Ausführungenerfüllt jeder KKT-Punkt (xk+1, uk+1,vk+1) ∈ Rn × R|I(x

k)| × Rp dieses Hilfsproblemsdas Gleichungssystem⎛⎜⎜⎝

Q (A(1)k )T (A(2))T

A(1)k 0 0

A(2) 0 0

⎞⎟⎟⎠⎛⎜⎜⎝x

u

v

⎞⎟⎟⎠ =

⎛⎜⎜⎝−bβ

(1)k

β(2)

⎞⎟⎟⎠ ,welches mit x = xk + d analog (4.11) äquivalent zu⎛⎜⎜⎝

Q (A(1)k )T (A(2))T

A(1)k 0 0

A(2) 0 0

⎞⎟⎟⎠⎛⎜⎜⎝d

u

v

⎞⎟⎟⎠ =

⎛⎜⎜⎝−∇f(xk)

0

0

⎞⎟⎟⎠ (4.12)

ist. Es seien nun (dk, uk+1,vk+1) ∈ Rn × R|I(xk)| × Rp eine Lösung von (4.12) (wobei

die Koordinatenindizes von uk+1 entsprechend den Zeilen- bzw. Koordinatenindizes von

A(1)k bzw. β(1)

k gewählt werden) sowie (dk,uk+1,vk+1) ∈ Rn×Rm×Rp mit uk+1i := uk+1

i

für alle i ∈ I(xk) und uk+1i := 0 für alle i ∈ {1, · · · ,m} \ I(xk). Weiterhin setzen wir im

Folgenden dTQd > 0 für alle d ∈ Rn \ {0} mit A(2)d = 0 voraus, womit xk + dk nach

Satz 4.32 (a) die eindeutig bestimmte globale Lösung von (QP=)k ist.

Zur Herleitung eines iterativen Verfahrens (siehe auch Fletcher (1971)) zur Bestimmung

eines KKT-Punktes des ursprünglichen Problems(QP≤=

)mittels der Strategie der akti-

ven Indizes analysieren wir die hierbei auftretenden Fälle:

Gilt dk = 0 und uk+1 ≥ 0, so ist (xk,uk+1, vk+1) auch ein KKT Punkt von(QP≤=

).

Ist dk = 0 und uk+1i < 0 für mindestens einen Index i ∈ I(xk), so erfüllt (xk,uk+1,vk+1)

nicht die KKT-Bedingungen von(QP≤=

). Da jedoch in diesem Fall xk die eindeutig be-

stimmte globale Lösung von (QP=)k ist, bietet es sich an, für das im nächsten Iterations-

schritt zu betrachtende Hilfsproblem den zulässigen Bereich zu vergrößern, d. h. einen

Index aus der Menge I(xk) zu entfernen. Als Wahl für diesen zu entfernenden Index

4.4 Verfahren für quadratische Optimierungsprobleme 333

bietet sich ein Index j ∈ I(xk) mit minimalen Lagrange-Multiplikator uk+1j an.

Gilt dk �= 0 und ist xk +dk zulässig für das ursprüngliche Problem(QP≤=

), so erscheint

es wegen

f(xk + dk) = f(xk) +∇f(xk)Tdk + 12

(dk

)T ∇2f(xk)dk

= f(xk)−(uk+1

)TA

(1)k d

k −(vk+1

)TA(2)dk − 1

2

(dk

)TQdk

= f(xk)− 12

(dk

)TQdk

< f(xk)

naheliegend, (xk+1,uk+1, vk+1) mit xk+1 := xk + dk zu setzen und für das (evtl.) im

nächsten Iterationsschritt zu betrachtende Hilfsproblem die Indexmenge I(xk) nicht zu

verändern.

Ist schließlich dk �= 0 und xk + dk nicht zulässig für das ursprüngliche Problem(QP≤=

),

dann existiert wegen der Zulässigkeit von xk, der Wahl von I(xk) und (4.12) mindestens

ein Index i ∈ {1, · · · ,m} \ I(xk) mit aTi dk > 0. Setzen wir nun (xk+1,uk+1, vk+1) mit

xk+1 := xk + tkdk und

tk = min

{βi − aTi xk

aTi dk

∣∣∣∣ i ∈ {1, · · · ,m} \ I(xk), aTi dk > 0} ∈ [0, 1) ,so gilt f(xk+1) = f(xk) +

(12t2k − tk

) (dk

)TQdk < f(xk) falls tk ∈ (0, 1), aTi xk+1 ≤ βi

für alle i ∈ {1, · · · ,m} \ I(xk), aTi xk+1 = βi für alle i ∈ I(xk), aTi xk+1 = βi für alle

i ∈ {m+1, · · · ,m+p} und somit die Zulässigkeit von xk+1 für das ursprüngliche Problem(QP≤=

). Ferner gilt aTj x

k+1 = βj für jedes j ∈ {1, · · · ,m} \ I(xk) mit aTj dk > 0 und

tk =βj − aTj xk

aTj dk.

In diesem Fall erscheint es nun naheliegend für das (evtl.) im nächsten Iterationsschritt

zu betrachtende Hilfsproblem, die Indexmenge I(xk) um einen solchen Index j zu er-

weitern. Diese vollständige Fallunterscheidung motiviert den folgenden Algorithmus für

quadratische Problemstellungen der Form(QP≤=

)mit nichtleerem zulässigen Bereich:

Algorithmus 25 (Strategie der aktiven Indizes für(QP≤=

))

S0 Bestimme ein für(QP≤=

)zulässiges x0 ∈ Rn und zugehörige Lagrange-Multiplika-

toren u0 ∈ Rm und v0 ∈ Rp, setze

k := 0 sowie I(x0) :={i∣∣ aTi x0 = βi, i ∈ {1, 2, · · · ,m}

}.

S1 Ist (xk,uk, vk) ein KKT-Punkt von(QP≤=

), dann STOPP.

S2 Bestimme eine Lösung (dk, uk+1,vk+1) von (4.12), und setze

uk+1i := uk+1

i für alle i ∈ I(xk) sowie uk+1i := 0 für alle i ∈ {1, · · · ,m} \ I(xk) .

334 4 Lösungsverfahren für Optimierungsprobleme mit Nebenbedingungen

S3 Ist dk = 0 und uk+1 ≥ 0, dann setze

xk+1 := xk, I(xk+1) := I(xk) ,

und gehe zu S7.

S4 Ist dk = 0 und uk+1i < 0 für mindestens ein i ∈ I(xk), dann bestimme einen Index

j ∈ I(xk) mituk+1j = min

{uk+1i

∣∣ i ∈ I(xk)} ,setze

xk+1 := xk, I(xk+1) := I(xk) \ {j} ,

und gehe zu S7.

S5 Ist dk �= 0 und xk + dk zulässig für(QP≤=

), dann setze

xk+1 := xk + dk, I(xk+1) := I(xk) ,

und gehe zu S7.

S6 Ist dk �= 0 und xk + dk nicht zulässig für(QP≤=

), dann bestimme einen Index

j ∈ {1, · · · ,m} \ I(xk) mit

βj − aTj xk

aTj dk

= min

{βi − aTi xk

aTi dk

∣∣∣∣ i ∈ {1, · · · ,m} \ I(xk), aTi dk > 0} ,setze

tk :=βj − aTj xk

aTj dk, xk+1 := xk + tkd

k, I(xk+1) := I(xk) ∪ {j} ,

und gehe zu S7.

S7 Setze k := k + 1, und gehe zu S1.

Beispiel 4.33

Wir betrachten das Optimierungsproblem (Problem Nr. 122)

MIN

⎧⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎨⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎩f(x) =

1

2(x2

1 + x22) + 2x1 + x2

∣∣∣∣∣∣∣∣∣∣∣∣∣∣∣∣

g1(x) = −x1 − x2 ≤ 0

g2(x) = x2 − 2 ≤ 0

g3(x) = x1 + x2 − 5 ≤ 0

g4(x) = −x1 + x2 − 2 ≤ 0

g5(x) = x1 − 5 ≤ 0

g6(x) = x2 − 1 ≤ 0

⎫⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎬⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎭.

4.4 Verfahren für quadratische Optimierungsprobleme 335

Die Tab. 4.1 und die Abb. 4.8 veranschaulichen die Arbeitsweise des Algorithmus 25. �

xk I(xk) dk+1 u1 u2 u3 u4 u5 u6 Bemerkung

x0 {3, 5} = 0 0 0 < 0 0 < 0 0 x1 = x0

x1 {3} �= 0 x1 + dk /∈Mx2 {2, 3} = 0 0 > 0 < 0 0 0 0 t1 < 1, x3 = x2

x3 {2} �= 0 x3 + d4 /∈Mx4 {2, 4} = 0 0 < 0 0 > 0 0 0 t4 < 1, x5 = x4

x5 {4} �= 0 x5 + d6 /∈Mx6 {1, 4} = 0 > 0 0 0 < 0 0 0 t6 < 1, x7 = x6

x7 {1} �= 0 x7 + d8 ∈Mx8 {1} = 0 > 0 0 0 0 0 0 Lösung

Tab. 4.1 Aktive Mengenstrategie für Beispiel 4.33

−3 −2 −1 0 1 2 3 4 5 6−3

−2

−1

0

1

2

3

4

5

6

x1

x2

−2.374

−2.25

−2

−2 −1.5

−1.5

−0.5

−0.5

−0.5

1.5

1.5

5.5

5.5

5.5

13.5

13.5

13.5

13.529.5

29.5

29.5

x0=x1

d1= 0

x1+d2